SC18において、産業技術総合研究所(産総研)の関口智嗣 理事がABCI(AI Bridging Cloud Infrastructure)について招待講演を行った。ご存知のように、ABCIはTop500では世界7位であり、日本国内ではトップの日本を代表するスパコンである。ABCIは2018年6月26日に記者発表などが行なわれたが、今回はSC18という世界の舞台での正式発表とも言える講演である。

なお、産総研の英語名はNational Institute of Advanced Industrial Science and Technologyで、略称はAISTである。

産総研の前身は、明治24年に発足した電気試験所で、1952年にリレー式のETL Mark Iコンピュータ(試作機)を開発、1957年には次の写真の左上に写っているトランジスタ方式のETL Mark IVを完成させている。その後も1987年にはデータフロー型のSigma-1を開発するなど、日本のコンピュータ開発の中で長い歴史を誇っている。また、1987年にはCray-XMPの導入、1998年にはDEC Alphaクラスタを導入するなどコンピュータの利用でも先端の研究所である。

-

産総研はその前身である電気試験所時代を含めると、コンピュータの開発や利用に関して、長い歴史を持ち、かつ先端を走っている研究所である (このレポートのすべての図は、SC18における産総研の関口理事の招待講演の発表スライドを撮影したものである)

ABCIで解析するものは、

- エネルギー、環境

- ライフサイエンスやバイオ

- 情報テクノロジとヒューマンファクタ

- 物質と化学

- エレクトロニクスと製造

などの分野である。なお、この研究には、産総研地質調査総合センターや計量標準センターも参加している。

人工知能に関するグローバル研究拠点整備には200億円の補正予算が投じられた。その内でABCIの建設に使われたのは50億円である。

ABCIは世界初のオープンな大規模AI基盤設備であり、130-200 AI Flopsの性能を3MW以下の電力で実現し、PUEは1.1以下(コンピュータの消費電力に比べて、冷却を含めた総電力は1.1倍以下)である。そして、AIやビッグデータアルゴリズムやアプリケーション開発や実行に使用するオープンな基盤であり、日本のAIに関する学会と産業界の協力を加速するためのプラットフォームである。

-

AI性能は130-200PFlopsの世界でもトップレベルのAIとビッグデータ向けのオープンなデータセンターである。日本の学会と産業界のAIのR&Dを加速するプラットフォームである。なお、ABCIの設置場所は東大のキャンパスなので、東大のロゴが付いている

ABCIセンターは1階建ての低コストの建物である。建屋の面積は18m×24m、高さは8mである。床はハードコンクリートで2トン/m2の荷重に耐えられる。

この建屋には最大144本のラックを収容できるが、現在、設置されているのは90本である。電力供給能力は最大3.25MWで、冷却能力は3.2MWである。

データセンター棟は簡単な構造なので、建設は6か月以下で完成した。

ラックは背の高い特別なもので、関口理事と比べて、次の写真のように見える。

計算ノードは1088ノードあり、総AI演算性能は550PFlopsを超え、476TiBのメモリと1.6PBのNVMe SSDを搭載する。ストレージはDDNのSFA14Kで構成されるGPFSで22PBの容量を持つ。

ノード間を接続するインタコネクトはEDRのInfiniBandである。

計算ノードはCPUとしてXeon Gold 6148を2個使い、それにNVIDIAのV100 GPUを4個接続している。CPUとGPUはAsetekのコールドヘッドで水冷されている。

サーバルームの中は、ラック、水冷パイプ、空冷のダクト、ケーブルなどを通すスケルトンフレームとなっている。35℃の冷却水を供給し、ラックからの排水は40℃という設計でサーバルームの中は非常に暑い。ラック当たり最大70kWの消費電力で、そのうちの60kWを水冷し、残りの10kWは空冷している。

この図には書かれていないが、40℃の水はクーリングタワーで35℃に冷却されてサーバラックに戻るので、冷却にはコンプレッサーは使っておらず必要な電力は小さくPUEが非常に小さい冷却システムとなっている。

-

サーバラックの消費電力は70kWで、その内の60kWを水冷している。サーバラックの上にFan Control Unitがあり、空冷分の10kWで温まった空気を35℃の水で冷却する。その上には冷却水のパイプが配置されている

CPUやGPUの熱は35℃の水で冷却され、40℃に温まった水はコンピュートラックの上にあるパイプを通って屋外のクーリングタワーに送られて30℃に冷却されてラックに戻る。一方、10kWの空冷分はラックの上に置かれたとFan Control Unitで冷却するいうハイブリッドの冷却システムになっている。

-

コールドヘッドで吸収した熱は、屋外のクーリングタワーで冷却される。蒸発冷却であるので、夏でも気温より低い温度まで水温を下げられる。サーバの空冷部分の熱はFCUで水冷されて、サーバラックに戻される。直接の水冷がメインであるが、水冷の難しい部分では空冷を使うハイブリッドな冷却系となっている

次の写真はサーバルームの建設の初期の段階で、コンクリートのフロアにスケルトンフレームが組み立てられている。

前の写真からフレームの建設が進んだ状態である。キャップフレームを支える中二階が作られている。

次のグラフはグランドチャレンジのジョブを実行した2018年の7月22日から26日の給排水の水温を示したものである。今年の日本の夏は猛暑であったが、サーバルームからの排水は40℃以下で、クーリングタワーで冷却された水は最高でも32℃以下であり、この冷却システムは、計算ノードを酷使するグランドチャレンジの最中でも、最高気温は40℃に達した日本の猛暑に耐えられることを実証した。

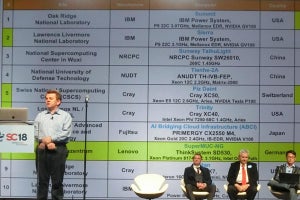

そして、ABCIはHPLで19.88PFlopsをマークしてTop500で7位、HPCGでは508.85TFlopsで5位にランクされた。電力効率を競うGreen500では14.423GFlops/Wで4位にランクされている。

日本は、80年代の第2次AIブームに第5世代コンピューティングプロジェクトを立ち上げ、90年代にはReal World Computing Partnershipを立ち上げた。そして、2010年台の第3次AIブームを支えるインフラストラクチャとして、ABCIを立ち上げた。

AIは産業界を変革しつつあり、政府は強力にその推進を後押ししている。しかし、産業界では、まだ、CEOがどうすれば良いかと悩んでいる状況である。

そのCEOの背中を押し、ユーザである産業界やシステムを開発、提供するIT業界が必要とする環境を提供するのがABCIであり、ABCI無しに日本での急速なAIの普及は期待できないと言っても過言ではない。

歴史的に、日本のAIに対するアプローチでは、基盤の整備とソフトウェア開発を行ってきた。ABCIはTop500などで高いランキングを獲得するためではなく、日本の社会の必要性を満たすために開発されたものである。

産総研では、ABCIのフルシステムである1088ノード、4352GPUを24時間使うグランドチャレンジのプロポーザルを募集している。2018年の募集はすでに締め切られ、2019年1月の最後の週に実行される予定である。しかし、今後もグランドチャレンジのプロポーザル募集は続ける予定であるので、次回は提案を考えておいていただきたいとしている。

なお。次のグラフはImageNet/ResNet-50の学習時間の記録の推移を示すものである。これまでの記録は中国のTencentがTesla P100 QGPUを2048個使って6.6分で学習したというものであるが、2018年11月にSonyとABCI/AISTのチームがABCI全体の半分の2176GPUを使ってImageNet/ResNet-50の学習を224秒(3.7分)で行うという世界最高速の学習を達成した。