国内最大(Top500ランキング5位)のスパコンである産業技術総合研究所(産総研/AIST)の「AI Bridging Cloud Infrastructure(ABCI)」が8月1日に運用を開始した。550PetaOpsという膨大なAI処理能力を研究者や開発者に提供することにより、我が国のAIやビッグデータ処理の進歩を加速しようという狙いである。

8月10日追記:本稿初出時、ABCIの運用開始日を7月30日と記載しておりましたが、正しくは8月1日からとなりますので当該箇所を修正させていただきました。

このABCIスパコンは、東京大学(東大)の柏IIキャンパス内の東大と産総研の共同施設に設置されている。なお、柏キャンパスには国内2位のOakforest-PACSが設置されており、筑波エクスプレスの柏の葉キャンパス駅付近は、スパコン銀座となっている。

次の写真は、ABCIスパコンが設置されたAIデータセンター棟の玄関付近の写真であるが、周囲は、まだ、工事中で、なんとか運用開始に間に合わせた感がいっぱいである。なお、記者発表などで産総研が示した写真では、玄関前は舗装され、周囲には芝生が敷かれているが、これはCGで作った完成予想図である。

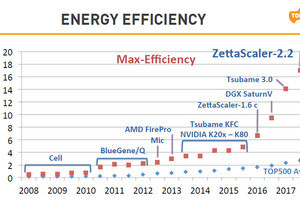

ABCIスパコンは32℃という比較的温度の高い水で冷却を行うスパコンで、スパコンの冷却に必要な電力が少ないグリーンなスパコンである。実はこの方式の冷却を行っているスパコンは世界でも少なく、国内では東京工業大学(東工大)のTSUBAME3.0に次いで2台目である。筆者は東工大のTSUBAME3.0の記者発表にも行ったのであるが、東工大のセンターは狭いので、センター見学はできなかった。そのため、高温水冷のスパコンは今回のABCIが初体験であった。

訪問した日は猛暑日で、無意識に体が、従来の20℃前後の涼しいコンピュータルームを期待していたので、室温35℃のコンピュータルームはショックであった。案内をしていただいた産総研の人工知能研究センターの人工知能クラウド研究チームの小川研究チーム長も半袖、半ズボンで首にはタオルという出で立ちであった。

国内最大のABCIスパコンの概要

次のスライドは、ABCIシステムの概要を示すものである。64bit浮動小数点演算(FP64)のピーク演算性能が37.2PFlopsは、京コンピュータの3.5倍程度の性能である。Top500のランキングを行うHPL性能としては19.88PFlopsを出し、これは世界5位で、国内では1位である。また、12.054GFlopsをマークし、電力当たりのHPL性能を競うGreen500では世界で第8位となった。

そして、AIが名前についているように、AIの計算で使われる16bit浮動小数点演算(FP16)では550PFlopsという圧倒的な性能を持っている。計算ノードは2個のXeon Gold 6148 CPUと4個のTesla V100 GPUからなり、ABCIシステム全体では1088計算ノードを持っている。ABCIのメモリは476TiBでストレージのバッファとなる174PBのNVMeのSSDを備えている。大容量ストレージは22PBの容量のGPFSファイルシステムである。

-

ABCIシステムの概要。AI計算に使われるFP16の計算では550PFlopsと圧倒的に高い性能を持つ。FP64演算は37.2PFlopsで、Top500のランキングに使われるHPLでは19.88PFlopsを達成し、世界で5位、国内では1位の性能を持つ (出典:この連載に使われているすべての学会発表スライドのコピーは、産総研の人工知能研究センターの小川宏高氏から提供を受けたものである)

CPUとGPUのハイブリッド計算ノード

ABCIスパコンの計算ノードはXeon 6148 Gold CPU 2チップとV100 GPU 4個から構成されている。次の図に見られるように、19インチラックの半幅の1Uのシャシーが2段積みで1つのノードを形成している。

奥の方の4つのオレンジの丸いものが付いているのが4個のV100を搭載するシャシーで、手前の2個のオレンジの丸が付いているのが2個のXeon CPUである。この2つのシャシーは、動作させるときには重ねるのであるが、この写真ではCPUとGPUが見えるようにずらせて置いてある。計算ノードは、この2つのシャシーのペアで構成され、富士通のPrimergy 2750 M4ベースユニットには2ノードが収容される。

なお、オレンジの丸が付いているのはASETEKの水冷用のコールドプレートであり、接続されている冷却水のパイプの一部が写真にも見られる。

ABCIスパコンは、この計算ノードを1088個持ち、それに加えて、通常の計算ノードからGPUを除いてDDR4 DRAMを3倍搭載する汎用ノードを10ノード持っている。

ノードの内部構成は次の図のようになっており、CPUとGPUの間はPCIe3.0 x16で接続されている。この写真では小さすぎてはっきり見えないが、CPUボードの左側の上と下の辺にPCIe3.0 x16を接続するコネクタがあり、CPUボードの上にGPUボードを載せると、CPUボードとGPUボードが接続されるようになっている。

4個のGPU間の接続は、2本のNVLink2を並列にしてバンド幅を増やしている。そして、各CPUにはPCIe3.0 x16でInfiniBandのEDR HCAが接続されている。さらに、ファイルデータのバッファなどに使う1.6TBのNVMe SSDはPCIe経由で一方のCPUに接続されている。

右上の写真の上側に写っているのはCPUシャシーの水冷モジュールで、オレンジの丸の上下にある3本のバーのように見えるものは、DIMMを冷却するコールドプレートである。

そして、次の図に示すように、100Gbit/sのEDRのInfiniBandで計算ノード間を接続している。ABCIは、富士通のPrimergy 2750 M4ベースユニットに2ノードを収容し、1つのラックにベースユニットを17台収容している。

-

計算ノードはCPUボード(上)とGPUボード(下)のペアで構成されている。GPUボードは2つのPCIe3.0×16でCPUボードに接続される。4個のGPUはNVLink2 2本ずつで全対全接続されている

ABCIの計算ノードラック

次の写真は、ラックのバック側のドアを開けたところである。計算ノードの間にリーフのInfiniBandスイッチが搭載されているが、ケーブルでおおわれており、良く見えない。

ラックの右側に見える鈍い黒色のパイプは冷却水の配管である。左側のケーブルはラック内のサーバとスイッチ間のInfiniBandの接続と考えられる。そして、中央から出ている白い光ファイバの束はラック間をまたぐ信号のケーブルである。

なお、ラックには17台のPrimergy 2750 M4と7台のInfiniBandのリーフスイッチと冷却水を扱うRack CDU(Cooling Distribution Unit)が搭載されており、このラックは少なくとも2×17+1×7+4=45Uの搭載スペースが必要である。ということで標準よりも背の高いラックが使われている。

(次回は8月8日に掲載します)