東京工業大学(東工大)は12月2日、同大が11月1日より稼動を開始したスーパーコンピュータ(スーパーコンピュータ)「TSUBAME2.0」の披露式を開催した。

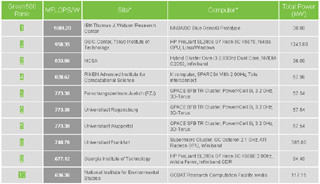

TSUBAME2.0は既報のとおり、2010年11月版のスパコン性能ランキングTop500において4位にランクイン、電力効率のランキングGreen 500listにおいては2位に入り、実運用のスパコンとしては世界でもっともグリーンなスパコンとして認定されている。

TSUBAMEが同大に導入されたのは2006年。その際より、「みんなのスパコン」「常に進化するスパコン」という2つの理念を持ち、現在までTSUBAME1.0(2006年)→同1.1(2007年)→同1.2(2008年)→同2.0(2010年)と性能向上を果たしてきた。

|

|

|

東京工業大学 学術国際情報センタ-の松岡聡教授 |

同大学術国際情報センタ-の松岡聡教授は、「日本のTop500におけるシェアは年々下がり2009年には3%、PFlopsクラスのスパコンは1つもない。一方、米国はPFlopsクラスのスパコンをさまざまなアーキテクチャにより達成しており、日本もPFlopsクラスのスパコンを京だけに任せるのではなく研究していく必要を感じていた」と語る。

TSUBAME2.0はそうした意味では、日本で初めて1PFlops超えを達成したスパコンとなったわけだが、「決してカタログに載っていたものを買ってきて作り上げたわけではない」(同)であり、従来より研究してきたさまざまな基礎研究の成果などを各所に盛り込んだ形での実現となった。

特に大きな性能向上を果たす役割となったGPUの応用については、「HPCには計算密度とメモリアクセス密度の両方が求められる。従来はスカラ型で計算速度の向上を図り、メモリアクセス密度の向上はベクトル側で行っていた。しかし、ベクトル型は高価であり、一方のスカラ型もCPUの数を増やすことで計算密度の向上を図っていたが、システムとしての規模の肥大化、それに伴う電力の増大が問題となることが分かっており、その解決策としてGPUの活用に向けた基礎研究を行ってきた」とする。

また、GPUの性能をスパコンとして発揮するためのネットワークI/Oの強化なども研究対象とし、「従来ベクトルスパコンで用いられていた手法などをCPU+GPUのスパコンにも取り入れる」といったことなどが行われたという。

こうしてさまざまな基礎研究の成果と多くの企業との協力によりTSUBAME2.0が出来上がったわけだが、その特徴を松岡氏は、「世界トップクラスの性能はもとより、世界1位の環境配慮型"グリーンスパコン"、そして学内外の多くの人たちに活用してもらうための"クラウド型スパコン"としての機能なども併せ持たせた」とするほか、「企業では、こうした先進的な、いわゆる冒険はできないわけで、学術的な立場の我々が研究的な側面も含めて、先行して実証して、より多くの人にGPUスパコンの道を開こうという思いで開発してきた」と振り返る。

LINPACKでは理論ピーク性能2.4PFlopsに対し実行性能1.192PFlopsを達成し、「ようやく世界のトップクラスの性能に到達できた。今後、10PFlops級のスパコンも登場してくるでしょうが、2010年のこの時にできたことが非常に重要」と、今回の意義を語る。

また、TSUBAME2.0は、非常に高密度実装であり、TSUBAME1.2に比べてその設置面積は2/3と縮小しながらも大幅な性能向上を実現している。性能向上の要因の1つはGPUの活用であることは間違いないが、大規模ノードになると、GPU間の通信時間がネックとなる。このことは以前より松岡氏や同大学術国際情報センターの青木尊之教授などが指摘していたが、今回は「約3500本の光ファイバで各ノード間を相互に結合させた」(松岡氏)という。配線の長さは100km程度で、こうしたやり方については、「京よりもむしろ地球シミュレータに近いやり方を採用した」とする。

さらに、ストレージも約200TBのSSDと7.13PBのHDDの組み合わせに、今後約8PBのテープストレージが接続される予定で、合算すると15PBという全国大学基盤センター群を合算した数倍の容量を誇ることとなる。

加えてTSUBAME2.0のラックは熱交換システムを内蔵した密閉式水冷システムを採用。そのため、スパコンルームには、基本的に大型の空調設備が見当たらず、エアコンは人間用の物が設置されているだけであった。

|

|

|

|

TSUBAME2.0はラックが2列に並んだ部屋が2つとストレージの部屋が1つで構成。GPU+CPUの高密度ラックは水冷による冷却であるため、それほど騒がしくないし、空気の対流もあまり感じない。 |

こちらGPU+CPUのラック背面側。ロッカーが整然と並んでいるようにしか見えないが、この中に本体のほかに冷却のための機構が色々と入っている |

なお、スパコンはEFlopsの実現に向けた研究開発が世界各地で始まっている。「今、日本は京の建設を頑張っているが、米国を始め、欧州や中国もEFlops級のスパコンに向けた研究を始めつつあり、このままいくと日本は周回遅れになる可能性もある」と松岡氏は指摘、「ポイントはさらなる電力効率の向上ということを全世界の誰もが分かっているが、その一方でこれならできるというものがあるわけではない。ただ、いかにデータを動かさないで局所化して計算するかという点が重要となるが、これについても並列数が何十億という世界になるので、一筋縄ではいかない。管理するソフトウェア側も大変なこととなる。ハードウェア側としてどうしていくかについては、いくつかのアイデアがあるので、今後の研究でそうした課題の解決をしていきたい」とし、北海道大学および情報・システム研究機構 国立情報学研究所(NII)との3機関連携協定による省エネ計算技術の開発などの活用も含めて、さらなる進化を目指していくとした。