Googleはこのほど、同社の提供する「Googleウェブマスターツール」において、新しいrobots.txtテストツールを発表した。

robots.txtとは、Googleなどの検索結果にどのページを載せてどのページを載せないか(クロールさせるかどうか)をルールとして表記したもの。このテストツールを使うことで、特定のURLが、どのルールによってGoogle検索に載せない設定になっているかなどをチェックできる。

このrobots.txtの編集をより簡単にするために、テストツールが強化された。新しいテストツールは、Googleウェブマスターツールの「クロール」セクションから利用できる。同ツールは古いバージョンのrobots.txtにも対応しているほか、特定のURLがサーバー側の問題でクロールがブロックされている状況も確認できる。

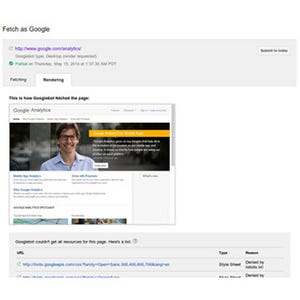

また、同ツールを他の機能と組み合わせて使うことで作業をより効率よく進められ、たとえば「Fetch as Google」機能でWebサイトの重要ページをレンダリングしてブロックされたURLが見つかったときに、robots.txtテストツールでURLのブロック原因をチェックして修正することができる。