先週行われたNVIDIAの決算発表は、日米のハイテク株を牽引し、世界経済への大きな影響を見せつけた。生成AIの出現以来、市場の拡大スピードは異様にも見えるが、「AI市場はまだ黎明期にある」というのが大方の見方だ。

2024年は、この市場で一人勝ちのNVIDIAによる供給ではカバーしきれない半導体需要を満たすいろいろなオプションが次々と出現する年となる。昨年、NVIDIAへのチャレンジに名乗りを上げたAMDを始め、大手各社がそのプランを打ち出している。

AI半導体独り勝ちNVIDIAの次の一手はカスタムチップ戦略

先週の2024年度第4四半期(2023年11月-2024年1月)での発表で、前年同期比で3.7倍増という驚異的な売り上げ(純利益は8.7倍増)を記録したNVIDIAは、需要が供給を上回る状態が今年も続くと予想している。しかし、その驚異的なNVIDIAの成長率は2つの理由で鈍化しそうだ。

1つが、米国政府による対中輸出規制により世界最大の市場である中国への輸出に制限が大きくかかっている事である。一時は、規制条項をかわすために性能をダウングレードした中国向け製品を出荷していたが、これも米政府により阻止された。そのような状態が続いている中、中国ではHuaweiがここ数年AI半導体の開発に力を入れ、ファウンドリのSMICによる微細加工と組み合わせたAIアクセラレーター製品「Ascend」でゆくゆくはNVIDIAに追い付き追い越す計画だ。すでに発表された製品はNVIDIAのA100に性能は及ばないものの、背に腹は代えられない大手顧客Baiduが大規模な採用に踏み切ったという報道があった。同じ海外メディアで報道されたのが、NVIDIAがカスタム仕様のAI半導体(SoC)を設計するチームを立ち上げるという話である。大手プラットフォーマーは自社のワークロードに特化したアクセラレーターを自社設計しており、大きな電力を消費する高額な汎用品をNVIDIAから調達する方向性を見直す時期に来ている。その需要をもNVIDIAがカスタムSoCで取り込もうという戦略である。長年の半導体設計の経験と豊富なIPを考えると、価格次第では十分あり得る話だ。この戦略はNVIDIAにとってAI半導体でのポジションを維持するのには役に立つが、利益率にはネガティブに働く可能性がある。

システム・ファウンドリでAI半導体にフォーカスするIntel

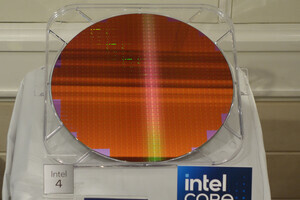

TSMCに対抗する巨大ファウンドリビジネスの構築を目指すIntelは先週、これに特化する初のイベント「IFS (Intel Foundry Service)Direct Connect」を開催した。かねてより、CEOのPat Gelsingerが熱っぽく語っていたIntelのファウンドリビジネスの全容、業界からのサポートといった観点から注目されたイベントだった。まず気が付いたのはGelsingerが「システム・ファウンドリ」という言葉を繰り返し使っていたことだ。シリコンの微細加工ロードマップとして2024~25年にかけて「Intel 18A」と呼ぶ2nm以下の最先端技術を完成させて、現在この分野で他を寄せ付けないTSMCに追い付き追い越す、と宣言した。この内容はIntelの過去の発表でも公言されていたが、今回のイベントでかなり明確にされたことは、IFSがフォーカスする市場分野がAI半導体であることである。その決意を裏打ちする業界からのサポート表明が各方面から寄せられたが、その中でも目を引いたのがOpenAIのCEOのSam AltmanとMicrosoftのCEO、Satya Nadellaの登壇である。

今を時めくChatGPTにおける2人のキーマンはAI業界を代表する立場として、Intelのシステム・ファウンドリ事業に大きく期待しているという最大のエールを送った。

半導体ファブレス企業の大手の代表が登壇するのではないかと思っていた私にとっては意外な結果であった。Gelsingerがシリコン・ファウンドリではなく、システム・ファウンドリという言葉をあえて使用している理由が分かったように思った。Gelsingerは微細加工プロセスに関する説明よりも、大規模・複雑化する先進パッケージング技術についてより多くの時間を割いた。チップレットを始めとする大規模なSoCのパッケージ技術は今後のAI半導体の主流となる。Gelsingerの「今後のすべてのAI半導体の生産を請け負いたい」、という意欲的な宣言は非常に印象に残った。

AI半導体用のHBMで手を組むTSMCとSK hynix

そんな中、SK hynixとTSMCは「AIセミコンダクター・アライアンス」を締結した。

HBM(High Bandwidth Memory:広帯域メモリー)はプロセッサーとメモリー間で超高速なデータ転送を可能とするDRAMである。伝送速度、バス本数、帯域幅などの面で「高速データ転送」だけにフォーカスするこの特殊なDRAMへの需要はAIプロセッサーの性能向上とともに急激に伸びている。しかし、高密度配線と垂直方向のメモリー積層技術であるTSV(Through Silicon Via)を駆使するこのメモリーの開発はまだ発展途上にある。この分野に早い時期から注目し、開発ノウハウを蓄積したSK hynixは、チップレットを始めとする大規模なパッケージ技術のノウハウを取り込むのに積極的なTSMCと組むことによって、今後のAI半導体のシステムレベルでの主導権を握っていこうとする戦略をとる。このタッグは、メモリー市場とロジックファウンドリ市場で両社と競合関係となるSamsungにとってはかなりの脅威となると予想される。

AI半導体コアのさらなる発展と、チップレットに代表されるマルチチップの高密度なパッケージ・ソリューションが今後のAI半導体の大きなトレンドとなることは間違いない。