結果のばらつきの確認

ここまでやったので、ついでに結果のばらつきについても確認しておきたい。これまでも、3DMark11やそれ以前のテストを行った際に、結果のばらつきが案外に多いのが特徴である。まぁCPUやらGPUやらの負荷状況に影響を及ぼすパラメータは恐ろしく多いから、複数回のテストで毎回同じ値が出ることは絶対にありえないのだが、どの程度バラけるかは気になる部分だ。そこで全てのテストを10回行ってみた。テスト環境はこれまでもちょろちょろ出ているが、

・CPU: Intel Core i7-3960X

・M/B: Intel DX79SI

・Memory: DDR3-1600 2GB×2

・Video: AMD Radeon HD 7970(GHz Editionではない)+Catalyst 13.2β

・HDD: Intel SSD 520 128GB(他に記録用にHGST 500GB SATA)

・OS: Windows 8 Pro 64bit日本語版

という環境である。

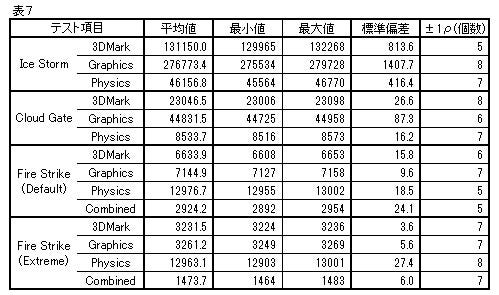

Ice StormとCloud Gateは完全にデフォルトのまま、Fire StrikeはデフォルトとExtreme Profileの両方である。さて、その結果をまとめてみたのが表7である。それぞれのScoreについて平均値と最大値・最小値以外に標準偏差ρを算出してみた。一般に、ある値のばらつきが正規分布に従っているとするとすると、平均値±ρの範囲に全体の68.26%の値が含まれているとされる。今回の場合はテストを10回行っているから、平均値±ρの範囲に含まれるScoreが7つあれば、概ね正規分布に従ってると考えられる。

|

表7 |

で、実際はどうか? というのが表7の一番右の列になるわけだが、微妙に芳しくないところである。一応Cloud Gateに関してはかろうじて正規分布に近いといえるが、Ice StormやFire Strikeでは正規分布よりももう少し広く値が分散しているようだ。

勿論、10回くらいで判断するなという至極真っ当な声が来るだろうとは思うが、現実問題として3DMark「だけ」を1日中廻している訳にはいかない。この10回のテストには2時間ほど費やしており、もっと時間の掛かるベンチマークを行う事が多い実情を考えると、実際はもう少し減らさないとテストが立ち行かないかも、というレベルである。とりあえず、1回データを取っただけでは全然信用できない、という事は明確になったとは思う。

次ページ:考察