IBMは6月14日(米国時間)、127個の超伝導量子ビットで構成される同社のプロセッサ「Eagle」を用いて、量子コンピュータが古典コンピュータを超える正確な結果を導き出せることを初めて実証したと発表した。詳細は、英科学誌「Nature」に掲載された。

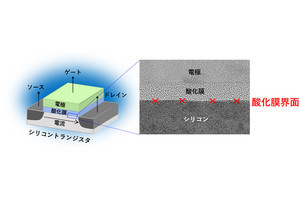

量子コンピューティングの究極の目標の1つに、古典コンピュータでは決して効率的に行えない、物質の構成要素のシミュレーションの実現がある。これらをモデル化できるようになることは、より優れた電池の製造や新薬の創出などの課題に取り組むための重要なステップとなる。しかし、今日の量子システムは本質的にノイズが多く、パフォーマンスを阻害するエラーが大量に発生してしまっていた。これは、量子ビットの壊れやすい性質や、その環境からの外乱によるものが原因であるという。

そうした中でIBMの研究チームは今回、システム内のエラーを学習して軽減させることで、量子コンピュータが最先端の古典シミュレーションを凌駕できることを実証したという。その手法としては、Eagleプロセッサを用いて物質モデルのスピンのダイナミクスをシミュレートし、その磁化などの特性を正確に予測する、大規模なもつれ状態を生成させたのである。

このモデリングの正確性を検証するため、米・カリフォルニア大学バークレー校の科学者チームは、米・ローレンス・バークレー国立研究所の国立エネルギー研究科学計算センター(NERSC)と、米・パデュー大学の運用する高度な古典コンピュータを用いて、シミュレーションを同時に実施したとのこと。その結果、モデルの規模が大きくなるにつれて、量子コンピュータは高度なエラー軽減技術を用いて正確な結果を出し続けたが、古典コンピュータは最終的に行き詰まり、IBMの量子システムには及ばないという結果になったという。

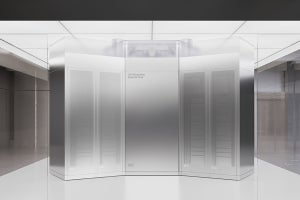

また同社は、今回の成果に続き、クラウド上で稼働するIBM Quantumシステムおよびパートナー拠点のオンサイトで稼働するIBM Quantumシステムが、最低でも127量子ビットのプロセッサにアップグレードされることも発表。

これらのプロセッサは、特定のアプリケーションにおいて、古典的な方法を凌駕するほど大きな計算能力を提供し、コヒーレンス時間の改善やエラー率の低減を実現するという。このような能力と進化を続けるエラー軽減技術が組み合わさることで、IBMの量子コンピュータは、同社が「ユーティリティー・スケール(実用規模)」と呼ぶ新しい閾値に到達することができるとしている。実用規模とは、量子コンピュータが、古典的なシステムでは決して解決できないかもしれない新しい規模の問題を探求する科学ツールとして機能する可能性があるポイントである。