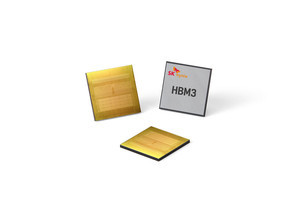

TrendForceによると、2022年の高帯域幅メモリ(HBM)サプライヤ別シェアはSK hynixが50%、Samsung Electronicsが40%、Micron Technologyが10%となったという。

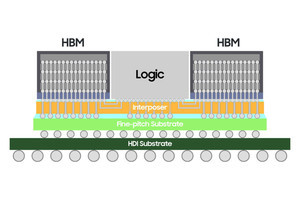

ディープラーニング用に設計されたハイエンドGPUを搭載するAIサーバサプライヤからの需要が伸びているほか、2023年下半期にNVIDIA H100およびAMD MI300の市場投入が予定されており、主要サプライヤ3社ともにHBM2と比べ、ピン当たりのデータレートが2倍に相当する6.4Gbps、デバイス当たり819GBpsを実現する次世代規格品であるHBM3の大量生産を進めることが予想されるという。

中でもSK hynixはすでにHBM3の大量生産を他社に先駆けて開始していることから、その市場シェアは2023年に53%まで拡大するとTrendForceでは予想している。残るSamsungとMicronは、2023年末から2022年初頭での大量生産開始を予定しており、2023年のHBM市場シェアはそれぞれ38%、9%に留まるとも予想している。

2023年のAIサーバ出荷量は前年比15.4%増

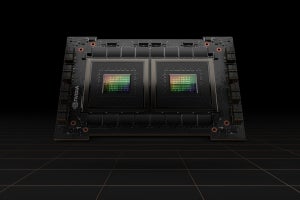

NVIDIAのAIサーバは、平均で4つまたは8つのハイエンドグラフィックスカードと2つのメインストリームx86サーバCPUが搭載されており、主にGoogleやAWS、Meta、Microsoftなどの米国のトップクラウドサービスプロバイダ(CSP)などで活用されている。こうしたハイエンドGPGPUを搭載したサーバの出荷量は2022年で前年比約9%増と見られ、その出荷量の約80%が米国ならびに中国の8つの主要CSP向けであったという。

2023年は、Microsoft、Meta、Baidu、ByteDanceがジェネレーティブAIの製品とサービスを立ち上げることから、AIサーバの出荷数はさらに伸びることが期待され、その出荷量は同15.4%増となるとTrendForceでは予想しているほか、2023年から2027年までのAIサーバ出荷数の年平均成長率(CAGR)について12.2%と予測している。

また、TrendForceでは、AIサーバの台頭により、メモリの容量に対する需要が高まる可能性も指摘している。一般的なサーバではサーバDRAMが500~600GBほど搭載されるが、AIサーバでは、平均で1.2~1.7TBのメモリ容量が必要とされる。エンタープライズSSDの場合、AIサーバの高速性が要求されるため、DRAMまたはHBMが優先されるが、SSDのメモリ容量を拡大するという目立った動きはまだ見られないとTrendForceでは分析する一方、インタフェースに関しては、高速コンピューティングのニーズに対応する場合、PCIe 5.0の方が有利であるとする。さらに、AIサーバにGPUが搭載される傾向から、NVIDIA A100 80GBが4つもしくは8つ用いる構成の場合、HBMの合計容量は約320GB~640GBとなるが、AIのモデルがますます複雑になるにつれて、サーバDRAM、SSD、およびHBMの需要も増加していくこととなり、半導体の消費量増加に寄与することが予想されるとしている。