米国時間の2023年1月10日、Intelは第4世代Xeonスケーラブル・プロセッサおよびXeon Maxをオンライン形式で発表した。これに先立ち、詳細情報が公開されているので、これを基にちょっとご紹介したい。

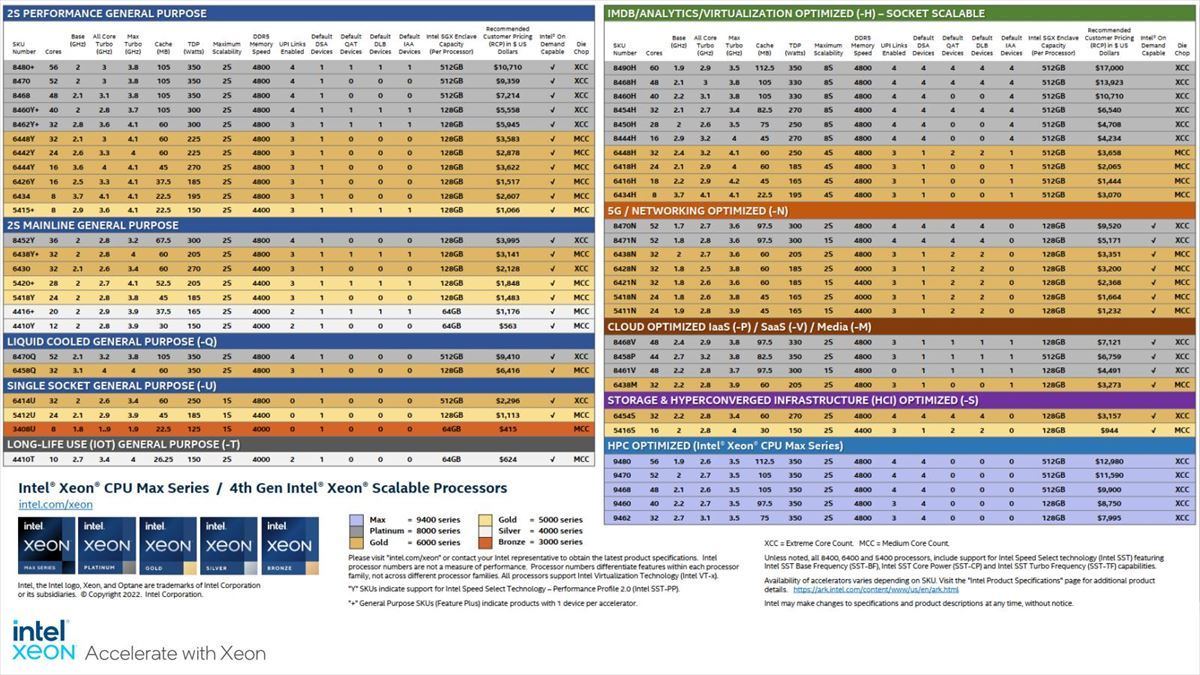

第4世代Xeonスケーラブル・プロセッサおよびXeon Maxは、Sapphire Rapids(開発コード名)として知られていた製品である。当初のスケジュールから1年以上遅延しての投入であるが、それもあってかラインナップが異様に充実しているのが特徴である。実際製品は10のカテゴリに分かれ、合計52製品にも及ぶ。具体的には

- 2S Perfomance General Purpose:11

- 2S Mainline General Purpose:7

- Liquid Cooled General Purpose(-Q):2

- Subgke Socket General Purpose(-U):3

- Long-life use(IoT) General Purpose(-T):1

- IMDB/Analytics/Virtualization Optimized(-H):10

- 5G/Networking Optimized(-N):7

- Cloud Optimized IaaS/SaaS/Media(-P/-V/-M):4

- Storage & HCI Optimized(-S):2

- HPC Optimized:5(Xeon Max)

という分類になっている。

これに加えて従来のPlatinum/Gold/Silver/Bronzeのグレード分けも残る関係で、ラインナップが非常に複雑である。Photo01がSKU一覧であるが、結構膨大なリストになっているのがお分かりいただけるかと思う。

このうち、第4世代Xeonスケーラブル・プロセッサとXeon Maxの違いであるが、詳しくは後述するとして最大の違いはHBM2eをパッケージに実装するか否かである。つまりHBM2eを搭載するものがXeon Max、しないものが第4世代Xeonスケーラブル・プロセッサとなる。

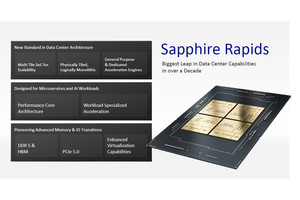

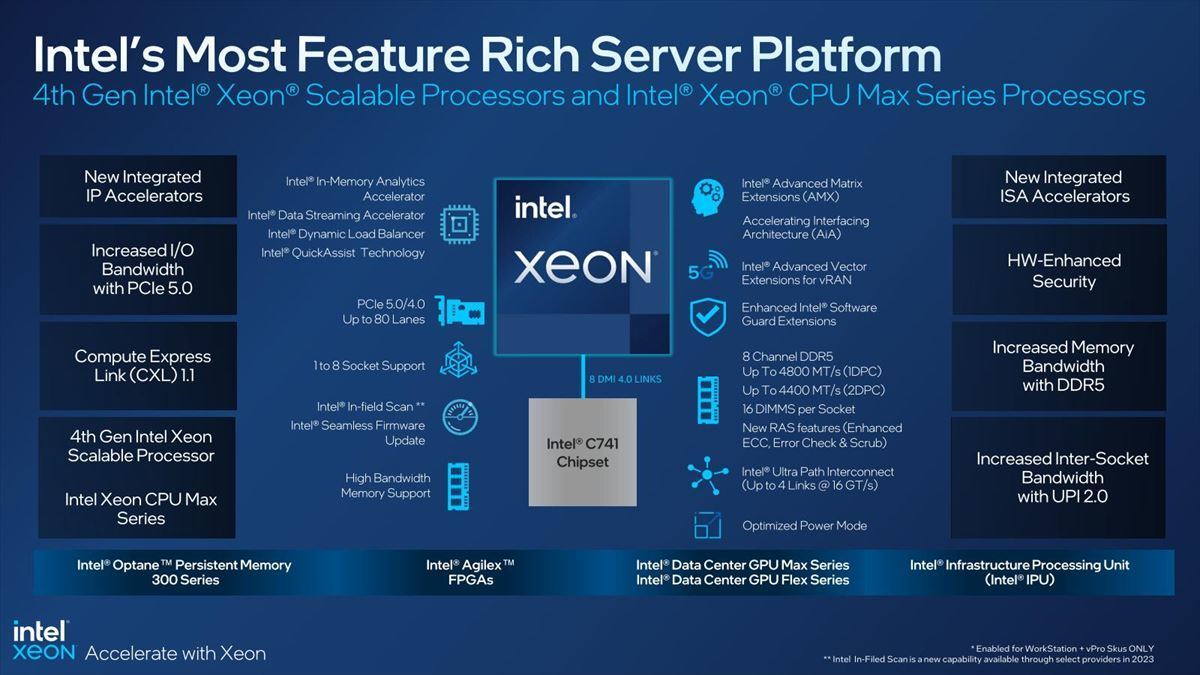

ところでPhoto02がこの第4世代Xeonスケーラブル・プロセッサとXeon Maxの主要な特徴であるが、細かく内容を説明する前にちょっと左下を見ていただくと判るが、“Intel Optane Persistent Memory 300 Series”とあるのが判るかと思う。

-

Photo02:チップセットはEmmitsburgことC741 Chipsetが利用される。皮肉ではあるが、C741 Chipset自身は2022年第1四半期から出荷開始されている

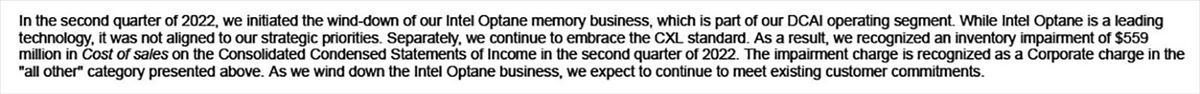

2022年7月29日、Intelは第2四半期の決算報告を行った際に、Form 10-Q(四半期業績報告書)に注記の形でOptaneのビジネスを畳むことを表明(Photo03)し、実際第2四半期では5億5900万ドルの在庫減損を計上している。

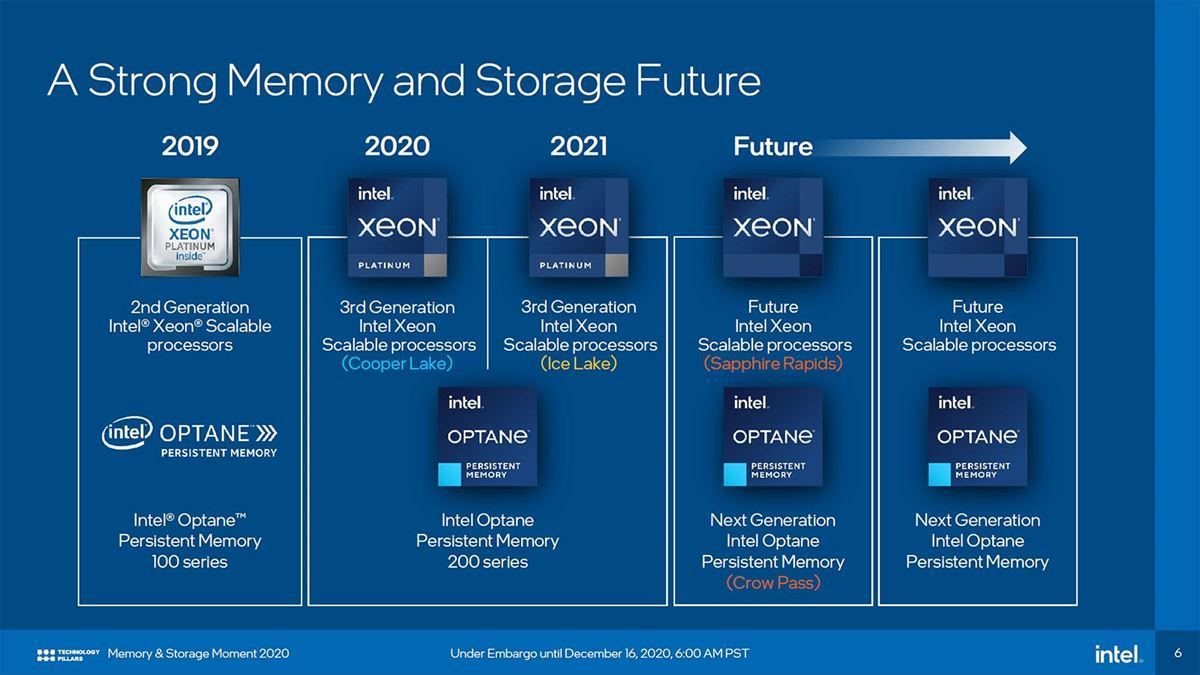

これによりOptane SSDのみならずOptane Persistent Memoryのビジネスが急速に縮小すると予測された訳だが、ただこの注記では「既存の顧客との契約は継続される見込みである」としており、Optane Persistent Memory 100/200シリーズは引き続き提供される事が明らかになっていた。問題はSapphire Rapids向けに開発が行われていたCrow Passこと次世代Optane Persistent Memoryである(Photo04)。

-

Photo04:これは2020年12月に行われたMemory and Storage 2020イベントでAlper Ilkbahar(当時の肩書はVP&GM, Intel Optane Group。昨年よりWDに移籍された)が示したスライド

この「既存の顧客との契約は継続される」にCrow Passが含まれるのか、この記述でははっきりしなかったからだ。ただVMware vSphere Blogの2022年8月28日のエントリには“Intel will also continue development of the Intel Optane persistent memory (PMem) 300 series (codenamed "Crow Pass") on 4th Gen Intel Xeon Scalable processors (codenamed "Sapphire Rapids").”とあり、300 Seriesは命脈を保ったようにも見えた訳だが、何しろIntelの公式の発表ではない。今回スライドに明確にOptane Persistent Memory 300 Seriesが出現した事で、DDR5に対応したOptane Persistent Memoryがリリースされる事が明らかになった形だ。

さてその第4世代Xeonスケーラブル・プロセッサとXeon Maxのもう少し詳細な特徴をまとめたのがこちら(Photo05)。

従来Xeon Scalable(やその前のXeon)では、

- LCC:Low Core Count

- MCC:Middle Core Count

- XCC:Extreme Core Count(かつてはHCC:High Core Countと称していた時期もあった)

の3種類のダイが存在していたが、今回はLCCがなくなりMCCとXCC、それとXCC+HBM2eという3種類の構成になった。

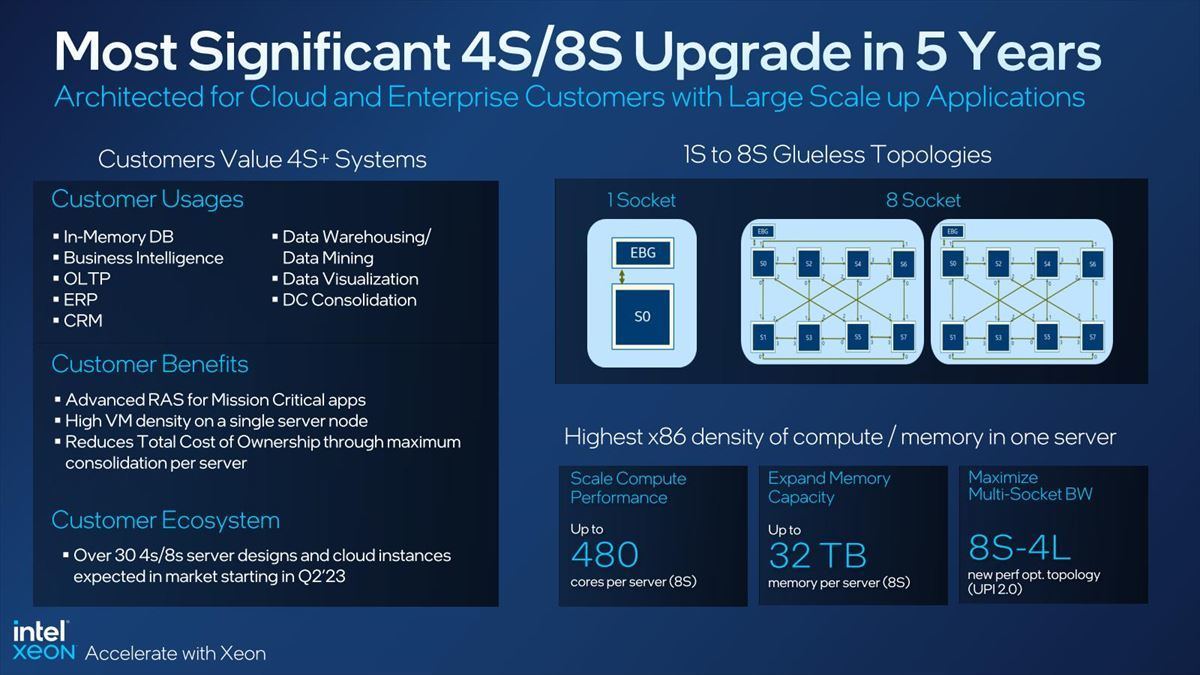

ここでMCCはMonolithic構成で最大32coreとなっており、要するにXeon Gold/Silver/BronzeはほぼすべてがMCCを利用する。一方XCCであるが、最大15coreのダイを4つ組み合わせる格好になる。そしてHBMはHBM I/Fのために1core分が減ってダイあたり14coreになる計算だ。ただ全ての製品で8chのDDR5 Memoryが利用可能で、また80 LaneのPCIe 5.0が利用できる。CXL 1.1 Deviceは4つまで接続可能である。またMCCを含めてUPIが搭載され、MCCとHBMでは4 Socket、XCCでは8 Socketまでの構成が可能となっている。最近は特にScale-out用途では2 Socketのサーバーを広く繋ぐ方が主流であるが、まだProprietaryな用途が完全に無くなった訳ではなく、そうした用途にはScale-upの構成が求められるケースが多い事を考えると、引き続き最大8 Socketまで対応できるというのは悪い話ではない(Photo06)。

ところで第4世代Xeonスケーラブル・プロセッサとXeon Maxでは様々な機能拡張がある。まずは新しいAMXというMatrix演算命令である。AMXの概要は以前こちらで説明したが、Tileと呼ばれる新しい2次元レジスタと、このTileを読み込んで行列演算を行うTMUL Engineから構成される。このAMXは、構造的にはCPUのPipelineとは別に構成される、いわばAcceleratorという形であるが、後述するAcceleratorとは異なり、これはSapphire Rapidsの必須要件の1つとなっている。つまり全ての第4世代Xeonスケーラブル・プロセッサとXeon MaxはAMXが追加コスト無しで利用できる様になっている。

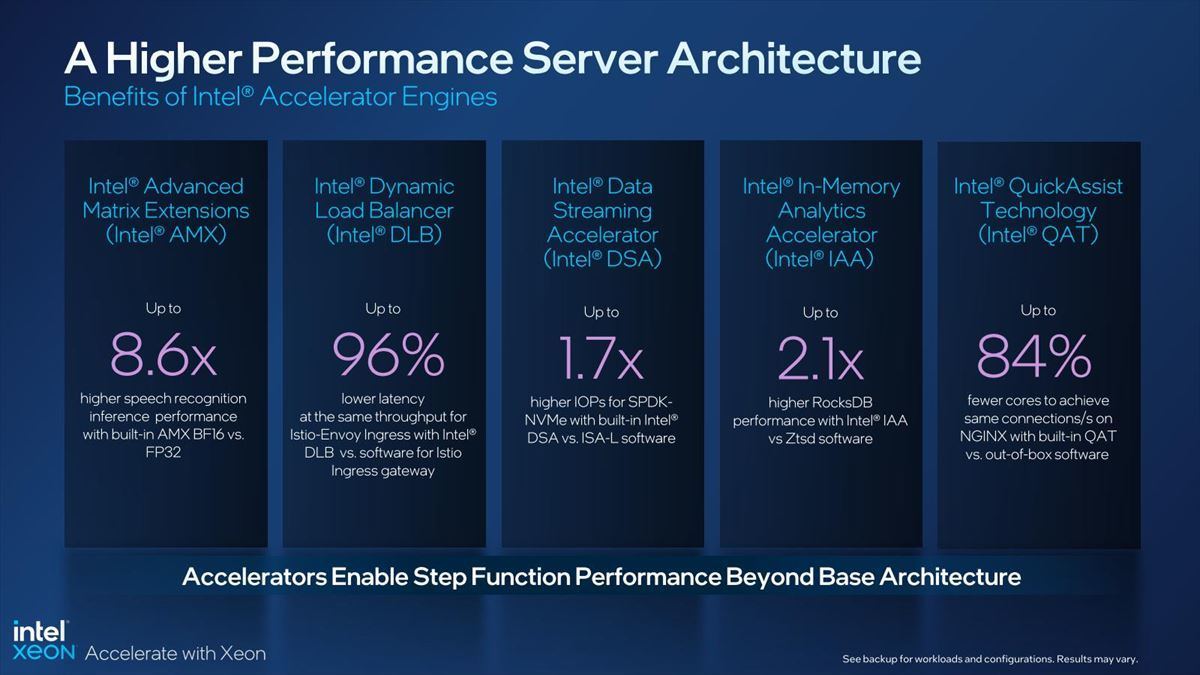

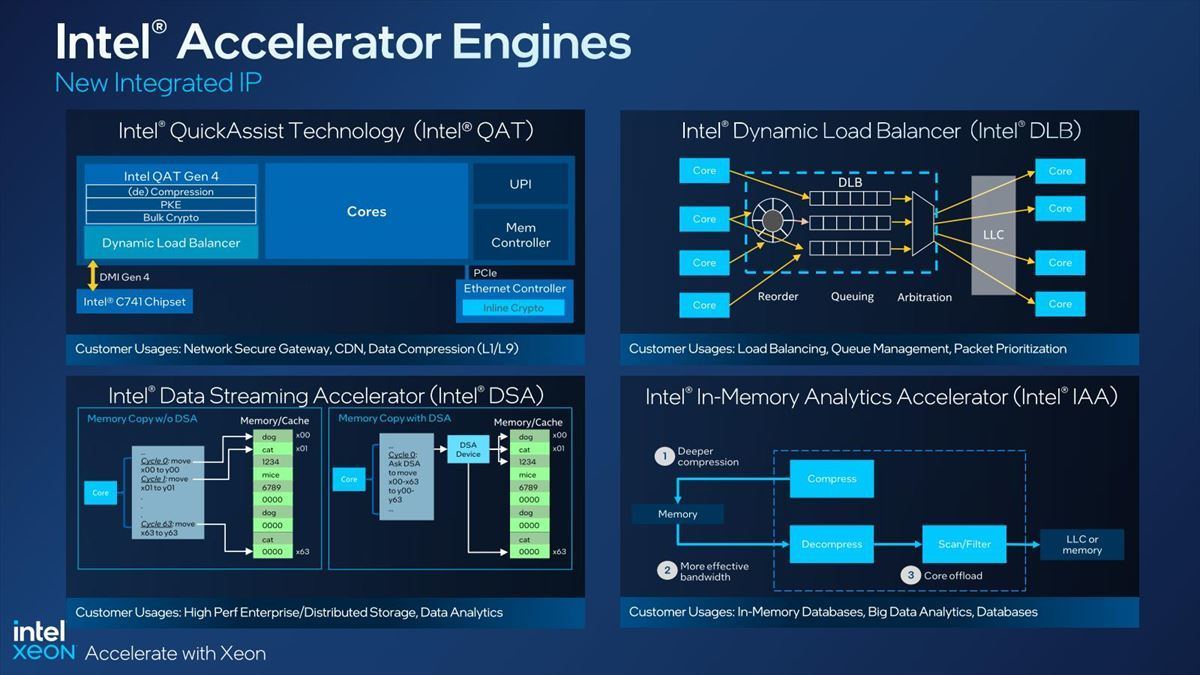

それとは別に、Sapphire Rapidsでは4種類のAcceleratorが搭載されている。QAT(Quick Assist Technology)、DLB(Dynamic Load Balancer)、DSA(Data Streaming Accelerator)、IAA(In-memory Analytics Accelerator)の4つである(Photo07)。

-

Photo07:QAT/DSA/DLBに関しては、以前こちらで説明を行っているので今回は割愛する

先にPhoto05の表の一番下に“Integrated IP Accelerators”とあるのがこれだ。この4つのAcceleratorは、実はちょっと面白い扱いになる。2022年11月22日、IntelはIntel On Demandというサービスを開始した。要するにこの4種類のAcceleratorは、標準状態では機能が無効化されている。このAcceleratorに関しては、Consumption Model(利用状況に応じて課金)とActivation Model(課金すると機能が有効化される)の2つのSubscription Modelが用意されている。各々のAcceleratorは確かに高機能だが、必ずしも全ての利用者が必要になるとは限らないし、不要なユーザーにとっては「不必要な機能が搭載されてその分コストが上がるのは納得できない」と考える場合もあるだろう。だからといってIntelが、いちいちAcceleratorありと無しで別々の製品を提供する様にしたら、そうでなくても多いSKUが更に増えることになる。Intelとユーザーの双方にメリットがあるのが、このIntel On Demandの仕組みである。ただしこのIntel On Demandの対象になるのは、現状ではPhoto07の4つだけである。先ほど「AMXはSapphire Rapidsの必須要件の1つ」と書いたのは、AMXはIntel On Demandの対象ではない、とIntelから明確に回答を貰ったためである。

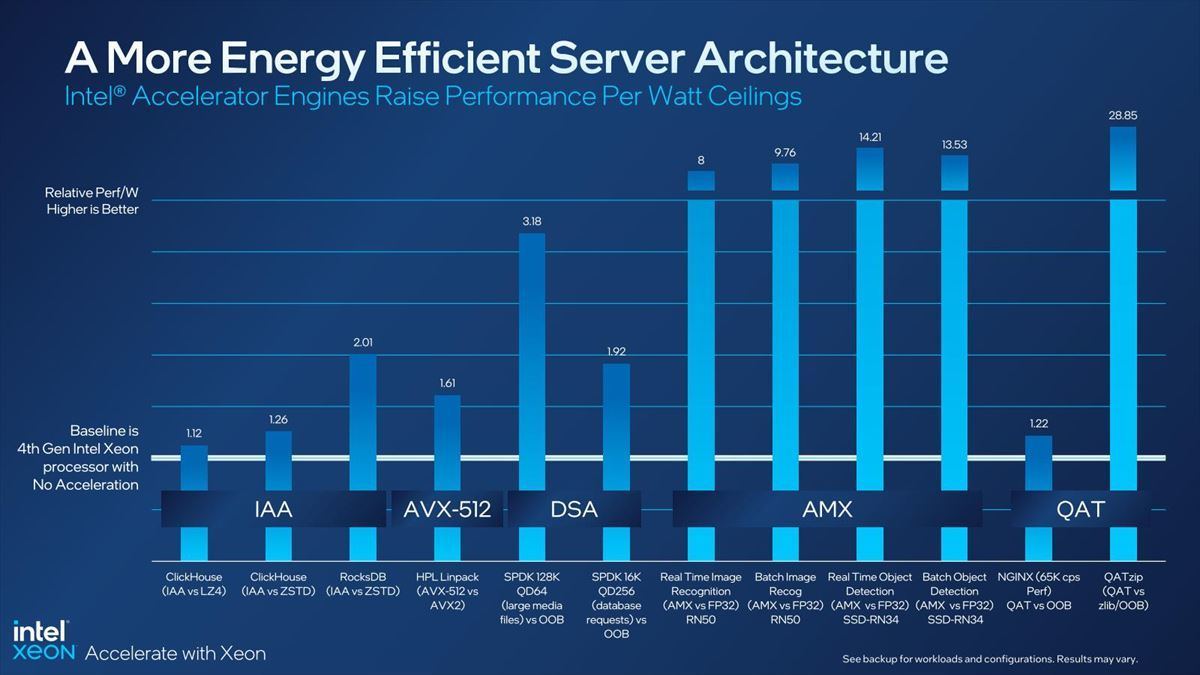

話を戻すと、このアクセラレータを利用する事でのメリットがこちら(Photo08)。

アプリケーションの要件にうまく当てはまるのであれば、On Demandを使って必要なAcceleratorを有効化するメリットは十分にあると言える数字である。単に絶対性能だけでなく、性能/消費電力比も向上するとしている(Photo09)。

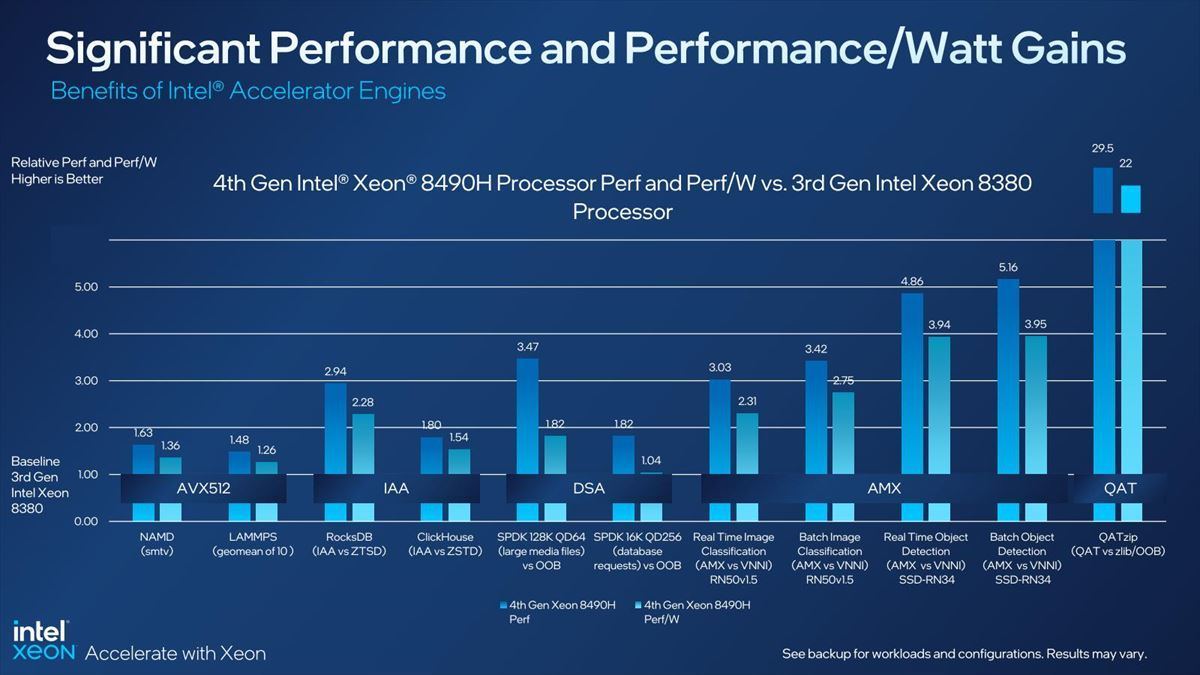

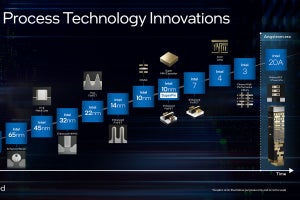

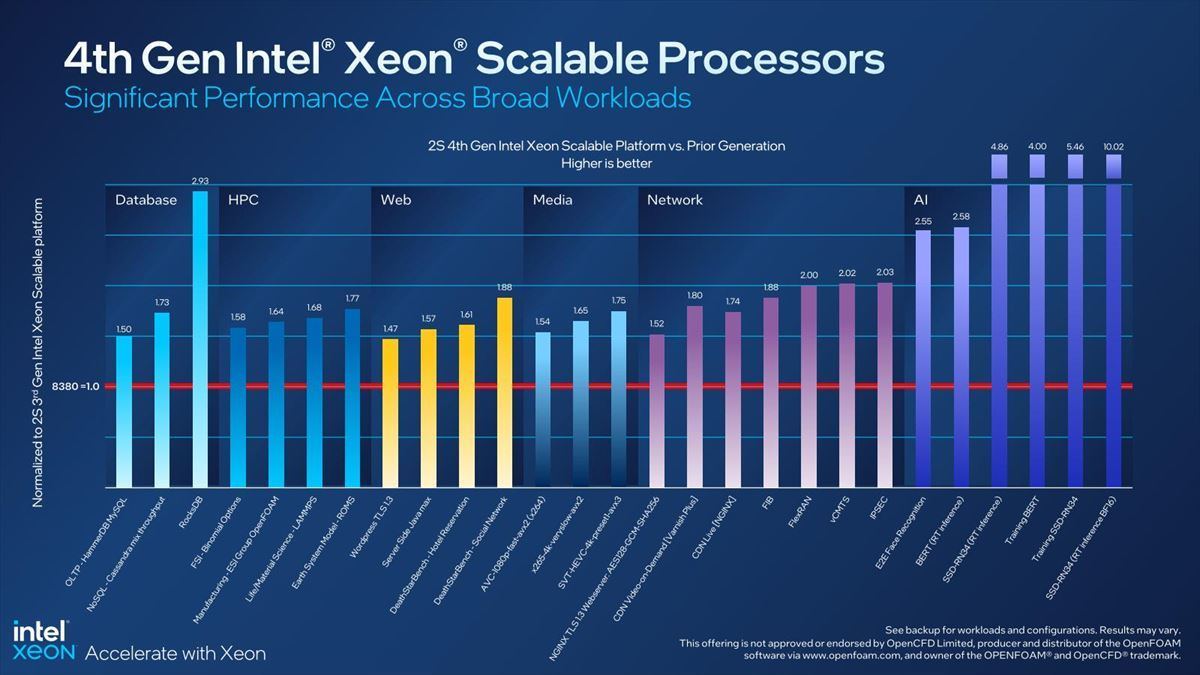

これに比べて、そもそもSapphire Rapidsそのものが大幅に高性能化している。今回は細かい内容は割愛するが、CPUコアはAlder Lakeと同じGolden Cove、プロセスもやはりAlder Lakeと同じIntel 7を採用している関係で、そもそもの絶対性能(Photo10)および性能/消費電力比(Photo11)が前世代(Ice Lake-SP)から大幅に向上している。

-

Photo10:AIでの性能向上が著しいのは、主にAMXの実装に拠る部分が大きく、CPUコアには直接関係ないが、Database~Networkに関してはCPUコアの性能向上とDDR5のサポートが大きなポイントである

ということでまずは第4世代Xeonスケーラブル・プロセッサとXeon Maxの概要をお届けした。もう少し詳細な話は別記事でお届けしたい。