HBM(Photo11)

-

Photo11: 2005年頃からウチにご飯をねだりに来たものの、ウチの外猫連中と折り合いが悪かった子。仕方ないので2007年頃に保護、2009年になぜかCPU編の三毛と同じお宅に里子に行き、ものすごく甘えん坊になった。

2021年中にHBM2に加えてHBM2Eの標準化もJEDECで完了。2022年にリリースされるIntelのPonte VecchioやAMDのRadeon Instinct MI200シリーズに採用が決まっており、今年はHBM2E搭載製品が随分登場しそうだ。ただもうコンシューマ向けには採用される例は無い(か、あってもごく僅か)と思われる。最大の理由は値段であって、同一容量だとHBM2はGDDR6の4倍に達する、という試算もある。なんでかというと、MemoryのStackingにTSVを使っているからで、これが高騰する最大の要因である。Silicon Interposerが必須なのも価格が高い要因ではあるが、これは基板面積の小型化などである程度相殺可能である。しかしながらが、Stacking用のTSVはどうにもならないというあたりで、なのでGDDR6を遥かに超える帯域が必要とされるハイエンドGPU(というか、HPC向けのGPGPU)やAIプロセッサなどで多用されるが、コンシューマPC向けマーケットではちょっと無縁な位置づけになってしまった。

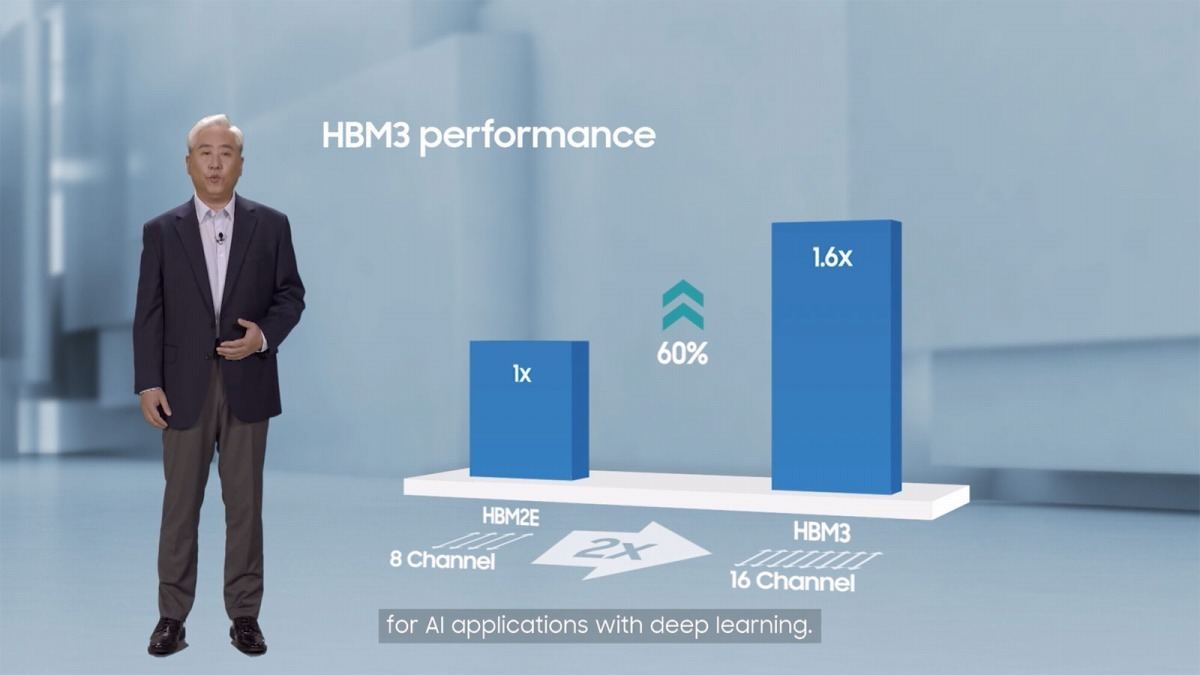

そのHBMであるが、まだHBM3の規格はJEDECで審議中にも関わらず、既にRambusはHBM3 I/F IPを2021年中にリリース。2021年10月にはまずSK Hynixが製品開発完了をアナウンス。SamsungもHBM3を2022年第2四半期に量産すると述べている(Photo12)。恐らくはIntel/AMD/NVIDIAの次世代HPC向けGPUカード(Intelで言えばPonte Vecchioの次、AMDならRadeon Instinct MI300シリーズ、NVIDIAならAmpere Nextに相当する製品)と、今年発表されて2023年以降に投入される製品にHBM3が採用されることになると思われる。