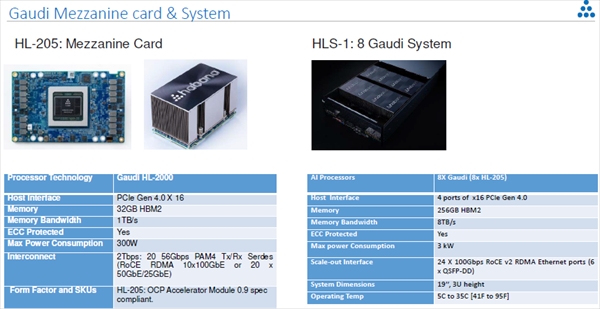

次の図は学習用のGaudiのボードの写真である。

Gaudiは学習をターゲットにしているので、スケールアウト時の性能が重要である。そして、電力効率が高いことも重要なターゲットである。さらに、スケールするために特別なネットワークを必要とせずRoCE v2をサポートし、入手が容易なEthernetスイッチが使えることも重要である。そして、Open Computeのアクセラレータモジュールの規格に合わせておくことも重要である。それらに加えて、オープンなソフトウェやツールが利用できることも必須である。

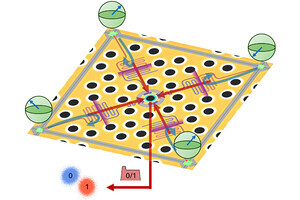

Gaudiプロセサのアーキテクチャは、TPC、GEMMとDMAという3種のエンジンを持つヘテロジニアスなアーキテクチャという点はGoyaと同じである。ただし、TPCのバージョンが2.0となり、個数もGoyaに比べて倍増している。そして、メモリが2GT/sのHBM2 4個となりバンド幅が1TB/sとGoyaの40GB/sに比べて25倍に向上している。

スケーラビリティが重要であるので10ポートの100Gb Ethernet、あるいは20ポートの50Gb Ethernetポートを持ち、RDMAエンジンを集積し、RoCE v2をサポートする。数値表現についてはFP32 、BF16の浮動小数点フォーマットと各種の整数フォーマットをサポートする。

-

Gaudiプロセサのアーキテクチャ。TPC、GEMM、DMAと3種のエンジンを持つヘテロジニアスなアーキテクチャはGoyaと同じであるが、TPCがv2.0になり、TPCの数が倍増、メモリバンド幅が25倍と大幅に処理能力が上がっている。また、通信も100GbEが10ポートとスケールアウトに配慮した構成となっている

Gaudiのソフトウェアツールは基本的にGoyaと同じであるが、PCI DriverのところにMulti Device supportとかGraph CompilerのところにTopologiesなどと書かれており、スケールアウトする場合のマルチチップのサポートが追加されているようである。

スケールアウトであるが、V100 GPUの場合は、左の図のようにPCIeからPCIeスイッチを経由して100GbのRDMA NICを繋ぐことになる。これに対してGaudiでは同一チップに載っている10ポートの100GbのRoCEを並列に使うことができるので、圧倒的な大きな通信バンド幅が使える。NICが同一チップに載っているので、オーバヘッドが小さく、ラウンドトリップで~300nsのレーテンシが得られる。

-

NVIDIAのGPUからはPCIeポートを使って100GbのRDMAを出すことになり、100Gbのチャネルが1本であるが、Gaudiは同一チップに10チャネルの100GbEを内蔵しており、10倍のバンド幅でスケールアウトができる

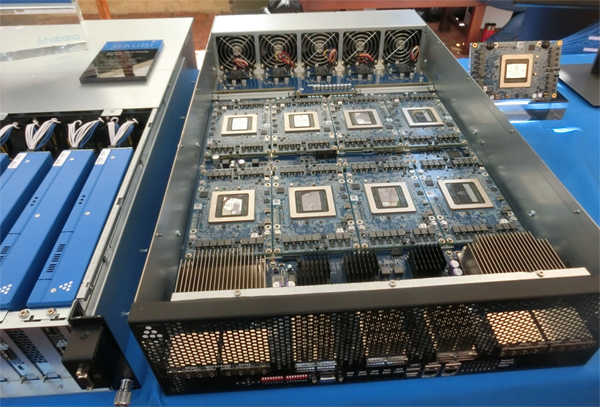

次の図の3つの写真は左端がGaudiのメザニンカード、中央がOCP accelerator ModuleのフォームファクタのGaudi、右端はGaudiを8個搭載した3Uサーバの写真である。HL-205というメザニンカードの消費電力は300Wとなっている。

Habana LabsはHot Chipsの会場の展示スペースに各種のGaudiカードやシステムを持ち込んで展示を行っていた。

-

メザニンカードを搭載する8 GaudiのHLS-1システムシステム (Hot Chips 31での展示を筆者が撮影)

-

GPUのような形態のHL-200 Gaudiボードも展示されており、こちらを使った8 Gaudiのシステム (Hot Chips 31での展示を筆者が撮影)

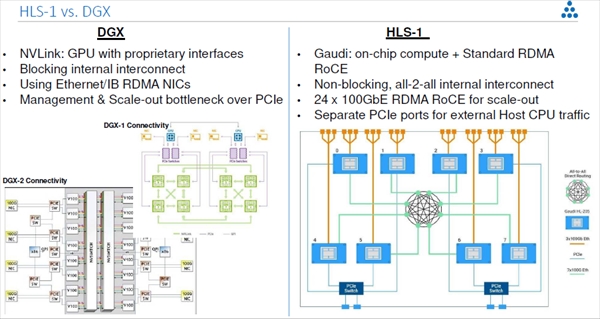

次の図は左側がNVIDIAのDGX-2と1世代前のDGX-1をスケールアウトする場合の接続で、右はGaudiを使うHLS-1でスケールアウトする場合の接続である。DGXはNVLinkで接続されている範囲内では性能が高いが、その範囲を超えてスケールアウトしようとするとRDMA機能を持ったEtherNet、あるいはInfiniBandのNICが必要となる。そして、内部のインタコネクトはBlockingである。これに対してHLS-1の方は内部はすべてRoCEであり、内部と外部でネットワークの不連続がない。そして、中央に書かれているall-to-allのNon Blocking接続が作れる。さらに8 Gaudiのシステムから24本の100GbEのスケールアウトポートが出せる。

-

NVIDIAのDGXをスケールアウトする場合(左)とHabanaのHLS-1をスケールアウトする場合の比較。NVLinkはNVIDIA独自であるが、HLS-1は標準のRDMA RoCEを使っている。また、スケールアウト用に24ポートの100Gb RoCEが残っており、さらに大きいシステムも作れる

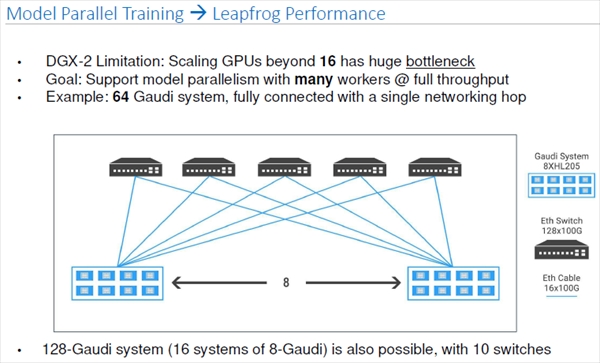

DGX-2は16GPUより大きなシステムを作ろうとすると大きなボトルネックがあるが、Gaudiならば、8Gaudiのサーバを8台並べて6台の128×100Gスイッチを使えば、シングルホップで64個のGaudiをネットワークするシステムが作れる。

-

NVIDIAのDGX-2は16GPUまでは良いが、それ以上にスケールアウトすることが難しい。しかし、Habana LabsのHLS-1は128×100GbのGbEスイッチを5台使えばワンホップで64Gaudiのシステムを作れる

HabanaのGaudiシステムはスループットが高く、学習の速度を加速する。結果として、生産性が上がり、消費エネルギーも減らせる。

また、Habana LabsのGaudiシステムはどこまでもスケールすることができる設計である。それがスタンダードな製品で実現でき、プロプライエタリな技術へのロックインの心配もない。

-

Habana LabsのGaudiシステムは学習を加速し、生産性を上げられる。また、エネルギー効率も高い。そして、スケールアウトが容易で、無限にスケールができる。かつ、標準の機器でスケールが実現でき、特定メーカーの機器にロックインされることもない

(次回は9月24日に掲載します)