各システムボードには4つの計算ノードが載っており、a軸とc軸の接続はシステムボードのプリント配線で実現されている。そして、3枚のシステムボードをバックプレーンのプリント配線で作られるb軸で接続することで12ノードのグループが作られている。そして、各筐体には24枚のシステムボードが搭載されるので、全体では8つの12ノードグループができることになる。

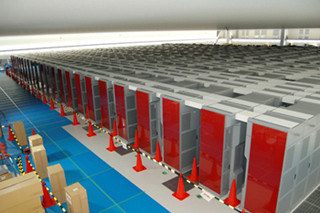

計算ノード間の接続はX+、X-、Y+、Y-の4本で行われ、筐体には96計算ノードが搭載されているので4×96=384本のケーブルが接続される。これらの筐体間のケーブルは長さが短いので、次の写真では黒色に見える電気ケーブルで行われている。

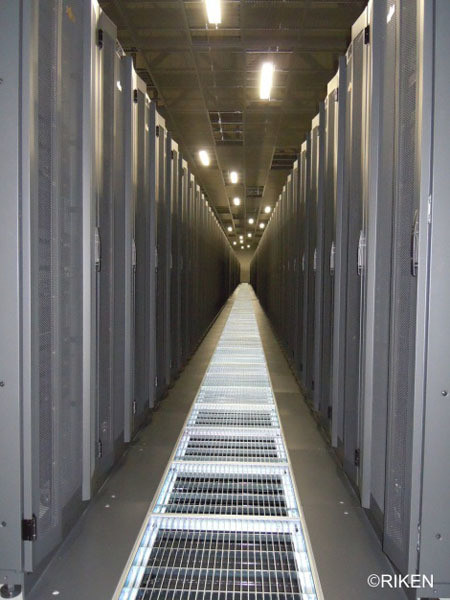

そして、各筐体の上側の12枚のシステムボード間をつなぐケーブルは上側に引き出し、筐体の上のケーブルトラックを通す。一方、下側の12枚のシステムボード間のケーブルは下側に引き出して床下のスペースを通している。そして筐体からのケーブルの引き出し部はケーブルカバーで覆って保護する。筐体間のスペースは80cmであり、そこからケーブルカバーが出っ張っているので、保守スペースはかなり窮屈であるが、これを広げると必要な床面積に跳ね返るのでやむを得ない。

このローカルファイルシステムはLustreを拡張した富士通のFEFS(Fujitsu Exabyte File System)で、MDS(メタデータサーバ)は1階に置かれている。そして、計算ノード筐体のIOノードがOSS(オブジェクトストレージサーバ)となっている。そして、1階に置かれたMDSとの接続や、グローバルファイルシステムとの接続にはオレンジ色の多芯光ファイバが使われており、2階の空調機械室を貫通して1階につながっている。

そして、30PB以上という巨大な容量のグローバルファイルシステムも1階に置かれている。1階のフロアは、奥行は3階と同じ60mであるが幅は半分の25mで、残りの部分はセミナ室や事務室、説明のための展示スペースなどとなっている。

1階の計算機室にはグローバルファイルシステムを構成する富士通のETERNUS RAIDストレージ720台とそのアクセスを制御するOSS 90台が並んでいる。大量のファイルを扱うのですべてのアクセスが集中するMDSには高い処理能力が要求される。このため、Xeon E7を使う8CPUのPRIMEQUESTサーバを使い。信頼度を高めるため2台で二重化を行っている。RAIDディスクへのアクセスを制御するOSSは90台の2CPUのPRIMERGYサーバを使い、これも2台ずつをペアとして片側が故障してもアクセスは継続できるようになっている。

巨大なシステムであるので、コンポーネントが故障するのは避けられないが、水冷でCPUやICCのチップ温度を下げた効果で計算ノードの故障は予想より少なく、システム全体では9万個を超えるHDD関連の故障がもっとも頻度が高いという。ただし、ストレージはRAID構成になっているので、故障が発生してもシステムが止まることはないとのことである。

(次回は2月18日の掲載予定です)