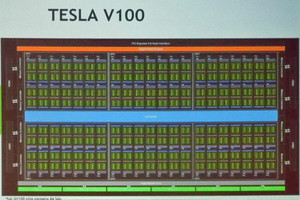

前世代比で最大20倍の性能向上を達成

次のグラフは、前世代のV100とA100で、FP64(64bit倍精度浮動小数点数)での計算、TF32、FP16(16bitの半精度浮動小数点数)、INT8(8bitの整数)で計算した場合の演算性能を示すものである。物理シミュレーションに用いられるFP64の演算ではA100はV100の2.5倍の性能。AI演算では、V100の性能が16に対してA100のTF32演算が160、疎行列処理をすれば最大310で、V100の10倍/20倍の性能。FP16 でも2.5倍/5倍の性能。INT8ではV100の60に対して625/1250と、これも10倍/20倍と大幅な性能向上を実現している。これはNVIDIAのGPUの世代間の性能向上の歴史でも最大の性能向上であるという。

-

物理シミュレーションに用いられるFP64の演算ではA100はV100の2.5倍の性能向上であるが、AI演算では、10倍/20倍の性能向上を実現している。これはNVIDIAのGPUの世代間の性能向上としても最大のものである

次のグラフは自然言語理解などを行うBERTの学習性能と推論性能を示すグラフで、BERTの学習ではA100はV100の6倍の性能となっている。そして、BERTの推論ではV100を1.0とすると、A100は7倍の性能で、T4は0.6倍の性能となっている。

なお、自然言語理解は、コールセンターでの顧客対応などに必須の機能で、需要が増えている。

第3世代AIシステムも登場

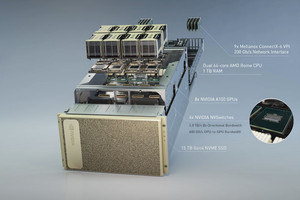

そして、NVIDIAはA100ベースの3世代目のAIシステム「DGX A100」も発表した。次の図に見られるように、V100 GPUを使うDGX 2と比較すると高さが2割程度低くなっている。DGX 2では8個のGPUを搭載するマザーボードが2段積みになっていたが、DGX A100ではマザーボードは1枚で、A100 GPUの数は8個になっている。

しかし、A100 GPUはV100 GPUの2倍以上の性能があるので、8GPUのDGX A100の方が、V100を16個使うDGX 2より性能が高い。そのため、GPUやNVSwitchのチップ数は少ないが、お値段は19万9000ドル(約2100万円)である。

疎行列を圧縮処理した場合の性能であるが、INT8での演算性能は10Popsに達する。マシンラーニングの学習をTF32で行う場合でも、演算性能は2.5PFlopsのピーク性能を持つ。

そして、通常のCPUベースのサーバと比較するとAI計算性能は150倍、メモリバンド幅は40倍、IOバンド幅も40倍。これで19万9000ドルで、Huang CEOの決めセリフの「買えば買うほど節約になる(More you buy, more you save)」がでる。

DGX A100はNVIDIAの製品であるが、クラウドのサーバとしての使用やOEM向けにも販売しており、こちらはHGX A100という名前である。次のスライドに見られるように、Alibaba、AWS、Baidu、Google、Microsoft Azureなど大手のクラウドがA100ユーザに名を連ねている。HGXシステムの方も大手のコンピュータメーカーが名を連ねており、日本からも富士通が入っている。