前回は、生成AIの企業活用における課題である「セキュリティ」、「自社データの活用」、「ハルシネーション」のうち、セキュリティの課題に関する解決策を提示しました。

簡単におさらいすると、ChatGPTのように他社サーバで管理されているLLMの場合、プロンプトをサーバに送信する都合上、入力した内容が100%学習に使用されないとは断言できないというリスクがあります。そこで注目を集めているのがローカルLLM。企業が自社で生成AIを開発し、自社専用で使用することで、情報漏洩などのリスクを低減する方法としてお伝えしました。

今回は、残る2つの課題である「自社データの活用」と「ハルシネーション」について解説します。

生成AIが「思ったよりも使えない」理由

そもそも「自社データの活用」に関する課題とは何か。

例えば、ChatGPTやGeminiといった生成AIに次のようなプロンプトを入力してみます。

「◯◯(自社製品)の来期の売上予測をしてください」

このプロンプトに生成AIは正しく回答できるでしょうか。……もちろん、無理です。なぜなら、自社製品の売上予測に活用すべきデータは機密情報であり、一般の人が閲覧できるインターネット上に公開されていないからです。ChatGPTなどの生成AIはいわば汎用AIであり、インターネット上の情報を幅広く学習しています。逆にいえば、インターネット上に公開されていないデータは学習できておらず、そのデータを前提とした作業は正しく行えません。

これが、「自社データの活用」における課題です。厄介なのは、本当に重要な情報はインターネット上に公開されていないということです。製造業におけるベテランのノウハウ、美容師のカットの技術、特定の企業内でだけ通用する独自の慣習ーーいずれも暗黙知となっていることが多く、それらに関するプロンプトに生成AIは対応できません。

一見あらゆる問いに答えを出せそうな生成AIですが、実際に業務で使ってみると「思ったより使えないな」と感じることも多いはず。それは、業務で必要なクローズドデータを学習できていないことが理由なのです。

生成AIの致命的な弱点「ハルシネーション」

もう1つの課題が「ハルシネーション」です。この問題は生成AIが登場した当時から指摘されていました。ハルシネーションとは、生成AIが「もっともらしく嘘をつく」ことを言います。

例えば、本当は存在しない動物園をでっち上げて、生成AIに「詳細を教えてください」と入力します。すると、存在しない動物園であるにもかかわらず、生成AIはあたかもその動物園が存在するかのように偽の情報を回答してくることがあるのです。これがハルシネーションです。

実のところ、ChatGTPにおけるハルシネーションは以前に比べてかなり少なくなっています。ただし、それでもゼロではありません。生成AIに質問する場合は、常に回答が正しくないケースがあることを念頭に置いて活用する必要があるのです。

ということはつまり、生成AIをビジネスで使用する場合、「回答が正しいかどうかをユーザーが見極められる」ことが重要になります。仮に生成AIがハルシネーションを起こしても、その回答が誤っていると判断できれば大きな問題にはならないからです。逆に生成AIの回答が正しいか誤っているかをユーザー側が判断できないと、ビジネス上の大きなリスクにさらされる可能性もあります。

課題を解決し得る「2つの方法」

では、これらの課題を解決するにはどうすればいいのでしょうか。

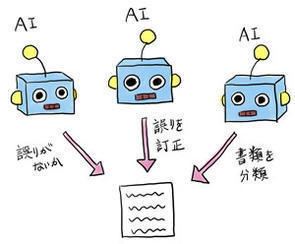

効果的な対処法の1つが「RAG(Retrieval-Augmented Generation)」と呼ばれる方法です。RAGとは、外部のデータベースと生成AIを連携し、生成AIがコンテンツを生成する際にデータベースを検索させるフレームワークです。

例えば自社の売上予測を生成AIにさせる場合、予測に必要な売上データベースを生成AIと連携させた上で質問するわけです。すると、生成AIは売上データベース内を検索して必要なデータを参照し、売上予測を回答します。一般的なインターネット上の情報だけでなく、必要なデータを与えることで回答精度は大きく向上します。

回答精度が上がるということは、同時にハルシネーションの可能性を低下させられるということでもあります。また、RAGはあくまで外部のデータベースと生成AIを接続する方法であり、生成AIのモデルが学習を行うわけではありません。そのため、「少量のデータで実現でき、比較的実現も容易である」というメリットがあります。

「プロンプトが長くなりがちになる」とか、「外部データベース検索の仕組みを別途作る手間がかかる」といったデメリットもあるのですが、それでもさまざまなメリットがあることから、今、企業の生成AI活用で主流となっているフレームワークです。

もう1つの方法は「ファインチューニング」です。生成AIのモデル自体に知識を与えるわけではないRAGと違って、ファインチューニングは生成AIのモデル自体をチューニングし、ドメイン知識を与えるという方法です。つまり、生成AIのモデルにデータを与え、学習を行わせます。

ファインチューニングのメリットは、うまく学習できればRAGのように毎回検索する必要がなく、またプロンプトもRAGに比べより短くシンプルなものでよいため、回答を得る効率が上がります。

一方で、ファインチューニングはRAGよりもかなり難易度が高い方法です。というのも、仮に新しく学習した範囲の回答精度が上がっても、逆にそれ以外の回答の精度が全体的に落ちることもあり得るからです。なぜそうなるのかはわかりません。生成AIがどのように学習を行っているのかはブラックボックスだからです。

大きなメリットがある反面、大きなデメリットが生じる可能性もあるファインチューニングは、今のところかなり上級者向けの方法だと言えます。

* * *

さて、ここまで述べてきたように、生成AIはビジネスで本格的に活用するにはまだいくつかの課題を抱えています。ただし、ローカルLLMやRAG、ファインチューニングといった方法で、課題解決への道筋も見えてきています。

では、これからのAIはどのような局面に入っていくのでしょうか。

次回は今後のAI時代がどうなっていくのかについて考察します。

AI関連の注目ホワイトペーパー

自動車とその業界を取り巻く環境の変化に、製造ラインはどのようにキャッチアップすべきか?エッジAIはマイコンで。エッジAI処理、セキュリティ、低消費電力―すべてを高いレベルで実現するマイコンの実力

自己学習型AIによるセキュリティ対策がもたらす強みとは? 脅威の予兆を自動識別、攻撃をピンポイントで自動遮断

AI関連のオススメ記事

ローカルLLMのメリット/デメリット、“使いどころ”を分かりやすく解説RAGで企業は何を実現できるのか? 基礎知識と活用メリット

機械学習とディープラーニングの違いを徹底解説

AIと機械学習の違いを理解して、業務効率化や新規事業創出に役立てよう

LLMとは? 生成AIとの違いや企業の活用事例を解説

AI活用でビジネス変革を実現するには? 押さえておきたい基本と活用事例