前回、Appleの参入で生成AIの活用状況に一石が投じられたこと、しかしながら生成AIにはまだ3つの課題があるというところまで説明しました。その3つの課題とは「セキュリティ」、「自社データの活用」、「ハルシネーション」です。生成AIがそのポテンシャルに比して活用が進んでいない原因には、この3つがあると考えられます。

では、これらの課題はどうすれば解決できるのでしょうか。今回は「セキュリティ」に関する課題の詳細と解決策について解説します。

リスクとメリットのトレードオフ

そもそも生成AIにおけるセキュリティ課題とは何でしょうか。生成AIの仕組みについて今一度確認してみましょう。

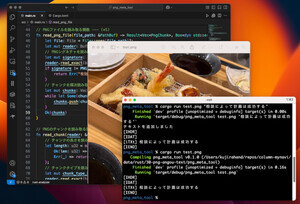

生成AIを使用する際、まずは生成させたいコンテンツについて指示を出します。例えば「新商品を企画しています。次のような商品の特徴を踏まえて企画書を生成してください」(以下、特徴を列挙)とプロンプトで指示を出すと、生成AIは指示通りの文章を生成してくれるわけです。

ChatGPTなど一般的な生成AIの場合、入力したプロンプトはまずは生成AIのサーバに送信されます。そしてサーバで文章が解析され、その内容を基に生成AIがコンテンツを生成、生成されたコンテンツがサーバから再び送られ、PCやスマートフォンの画面に表示されるという流れです。

ここでポイントとなるのが、「入力したプロンプトがサーバに送信されている」という点です。つまり、もしも生成AIを提供している企業に悪意があった場合、プロンプトを見たり、こっそり保存したりもできるということになります。ただ、それは極端な話かもしれません。

現実的に課題視されているのは、もう1つの可能性です。それは、「プロンプトとして入力した文章が生成AIの学習に使われる」こと。例えば、先ほどの例でいうと、「新商品を企画しています。次のような商品の特徴を踏まえて企画書を生成してください」というプロンプトを入力したことで、生成AIは「企画されている新商品とその特徴」を学習してしまいます。そして、この学習された内容が、まったく別のユーザーに対する生成物に活用される可能性があるのです。もし、競合他社に情報が漏れてしまったら……場合によっては会社の業績に影響を与えかねません。

もちろん、プロンプトを生成AIに学習させないように設定することもできます。また、ChatGPTであればAPIを利用して外部サービスと連携した場合、プロンプトは学習に利用しないことが明記されています。

ですが、だからといって「それなら安心だ」と思えるでしょうか。個人情報や機密情報など万が一にでも学習されては困る情報を生成AIに入力できるでしょうか。少なくとも私は絶対に入力しません。しかも、やっかいなことに生成AIを提供している企業も「学習に利用しません」とは書いていても、「100%安全です」とは保証していないのです。なぜなら、生成AIを提供している企業ですら、AIの内部で起きていることについてはコントロールしきれないからです。これは技術力がないのではなく、AIとはそもそもそういうものなのです。AIとは人間の知能を模した存在ですから、他人を100%コントロールできないように、AIも100%はコントロールできない、と考えればしっくりくるのではないでしょうか。

では、どうすればいいのか。

多くの企業は、「流出しては困る情報をそもそも入力しない」というルールを設けているはずです。ただ、これでは生成AIにできる作業が限定的になり、ポテンシャルを十分に発揮できるとは言えません。

あるいは、「流出しては困る情報をマスキングしてプロンプトを作成する」という方法も考えられます。ただし、マスキングが100%できていなければセキュリティ事故につながる可能性があるため、ヒューマンエラーを考えると推奨できません。

セキュリティを考えると生成AIのポテンシャルを発揮できず、生成AIをフル活用しようとするとセキュリティリスクが発生してしまうーーこれこそが企業における生成AI活用の大きな課題なのです。

注目を集める「ローカルLLM」

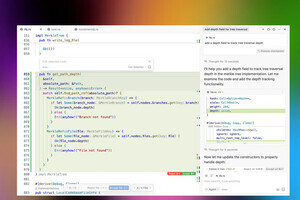

この課題を解決する方法として、最近注目されているのが「ローカルLLM」です。ローカルLLMとは、つまり「限定したユーザーや用途で活用するための生成AI」と捉えてください。

早い話が、「自社専用の生成AIを開発する」のです。そんなことができるのかと思われるかもしれませんが、できます。確かにChatGPTのようにサイズの大きなLLMに比べると汎用性は低くなります。全回説明したように、生成AIの精度は物量、つまり計算資源に投資した金額に比例するため、サイズの大きなLLMに勝てるはずはありません。

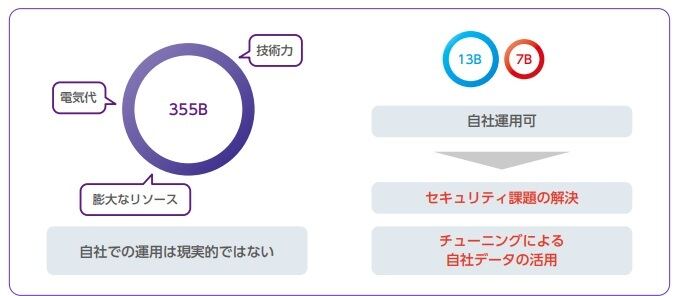

しかし、そもそもそうしたLLMと勝負する必要はないのです。自社専用のLLMの用途は業務に特化しています。大規模なLLMのように世界中のユーザーのあらゆる内容のプロンプトに対応する必要はないのです。そのため、必要な計算資源もパラメータ数もずっと少なくて済みます。例えば、GPT-3.5のパラメーター数は推定355B(ビリオン)ですが、ローカルLLMであれば13Bや7B程度のパラメータ数でも十分実用に耐えられます。

何より、自社専用なので入力した情報が他社のサーバに送信される心配がありません。機密情報も個人情報も自社サーバ内に留まりますから、セキュリティが担保されます。いわばイントラネットのような感覚で使用できる生成AIなのです。

すでに日本でも、NTTの「tsuzumi」やカラクリの「KARAKURI LM」などの比較的小さなLLMを提供する企業が現れています。日本企業が提供するLLMは、日本語に特化しているのもポイントです。考えてみれば主に日本でビジネスを展開している日本企業であれば、業務で外国語を扱う機会は少ないでしょう。外国語に対応しなくていいのであれば、多くの言語に対応する大規模LLMほどの計算資源も必要ありません。

セキュリティにおけるメリットの大きいローカルLLMは多くの業界に導入が進みつつあります。例えばtsuzumiは製造業や自治体、自治体などセキュリティが重要な組織でも導入が進んでいます。

セキュリティという大きな課題に対する1つの答えを提示したローカルLLMは、今後の生成AI活用の主役になっていく可能性が高いといえます。

次回は残る2つの課題「自社データの活用」と「ハルシネーション」の解決策について解説します。

AI関連の注目ホワイトペーパー

自動車とその業界を取り巻く環境の変化に、製造ラインはどのようにキャッチアップすべきか?エッジAIはマイコンで。エッジAI処理、セキュリティ、低消費電力―すべてを高いレベルで実現するマイコンの実力

自己学習型AIによるセキュリティ対策がもたらす強みとは? 脅威の予兆を自動識別、攻撃をピンポイントで自動遮断

AI関連のオススメ記事

LLMとは? 生成AIとの違いや企業の活用事例を解説機械学習とディープラーニングの違いを徹底解説

AIと機械学習の違いを理解して、業務効率化や新規事業創出に役立てよう

ローカルLLMのメリット/デメリット、“使いどころ”を分かりやすく解説

AI活用でビジネス変革を実現するには? 押さえておきたい基本と活用事例

AIエージェントの基本を知る - ビジネス活用の可能性と課題とは?