今回は、ディープラーニングを用いた一般物体検出の続きです。今回は、一般物体認識の分野で提案されている主な手法を整理したいと思います。

一般物体検出の概要

前回の記事でディープラーニングを用いた一般物体検出の先駆けである、R-CNN[1]をご紹介しました。R-CNNの処理は下記の3つに大別できます。

- Extract region proposal:まず、画像全体から物体っぽい領域を検出

- Classify regions:CNNにより特徴量を抽出し、各領域内の物体カテゴリを認識します

- Compute bounding box regression:物体の位置、大きさを正確に求めるために1)で求めた領域(外接矩形、Bounding box)の座標を回帰により再計算

一般物体検出分野の主な手法を整理したものが下記のテーブル(表)です。手法が新しくなるにつれて(テーブルの下にいくにつれて)、どんどん進化していることが分かるかと思います。

| 手法 | 特徴 | End-to-end training可否 |

|---|---|---|

| R-CNN[1] | ディープラーニングを用いた一般物体認識の先駆け的な手法。 個々の処理を段階的に学習させる必要があった |

× |

| SPPnet[2] | SPP(Spatial Pyramid Pooling)層の導入により、R-CNNの計算冗長性を軽減 | × |

| Fast R-CNN[3] | Multitask lossにより2のclassificationと、3のbounding box regressionを同時に学習 | △ |

| Faster RCNN[5] | 1のRegion proposalを求める処理にもディープラーニングであるCNNを利用。 End-to-endな学習が可能となった。 上記のいずれの手法よりも高速な処理(5fps程度)を実現 |

○ |

| YOLO[4] | 1のRegion proposalを求める代わりに画像をグリッド状に分割しておき、グリッドごとに物体カテゴリの認識とbounding boxの座標を求めるというアプローチを採用。 精度はややFaster RCNNに劣るものの大幅な処理速度向上(45〜155fps)を達成。 ただし、一枚の画像中に多数の物体が存在するときは苦手 |

○ |

| SSD[6] | YOLOと同様に1のregion proposalを求める処理が不要。 SSDでは、複数の階層から検出枠を出力できるようにすることで、マルチスケールな物体検出に対応。 YOLOと比較して、多数の物体が存在している画像に対してロバストであり、さらに高速な処理を実現。 精度はFaster R-CNNと同程度 |

○ |

| YOLO v2[7] | YOLOを改良し、9000種類の物体検出が可能。 精度もYOLOより向上しているが、一枚の画像中に多数の物体が存在するときは苦手 |

○ |

| DSSD[8] | SSDで用いてるVGGの代わりにResidual-101を用い、さらにDeconvolution layerを追加することで検出精度を向上 | ○ |

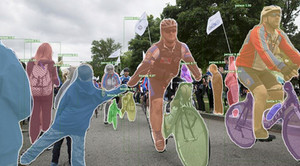

| Mask R-CNN[9] | Faster R-CNNに、Semantic image segmentationの機能を取り入れた手法。 外接矩形だけでなく、人の領域、人の体のパーツの位置を求められる点で大きく進歩 |

○ |

5年前では考えられなかった精度で、さまざまな物体を検出し、そのカテゴリを認識することができるようになってきています。

次回も、一般物体検出についてを予定していますので、興味を持っていただけた方は次回の記事も読んでみて下さい。

参考文献

[1] Ross Girshick, Jeff Donahue, Trevor Darrell, Jitendra Malik, "Rich feature hierarchies for accurate object detection and semantic segmentation." in CVPR2014.

[2] Kaiming He, Xiangyu Zhang, Shaoqing Ren, Jian Sun, "Spatial pyramid pooling in deep convolutional networks for visual recognition." IEEE transactions on pattern analysis and machine intelligence 37.9 (2015)

[3] Ross, Girshick, "Fast r-cnn." in ICCV2015

[4] Kiana Ehsani, Hessam Bagherinezhad, Joseph Redmon, Roozbeh Mottaghi, and Ali Farhadi, "You only look once: Unified, real-time object detection." in CVPR2016.

[5] Shaoqing Ren, Kaiming He, Ross Girshick, Jian Sun, "Faster R-CNN: Towards real-time object detection with region proposal networks." in NIPS2015.

[6] Wei Liu, Dragomir Anguelov, Dumitru Erhan, Christian Szegedy, Scott Reed, Cheng-Yang Fu,Alexander C. Berg, "SSD: Single shot multibox detector. " in ECCV2016.

[7] Joseph Redmon, Ali Farhadi, "YOLO9000: better, faster, stronger." in CVPR2017

[8] Cheng-Yang Fu, Wei Liu, Ananth Ranga, Ambrish Tyagi, Alexander C. Berg, "DSSD: Deconvolutional Single Shot Detector." arXiv preprint arXiv:1701.06659 (2017)

[9] Kaiming He, Georgia Gkioxari, Piotr Dollár, Ross Girshick, R. Mask R-CNN. In ICCV2017.

著者プロフィール

樋口未来(ひぐち・みらい)日立製作所 日立研究所に入社後、自動車向けステレオカメラ、監視カメラの研究開発に従事。2011年から1年間、米国カーネギーメロン大学にて客員研究員としてカメラキャリブレーション技術の研究に携わる。

日立製作所を退職後、2016年6月にグローバルウォーカーズ株式会社を設立し、CTOとして画像/映像コンテンツ×テクノロジーをテーマにコンピュータビジョン、機械学習の研究開発に従事している。また、東京大学大学院博士課程に在学し、一人称視点映像(First-person vision, Egocentric vision)の解析に関する研究を行っている。具体的には、頭部に装着したカメラで撮影した一人称視点映像を用いて、人と人のインタラクション時の非言語コミュニケーション(うなずき等)を観測し、機械学習の枠組みでカメラ装着者がどのような人物かを推定する技術の研究に取り組んでいる。

専門:コンピュータビジョン、機械学習