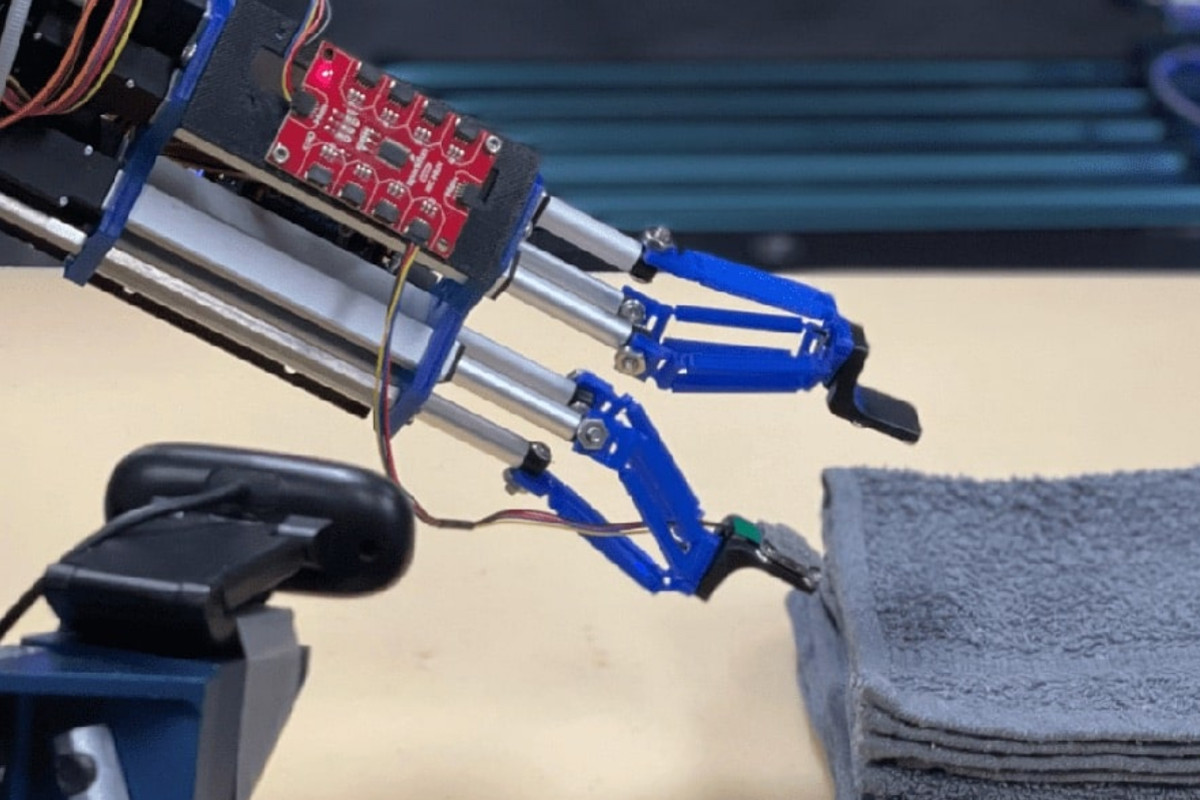

東北大学は、視覚と触覚の情報を統合し、ロボットの両手操作を環境適応的に自動生成するフレームワーク「TactileAloha」を開発したと7月14日に発表。あわせて、マジックテープや、ケーブルを束ねるときに使う結束バンドのように表裏の違いや接着性が重要な作業でも、ロボットが触って判断し、両手で適切に操作できることも発表した。

-

カメラ情報に基づき、ロボットアームはマジックテープの両端を掴む(A.1、B.1)。触覚情報によりテープの向きを感知し、フック面がループ面と合うように姿勢と角度を調整して位置合わせを行う(A.2、B.2)。マジックテープを固定し、右アームが押し付けて確実に結合させる(A.3、B.3)。与えられたテープの面に適応して、適切な接触面となるよう異なるテープ操作運動が自動生成される

(出所:東北大ニュースリリースPDF)

同成果は、東北大大学院 工学研究科のNingquan Gu大学院生、同・林部充宏教授、香港大学および香港・Centre for Transformative Garment Productionの小菅一弘教授(東北大名誉教授)らの国際共同研究チームによるもの。詳細は、IEEEが刊行するロボット工学と自動化技術を扱う学術誌「IEEE Robotics and Automation Letters」に掲載された。

近年、機械学習技術を用いて、ヒトの動作デモンストレーションからロボットが動作パターンを学習し、カメラ画像に基づいて調理や掃除などの日常タスクを実行する研究が進められている。しかし、そうした研究はカメラ画像(視覚情報)に依存するため、素材の質感や表裏の違いなど、触覚的な判断を伴う作業には限界があった。ヒトが日常的に行う多くの繊細な作業では視覚だけでなく触覚を頼りにしていることを考えると、ロボットにも同様の感覚が不可欠といえる。

研究チームは今回、ロボットのグリッパーに触覚センサを搭載し、カメラ画像と触覚情報の双方を統合的に扱うAIフレームワークの開発を行うことにした。

この研究では、視覚と触覚の両情報を統合するため、視覚-触覚トランスフォーマーモデルを採用。トランスフォーマーとは、2017年に登場した深層学習モデルで、アテンション機構により文脈を効率的に理解することが特徴だ。ChatGPTをはじめとする大規模言語モデルの基盤技術として、翻訳・文章生成・質問応答など、自然言語処理分野で高い性能を発揮している。これにより、ロボットが環境に応じた両手の動作手順を自律的に生成することが可能となった。そして、このAIフレームワークは「TactileAloha」と命名された。

【動画】今回の研究成果で実現されたロボットアームの作業を収録した公式動画「TactileAloha (Visual-Tactile Transformer)」

(出所:YouTube東北大Neuro-Robotics Lab公式チャンネル)

TactileAlohaの有効性を検証するため、マジックテープの固定とジップタイの挿入というふたつのタスクが対象とされた。マジックテープの操作では、ロボットが触覚情報に基づいて表裏を判別し、正しい面同士を接着するように両手を動作させる。一方、ジップタイの操作では、対象物の向きを適切に調整しながら挿入を行う必要があり、これも触覚による質感の判断が重要だ。

実験の結果、TactileAlohaは従来の視覚情報のみに基づく手法と比べて、高いタスク成功率を達成し、触覚情報の導入による明確な利点が示された。これは、質感や接触状態に応じて柔軟に動作を変化させる、よりヒトに近いロボット制御の実現に近づく成果とした。

今回の成果は、ロボットのための「マルチモーダルAI」の開発において重要な一歩となる。マルチモーダルAIとは、テキスト・画像・音声・動画など、複数の異なるデータ形式を同時に処理・理解するAI技術だ。従来の単一データ処理とは異なり、ヒトのように複数の感覚情報を統合して総合的な判断を行えることを大きな特長とする。当然、ヒトも視覚や触覚といった複数の五感を連携させ、無意識のうちに多くの動作をこなしている。

今回開発された技術は、家庭内のさまざまな作業、衣類の取り扱い、リハビリ支援、そのほか触覚が求められる産業応用タスクなど、多様な分野での応用が期待される。これにより、複数のセンサ情報を統合した高度な判断を伴う作業が可能となり、ロボットの実用性と適応性を飛躍的に向上させることが期待されるとのこと。