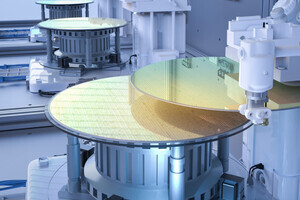

Cerebrasは3月12日、5nmプロセスを採用した「Wafer Scale Engine 3(WSE-3)」ならびに、同製品を活用した第3世代システム「CS-3」を発表した。

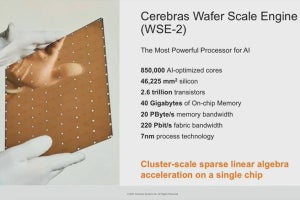

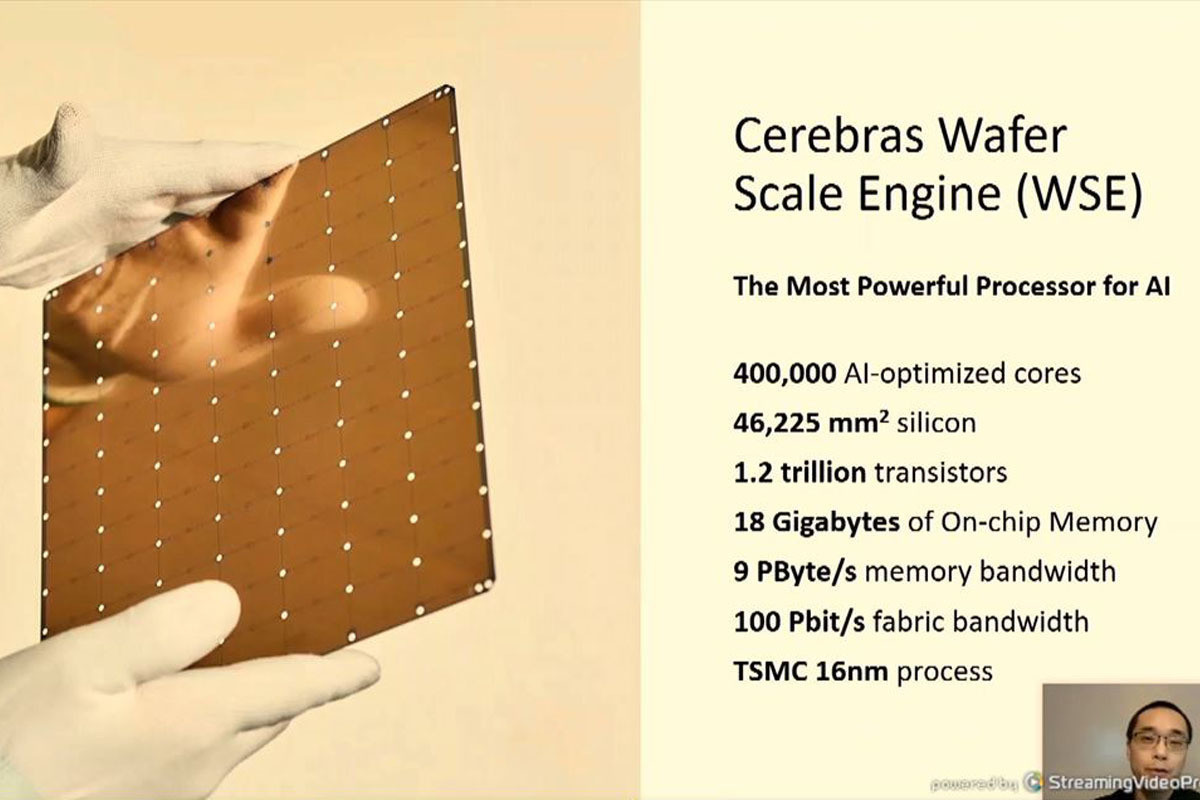

WSE-3は、第1世代のWSE-1のTSMC 16nmプロセス、第2世代のWSE-2のTSMC 7nmプロセスから、TSMC 5nmプロセスへと微細化を進めたことで、4兆のトランジスタを搭載。44GBのオンチップSRAMと90万のAIコアによるピークAIパフォーマンス125PFlopsを実現し、最大1.2PBの外部メモリも活用することで、最大24兆パラメータの学習サイズにも対応。また、CS-3は最大2048台まで接続することが可能だという。

その性能は、CS-3を4台つなげたシステムでLlama2の700億パラメータモデルであれば1日あれば微調整を終えることが可能なほか、最大の2048台接続すれば、1日でゼロから学習することができるとしている。同社では、同じ電力消費量で第2世代比で2倍の性能を発揮できるとしているほか、GPU比でLLMに必要なコード量を97%少なくすることができるともしている。

なお、同社はUAEのAI企業「G42」とパートナーシップを締結し、64台のCS-3を活用した8EFlopsのAIスーパーコンピュータ(スパコン)「Condor Galaxy 3」を建設する予定であるとしており、これまでのCondor Galaxy 1とCondor Galaxy 2と併せたCondor Galaxyネットワーク全体の演算性能は合計で16EFLopsに到達するとしている。このCondor Galaxy 3は2024年第2四半期にリリースされる模様である。