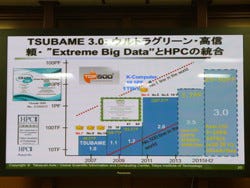

東京工業大学(東工大)は11月25日、同大の次世代スーパーコンピュータ(スパコン)「TSUBAME 3.0」の実現に向けた要素技術の研究などを行うスパコン「TSUBAME-KFC(Kepler Fluid Cooling)」が、スパコンの電力性能(速度性能値/消費電力)を測るランキングである「The Green 500 List」、ならびにビッグデータ処理の省エネルギー性を競う「The Green Graph 500 List」のビッグデータ部門の2013年11月版で世界1位を獲得したことを受け、同大大岡山キャンパスにて、TSUBAME-KFCに用いられている技術の説明を行った。

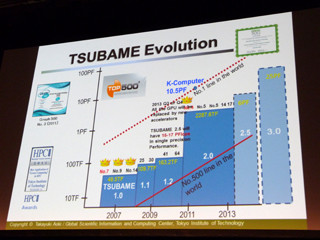

2016年の稼働が計画されている次世代スパコン「TSUBAME 3.0」では、初代の「TSUBAME1.0」と比べて電力性能比1000倍の実現が目標となっている。TSUBAME-KFCは、そうした電力あたりの性能を高めるためのテストシステムとして開発されたもので、同大 学術国際情報センター(GSIC)の松岡聡 教授は「現在、エンタープライズ分野では省電力化と高性能化を両立させる手法として仮想化による統合が主流となっているが、ハードウェアそのものの性能が必要となるスパコン/HPC分野ではそういった手法は適さない。そのためHPC分野にマッチする新たな技術の開発を行う必要があった」と、その背景を説明する。

具体的には、TSUBAME-KFCでは、TSUBAME3.0におけるシステム全体のエネルギーコントロール技術の開発に向けたテストが行われているとのことで、「液浸冷却技術は、温度を一定に保ちやすいという利点があり、将来の実用化に向けた、その技術の確立と、環境の再現性の確保を目指したシステムを開発した。また、最近では、TSUBAMEの廃熱をエネルギーとして再利用しようという話もでてきており、こうした将来に向けたさまざまな実験を行える環境を整えることで、さらなる省エネを図っていくことが目標」(同)だという。

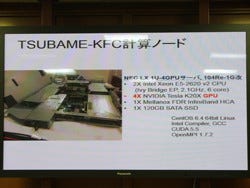

TSUBAME-KFCはテスト環境ということもあり、42UラックにIntel Xeon E5-2620 v2プロセッサ(Ivy Bridge EP)を2基、NVIDIA Tesla K20X GPUを4基搭載したNECのLX104Re-1Gの改良版(通常版はGPUを3枚までだが、4枚まで搭載可能とした)となる高密度な1Uサイズのサーバを40台とFDR InfiniBandネットワークで構成された小規模なシステムとなっている。

通常のサーバラックは縦置きだが、TSUBAME-KFCはGreen Revolution Cooling(GRC)製の横置きラックを用いて、そこにExxonMobil Chemicalの「SpectraSyn 8」を触媒油として入れ、サーバを浸している。2013年8月に掲載したHisa Ando氏の松岡教授へのインタビュー時では、GRCの油の引火点が日本の消防法の規定を満たさなかったため、代替品を探しているとしていたが、最終的には消防署などとの協議の結果、引火点が260℃である同油に落ち着いたという(TSUBAME-KFCの実際の稼働は2013年9月末ころから)。

|

|

|

|

TSUBAME-KFCの40台の計算ノードが収納されているGRCのサーバラック(左)。透明な油に浸されている40台の計算ノード(中央と右)。あまりに透明なため、天井の蛍光灯の反射がないと、パッと見わかりづらい |

||

また、油を用いているため、CPUやGPUとヒートシンクの間に一般的に用いられるグリスが溶け出す可能性があるということで、そこを熱伝導シートに変更しているほか、冷却ファンも不要となるため外すなどの工夫が施されている。

冷却の流れを簡単に説明すると、まず各サーバが熱を出し、それにより油が温められる。温められた油は、水と気化熱を利用した2次冷却システムにて冷やされ、再びサーバ側に戻される。この冷却システムの場合、水を外気で冷却することになるが、天候や時間によって冷却温度が変わるため、雨天、曇天、晴天などのさまざまな環境下にて比較を行っており、気温と湿度、外気の露点温度などが変わることで、各冷媒の温度に影響を与えることが分かってきたという。

|

|

GRCのサーバラックの機構イメージ。各チップなどの熱で温められた油が上に行き、それを下に向かって流すことで、循環を生み出す。下に流れた温められた油は、2次冷却水と熱交換をして、再び冷まされ、システムの中を循環する |

また、稼働して1カ月程度だが、油浸冷却では、各計算機そのものの電力を低減できることも確認されたという。これは大気(空気)と液体の比熱に差があるためで、例えば28℃の油の方が、26℃の大気温度よりもプロセッサの温度が低くなり、結果として、システム全体として8%の電力を削減できることが確認されたとする。

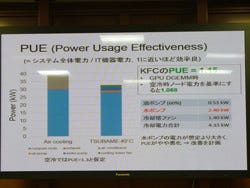

このため、データセンターやサーバルームなどのエネルギー効率を示すPUE(Power Usage Effectiveness)は1.15だが、コンピュータの使用電力そのものが下がっていることを加味すると、実際にはそれ以上に電力の削減を果たしていることになる。

|

|

TSUBAME-KFCのPUEは1.15。Hisa Ando氏のレポートにもあるが、冷却水を作るために必要な水ポンプが意外と電力を消費してしまうことが分かったため、TSUBAME3.0にTSUBAME-KFCのシステムがそのまま適用されるといったことはないという |

テストシステムながら、ここまでの電力性能比を達成できているのであれば、そのままTSUBAME3.0にも適用できそうだが、液浸の利用はTSUBAME3.0の後、TSUBAME4.0以降を見据えたものになると松岡教授は語る。「1年間の運用を、さまざまな気象条件で行い、最適化を図っていくことが重要。そもそも現代の東京の気象条件で、安定して動かせるか、という問題が出てくる。また、自然大気冷却やエネルギー回生システムを用いようと思った時に、実際にはどういった温度条件が必要になるのか、などについては実際に経験してみないと分からない。さらに、油を使った冷却の耐久性や、油になにかサーバで使用されている物質が溶け出さないか、といったこともまだまだ不透明で、それらの調査も必要」とのことで、TSUBAME3.0には、次世代プロセッサや積層メモリ、不揮発性メモリなどの次世代技術を利用して、消費電力の低減を図ることで、「2020年ころと言われるエクサスケールの時代にかなり近いところまで到達できると見ている」(松岡教授)とする。

|

|

|

|

|

東工大 大岡山キャンパスの学術国際情報センター脇に設置されている「TSUBAME-KFC」。目の前には、同大の前身である東京職工学校、東京工業学校、東京公道工業学校の校長などを務められた手島精一先生のブロンズ像がある |

|||

また、「東工大としてはTSUBAME-KFC、TSUBAME3.0などを通じて、世界トップのリーダーシップを発揮し、それを今後の日本のスパコン開発に転用し、日本のIT産業の発展につなげていければ」(同)としており、低消費電力ながら高性能のHPCの実現に向けた取り組みを今後も継続していき、その分野で日本の存在感を高めていきたいとした。