7つのプログラムで28項目を測定「HPC Challenge」

また、連立一次方程式の解という1つのプログラムの性能だけを競うTop500の欠点を補うために開発された「HPC Challenge」は、7つのプログラムで28項目の測定を行うことにより、より多面的にスパコンの性能を評価するようになっている。

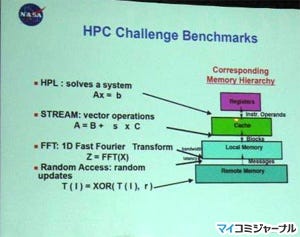

このHPC ChallengeについてもSC08のHPC Challenge BoFで入賞者の発表と表彰が行われた。前述のように7つのプログラムで28項目の測定を行うのであるが、28項目の内には、S-のついた1つの計算ノードの性能だけを測るものや、それぞれの計算ノードが独立に処理を行うEP-がついた測定と、システム全体が連携して1つの問題を解くG-がついた測定項目がある。そして、この28項目の内、G-HPL、G-STREAM、G-FFTE、G-Random Access の4項目が主要性能測定として表彰の対象になっている。

HPLは、処理としてはLinpackとほぼ同じであるが、Top500のLinpackはプログラムは自分のシステム用に最適化したものを開発して使用してよいが、HPC ChallengeのHPLは測定するソースプログラムは与えられており変更できない(ただし、行列の掛け算のdgemmなどのライブラリは、測定マシン用に最適化したものを使って良い)という点が異なる。

HPLは主にレジスタとキャッシュの間の転送性能を評価し、配列データに単純な演算を行うSTREAMはキャッシュとメインメモリ間の転送性能を評価する。そして、FFTとRandom Accessは計算ノードのメモリ間のデータ転送に負荷のかかる処理である。

|

|

HPC Challengeの主要4項目の測定対象を示すスライド |

また、HPC Challengeの表彰は2つのクラスがあり、クラス1はこれらの主要ベンチマークの性能を競うものであり、クラス2は解法の性能と優雅さを競うものである。

今回のHPC Challengeのクラス1のG-HPLでは、1位がORNLの新Jaguarシステムの902TFlops、2位がLRNLのBlueGene/Lシステムの259TFlops、3位がアルゴンヌ国立研究所(ANL)のBlueGene/Pシステムの191TFlopsであった。

そして、G-STREAMも同じ順位で、スコアは、それぞれ330TB/s、160TB/s、130TB/sであった。G-Random AccessはANLのBlueGene/Pが103GUPSでトップに立ち、2位はLRNLのBlueGene/Lの35GUPS、3位はSandia国立研究所(SNL)のCray XT-3システムの34GUPSであった。

そして、G-FFTEはANLのBlueGene/Pが5080GFlopsで1位、SNLのCray XT-3システムが2870GFlopsで2位、そしてORNLの新Jaguarシステムが2773GFlopsで3位で表彰を受けた。

なお、表彰のやり方はとてもカジュアルで、名前を呼ぶと表彰者がトコトコと出てきて、賞状を貰って握手をすると、そそくさと席にもどってしまうので、綺麗な写真が取れないで困った。

|

|

G-STREAMの1~3位の表彰 |

なお、11月12日にNECは、東北大学に納入したSX-9システムが28項目の内の19項目でトップとなり、HPC Challengeベンチマークで世界最高速を達成と発表したのであるが、システム全体の性能を測定し表彰対象となるベンチマーク項目は1つも含まれていないようである。

トップとなった項目数が多くても、表彰対象にならない単体プロセサの性能とクロスバの性能を中心とする項目での最高性能で、「HPC Challengeベンチマークで世界最高速を達成」は、ちょっとミスリーディングな発表である。

クラス2は、Chapelで書いたCray、X10で書いたIBM、そしてParallel MATLABで書いたMathWorksの3社がファイナリストとして選ばれており、3社がそれぞれの解法について10分程度のプレゼンテーションを行い、上記のクラス1の表彰を行っている間に審査員が審議を行った。

その結果、クラス2は、性能ではIBMがトップとなったが、エレガントさでは審査員の意見が割れ、3社の発表が同列という評価になった。

結果として、クラス2の2000ドルの賞金は、 性能でIBMが1000ドル、そしてエレガントさの方は3社が333ドルと33セントを受け取ることになった。

なお、来年のSCはオレゴン州のポートランドで開催されることになる。