A100搭載エッジAIプラットフォームも登場

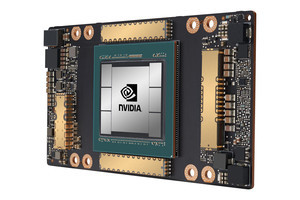

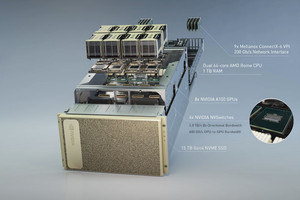

また、NVIDIAは組み込み用の「EGX A100」を発表した。次の図のように、A100 GPUと、買収を完了したMellanoxのConnectX6 DX NICを搭載したボードになっている。ボードの右側が円弧状に切り欠かれているが、その理由については説明が無かった。

このEGXボードで面白いのは、NVIDIAロゴが書かれたGPUチップの背面が見える点で、本物はメタル配線のようなパターンは見えないことが分かる。もう1つ興味深いのは、GPUの左右に灰色のDC-DCコンバータがたくさん並んでいる点で、EGXボードの電源は、48Vではなく12V給電になっている点である。多くの組み込み機器では48V DCの供給がないことに配慮したと思われる。

インターネットのページのランク付けを行うサーバは、1280億エッジのグラフを扱う現在のシステムは105本のラックに3000台のCPUサーバを必要としているという。

これをDGX A100に置き換えると4台のDGX A100を、External NVLinkで接続すれば実現でき、処理性能的にも520億エッジ/秒であったものが6880億エッジ/秒と13倍の性能に向上し、コストは1/75と劇的に安くて済むという。13倍にも性能が上がるならDGX A100を4台も使わず1台で済みそうであるが、なぜ、こういう構成での比較になっているのかは分からない。

なお、DGX 2の世代では複数のDGX 2を接続する機能はなく、DGX A100でNVLink 3による外部接続が可能になった。

-

インターネットのページのランク付けは、4台のDGX A100をNVLinkの外部接続の機能を使って接続すれば実現でき、同時に処理性能は1280億エッジ/秒と13倍に向上し、コストは1/75で済むという

700PFLOPSの性能を持つ、次世代のDGX SuperPOD

大規模システムとして、NVIDIAはDGX A100を140台収容する「SuperPOD」を発表した。SuperPODには140台のDGX A100システムが収容でき、170台のMellanoxのQuantum 200G InfiniBandスイッチが含まれる。これらは280Tb/sのネットワークファブリックで結ばれ、光ケーブルの総延長は15kmになるという。そして、これに4PBのオールフラッシュのストレージが付く。

このシステムはAI計算では700PFlopsの性能を持つ。このように巨大なシステムであるが、3週間以下で作ることができるという。

NVIDIAはSATURNVというスパコンを社内に設置しているが、今度、4台のDGX SuperPODを追加する予定であるという。これでDGX A100が560台追加されるので、ピーク演算性能は2.8ExaFlops増え、SATURNVの総演算性能は4.6ExaFlopsとなる。

-

NVIDIAは社内のAIスパコンの需要も多く、4台のSuperPODを増設する。現在1800台のDGXで1.8EFlopsのSATURNVは、この増設で560台のDGX A100が追加され。総計4.6ExaFlopsのシステムとなる

NVIDIAは各種のAIフレームワークを自社開発してユーザに提供しており、今回のGTCでもディープラーニングを使ってリコメンデーションを行うNVIDIA Merlinや会話型のサービスを提供するJARVISを発表した。また、自動運転のシステム開発にも力を入れており、NVIDIAの技術陣は自社のAIスパコンの大口ユーザであり、SATURNVスパコンのアップグレードを待ち望んでいるとのことである。