PC向けの製品ということでは、NVIDIA GPUがTSMCを利用しているので、そちらを中心とした話になる。もっともFoundry Business全体で言えば、TSMCが全体の半分以上(2016年末だと59%。まだ2017年度のレポートは出ていない)を占めており、TSMCの動向がFoundry Business全体に大きな影響を与えていることは確かだ。

そのTSMCは2017年にロードマップを変更している。元々のロードマップは

16FF+→10FF→7FF

というシンプルなものだったのが、以下のように変わった。

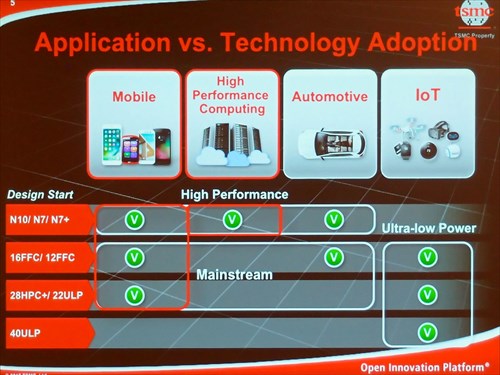

- ハイパフォーマンス:16FF+→10FF→7FF→7FF+(7FF EUV)→5FF

- メインストリーム:16FFC→12FFC→7FFC

16FF+と10FFの合間というか、10FFと並行する形で12FFNが挟まっていたりするので、ちょっと分かりにくいので、ちょっとこの辺りを解説したい。

ハイパフォーマンス向けとして、16FF+はPascal世代のGPUなどで広く利用されている。ただし、これに続く10FFについては、AppleのA10XやA11などに採用されたものの、実際には16FFと比べて十分な性能が出ない(TSMCの公式発表では16FF+と比較して消費電力が40%削減、性能が20%向上、エリアサイズを50%削減とされる)ということで嫌われており、それ以外の採用があまり進んでいない。

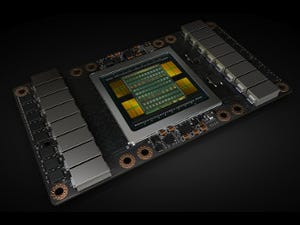

ではNVIDIAはどうしたか? というと、10FFの代わりに、いわば16FFFとでも言うべき12FFNをほぼNVIDIAスペシャルとしてTSMCに製造させ、これを利用してVoltaを投入した。ちなみにこの12FFNは16FF+に、12FFC用の6 Track Cell Libraryを適用したもので、プロセスそのものはほぼ16FF+のまま(微妙にOptical Shrinkを掛けてはいるらしい。これは16FFC→12FFCの際にOptical Shrinkを掛けている関係の模様)である。

そのVolta、性能そのものは特に機械学習で猛烈な性能アップが果たされているが、これは新たに搭載されたTensor Coreによるもので、GPUに向けた既存のIntegerコアはまったく違いが無い。

要するに6 Track Libraryを利用してエリアサイズを縮めることで、Tensor Coreを追加できる領域を捻り出した形だ。逆に言えばプロセスそのものの改善はほとんど無く、むしろ6 Track Libraryを利用した結果、動作周波数は若干落ちており、これをコア数でカバーしている。

12FFNはいまのところNVIDIA、それもVolta専用であり、他のGPU向けに利用するかどうかも定かではない(可能性はあるが)。そんなわけで一般向けのロードマップには記載されておらず、次は7FF(スライドの表記ならN7)に期待が集まっている(Photo24)。