デジタル世界の市民権を保護する法的な活動を行う非営利組織EFF(Electronic Frontier Foundation)のコリーン・マクシェリー氏が、昨年末に「User Generated Content and the Fediverse: A Legal Primer」(ユーザー生成コンテンツとFediverse:法律入門)という、MastodonなどFediverseインスタンスをホストする上での法的なリスクを軽減するためのガイドを公開した。

インスタンスを立てるのは簡単ではないものの、すでに情報が蓄積されていることもあって、技術者ではない個人でも挑戦でき、趣味的な感覚で開始するケースも少なくない。 しかし、規模の大小にかかわらず、インスタンスの運営者は単なるサーバの管理者ではなくサービスプロバイダーになる。費用や管理の時間のようなコストだけを計算して、法的な問題への対応を疎かにすると、著作権やプライバシーを侵害する問題が起こった際に管理不備の責任が問われる。ケースによっては、違反が破滅的な損害賠償につながる可能性も。しかし、過度に怖がる必要はなく、それを踏まえて事前に対策を立てておけば、比較的簡単ないくつかの方法でリスクを軽減できるとしている。

例えば、米国ではデジタル・ミレニアム著作権法(DMCA)によって、サービスプロバイダーが著作権保有者またはその指定代理人から侵害の申し立て通知を受け取った際に当該コンテンツを迅速に削除すれば、著作権侵害の責任が免除される「セーフハーバー」免責を認めている。それによって二次的責任にまつわる複雑な法律問題や法的責任を問われるリスクから身を守れる。ただし、セーフハーバーは自動的に適用されるわけではなく、著作権局にDMCAエージェントを登録する必要があり、DMCAポリシーを定めてそれを実施しなければならない。

また、通信品位法の第230条によって、利用者の発言に対する様々な法的な責任からプラバイダーは原則的に保護されている。こちらは自動的に適用されるが、売春のような人身取引を助長または促進するコンテンツは保護対象から外されるので注意が必要になる。他にも、プライバシーと匿名性に関してユーザーのデータや情報を保持することで起こり得ること、プライバシーが関わる問題の対応をスムースにするためのガイドラインや透明性報告書、CSAM(児童性的虐待コンテンツ)に関する義務などについて解説している。

イーロン・マスク氏が10月末にTwitter買収を完了してから、大胆な改革を矢継ぎ早に打ち出したことでTwitterのアクティブユーザー数が過去最大を記録した。その一方で、マスク氏個人の意向にコントロールされるプラットフォームを嫌って、TwitterからMastodonのような分散型ソーシャルネットワークに移行する動きも加速している。

-

Mastodonの生みの親であるオイゲン・ロッコ(Eugen Rochko)氏が昨年12月20日に公開したブログ記事によると、その時点でアクティブユーザーが約250万人に拡大。10月末にイーロン・マスク氏がTwitterを買収する前の約30万人から8倍以上の規模になった。

Mastodonが話題になったことは過去に何度かあったが、今回は「ティッピングポイントに向かっている」と言われるぐらい勢いに違いがある。MozillaなどオープンソースプロジェクトがFediverseインスタンスに乗り出し、TumblrがActivityPubの導入を表明したのが話題になった。既存のMastodonインスタンスに企業がアカウントが作成することも珍しくない。Mastodonインスタンス(サーバー)も急増している。

インスタンスごとに独自のルールを持つコミュニティを築けることがMastodonのようなFediverseインスタンスの大きな長所である。ソーシャルメディアの経験をカスタマイズし、自由にコントロールすることができ、一部の技術大手によって作られたモノカルチャーに依存する必要がなくなる。米国ではFacebookの存在感が薄れ、InstagramはTikTok世代に対応する過渡期にあり、Twitterは崩壊が懸念され、TikTokは米国で政府関連のデバイスで禁止されている。ソーシャルネットワークが不安定な状況にある中で、Fediverseによって様々なオーディエンスのニーズを満たす小さなコミュニティが形成され、「多くのソーシャル・プラットフォームの時代」が始まることへの期待は高い。

しかし、爆発的な拡大の負の影響も見られる。Twitterの混乱によって分散型ソーシャルネットワークについて理解を深めないまま、Twitterの代わりという感覚で移行する人が増えている。そのためインスタンスの運営方針やローカルルールを確認せずにアカウントを作った人達と管理者の間でトラブルが起こり、嫌がらせや誹謗中傷に発展することも。トラブルの深刻化が頻発すると、いずれ「インスタンスを立てるのをやりたがる人が出てこなくなる」(マクシェリー氏)。だから、このタイミングでガイドを公開した。

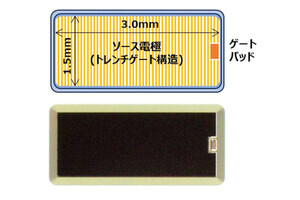

EFFのガイドは米国法の対象となるインスタンス管理者向けだが、日本のユーザーにも無縁ではない。2020年5月に日本最大級のMastodonインスタンス「mstdn.jp」が同年6月末での提供終了をアナウンスした。ネット上の誹謗中傷の問題が深刻化し、適切に対応していくための事務負担に耐えられる見通しが立たなかったためだ。ところが数週間後、Sujitechへの譲渡が決まって一転存続になった。カラオケ法理が争点になり得る日本に比べて米国は法律や規制面でインターネットサービスの成長を促す環境になっており、米国内の会社への移管によって存続が可能になった。

この日米の違いについて、DMCAとプロバイダ責任制限法を比べる議論になることが多いが、EFFのようなデジタル世界の公共の利益という弁護士にとって儲けにならない分野で、使命感を持って闘っている弁護士達と非営利組織が存在することも大きい。

-

EFFの設立は1990年。弁護士、アクティビスト、テクノロジストで構成され、まだ法が整備されていなかったデジタル分野において、テクノロジーやインターネットの恩恵を人々が十分に享受できるように、また国家や企業に過剰に管理されないように法の専門家の立場からイノベーションを後押ししてきた。

EFFは中央集権的なサービスを否定し、分散型を良しとしているわけではない。「正しいことをしている時は味方になり、間違ったことをしている時には最強の批評家になる」というのが企業に対するEFFのスタンスであり、現時点でTwitterの改革に対して批判的ではない。

昨年4月にThe VergeとのインタビューでEFFのエグゼクティブ・ディレクターのシンディ・コーン氏は「人々が相互運用可能なものが作ろうとする時、私達はそれをサポートしたいと考えます」と述べ、そして「分散型ソーシャルネットワークを構築しようとする取り組みの多くは法律上の問題にぶつかると思います」と指摘していた。

「特にオープンソースのプロジェクトや、世界が必要とするものを作っているけれども弁護士に依頼する資金がないという人たちをできる限り助けたいと思っています。だから、(分散型ソーシャルネットワークに)私たちは関わっているのです。私たちは技術の可能性と同時に落とし穴も理解している、良識ある人々でありたいと思っています」(コーン氏)。