Micron Technologyは、データセンターのAIサーバに搭載されるAI GPU向け高性能メモリとなる「HBM3E」がNVIDIAに採用されたこと、ならびに新たなメモリソリューション「SOCAMM(Small Outline Compression Attached Memory Module)」の量産出荷を開始したことを明らかにした。

-

SOCAMMとHBM3E 12H 36GBの概要。SOCAMMがNVIDIAのGrace(CPU)向け、HBM3E 12H 36GBがB300/GB300(GPU)向けという扱いとなっている (資料提供:Micron、以下すべて同様)

出荷が開始されたSOCAMMは、NVIDIA GB300 Grace Blackwell Ultra SuperchipをサポートするためにNVIDIAと共同開発されたモジュール型のLPDDR5Xメモリソリューションで、同社ではデータ処理の高速化、優れたパフォーマンス、比類のない電力効率、そしてサービス性の向上を実現し、AIワークロードの増加に対応する高容量メモリを提供すると説明している。具体積な性能としては、14mm×90mmという業界標準のRDIMMフォームファクターの約1/3の大きさとなり、コンパクトかつ高効率なサーバデザインを実現することができるほか、LPDDR5Xの採用により、標準のDDR5 RDIMMと比べて消費電力も1/3に削減することを可能としたとする。

また、16ダイ積層のLPDDR5Xメモリを4つ配置して128GBのメモリモジュールを実現。同容量のRDIMMと比べて2.5倍以上の帯域幅を提供することで、より大規模なトレーニングデータセットや複雑なモデルへの高速アクセスを可能とするとともに、推論ワークロードのスループットの向上ならびに同時ユーザー数の増加を可能とするとしている。

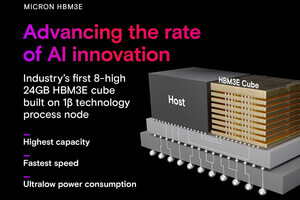

一方のHBM3Eは、ラインアップとして8層で24GBの「HBM3E 8H 24GB」ならびに12層で36GBを実現した「HBM3E 12H 36GB」の2種類を用意。HBM3E 8H 24GBは、NVIDIA HGX B200およびGB200 NVL72プラットフォーム向けに提供されているとするほか、HBM3E 12H 36GBは、NVIDIA HGX B300 NVL16およびGB300 NVL72プラットフォームに採用されている。

同社では、HBM3E 12Hは、同じキューブフォームファクター内でHBM3E 8H比で50%の容量増加を実現しつつ、競合他社のHBM3E 8H 24GBと比べて消費電力の最大20%削減できるとするほか、次世代となるHBM4については、HBM3E比で50%以上のパフォーマンス向上が期待されるともする。

SOCAMMやHBM3Eのほかにも、同社はAIワークロードの増大する需要に対応するために設計されたストレージ製品を幅広く展開しているとしており、NVIDIAが開催した「GTC 2025」においても、「Micron 9550 NVMe」および「Micron 7450 NVMe SSD」がGB200 NVL72推奨ベンダーリストに追加されたとするほか、「Micron PCIe Gen6 SSD」が主要なPCIeスイッチおよびリタイマベンダーとの相互運用性テストで27GB/sを超える帯域幅を実現したこと、ならびに「Micron 61.44TB 6550 ION NVMe SSD」が最先端のAIクラスター向けエクサスケールストレージソリューションに最適な、1ラックあたり44PB以上のストレージ、14GB/s、200万IOPS/ドライブを20Wの消費電力で実現したことなどが紹介されたとしている。

なお、AIデータセンター向け以外にもMicronでは、自動車、産業機器、コンシューマ向けのAIソリューションの提供に向けて主要なエコシステムパートナーと緊密に連携しているともしており、例えばNVIDIA DRIVE AGX OrinプラットフォームへのMicron LPDDR5Xの統合によって、処理性能と帯域幅の向上と同時に消費電力を削減できること、1β nmプロセス採用のLPDDR5Xを活用することで、自動車や産業向けの要件を満たしつつ最大9.6Gbpsの速度と128Gビットの容量を提供が可能としている。また、LPDDR5X自動車向け製品については、-40℃~+125℃の動作環境をサポートし、自動車の品質基準と規格に対応する広範な温度範囲を提供するともしている。