京都大学(京大)は3月5日、統計学的分析によって、人工知能(AI)の性能評価指標そのものの有効性を網羅的に検証し、分野を問わず正確にAIの性能を評価できる手法を開発したと発表した。

同成果は、同大医学研究科のJ.B.Brown 講師によるもの。詳細は米国の科学誌「Molecular Informatics」に掲載された。

AIによるビッグデータ解析は、医療現場や市場分析など社会のさまざまな分野での活用が進み、今後さらなる普及が予想されている。また、創薬研究などで分子モデルの有効性を予測する場合にも、AIは主要な検証手段として重視されている。

しかし、特定の分子を検出するような場合に、実験における検出成功率が、コンピュータモデルによる事前予測を大きく下回るという事例がしばしば報告されている。

その根本的な原因は、コンピューターモデルすなわちAIの性能を過大に評価した統計的指標にあると考えられる。これまでは、AIの性能評価指標としてTPR(真陽性率)とACC(正確率)をはじめとする数種類の指標が用いられてきたが、これらの指標は本当にAIの性能を正しく評価できていたのか疑問が残っていた。

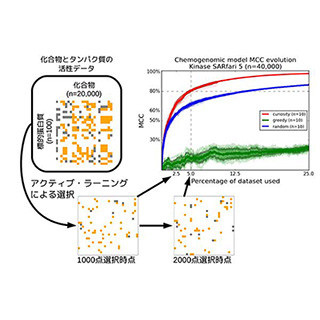

今回の研究では、AIの性能を統計的指標によって正確に評価する手法を開発した。この手法は、TPRやACCなど各指標の特性と有効性を、分布関数(iCDF)を使った統計学的な解析によって検証するものだ。

検証の結果は、AI技術に関わらずに、TPRやACCなどでの高評価値を得られる確率が高く、実応用の有効性につながらない可能性が高いことを示した。さらに、AIの開発と評価実験を行う前に、新手法によって評価指標そのものの特性を十分に吟味するべきであることが分かった。

なお、今回の成果を受けて研究グループは、同成果を活用できるように、論文の追加データとしてヒートマップとiCDFを作成するプログラムを公開したという。どのようなデータセットに対しても、実証実験で正確な分類ができる「堅牢な」AIの開発に貢献することが期待されるとしている。