早稲田大学(早大)は5月28日、これまでロボットが苦手としてきた布や紐など接触により形状が変化する不定形物を扱う作業に対し、動作を人が数回教示したり、言語指示から過去の似たような動作を参考にしたりするなどして、新しい動作を編み出せる深層学習型のロボット制御技術を開発したと発表した。

同成果は、早大 理工学術院の尾形哲也教授、日立製作所の共同研究チームによるもの。その詳細の一部は、5月31日から6月6日まで中国・西安国際会議展示場で開催される「The 2021 International Conference on Robotics and Automation(ICRA 2021)」と、6月6日から8日までオンライン開催される「日本機械学会 ロボティクス・メカトロニクス講演会2021 in Osaka(ROBOMECH2021)」のポスターセッションにて発表される予定だ。

従来のロボット制御技術の場合、物体認識で得られた情報をもとに、対象物の向きや形状に対する想定可能なすべての動作を人手でプログラム(軌道計画)することが求められていた。そのため、布や紐などのように接触により形状が変化する不定形物を操作する動作では、すべての状況をプログラムで記述するのが難しいという課題があった。

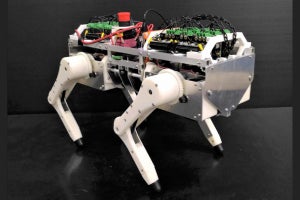

今回開発された制御技術は、人がロボットに所望の動作を複数回教示するだけで、ロボットの視覚・触覚情報から着目すべき情報(対象物の位置や方向など)と、その時に取るべき動作を自動抽出し、不定形物作業中の新たな状況に対する動作も、プログラミングレスで実行することが可能だという。

また、人の言語指示(音声やテキスト文などの人が理解できる情報)に基づいて所望の動作を実現するためには、言語指示と動作の関係をすべて、従来は人手でプログラムする必要があり、動作や対象物を追加するたびに言語指示との対応付けを行う必要があったが、今回の研究では、ロボット自身の動作と対象物、そして言語指示の関係を学習させ、データベースに記憶させることで、まさに人に指示をするのに近い形で新たな作業も指示ができるようになったとする。

さらに、対象物の物理的特徴(色や形状など)と動作内容(つかむや押すなど)を含んだ言語指示から、データベースに記憶された類似動作の連想結果を動作生成モデルに入力することで、未学習の言語指示であっても所望の動作を自律的に実行することができるという。

これにより、例えば「赤い箱を取って」とこれまでにしたことのない動作を言語指示された場合、過去の動作で、赤や青の箱を押したり、青い円筒を取ったりした(つかんだりした)ことがあった場合、赤い箱と青い箱の違いを認識し、なおかつ取る(つかむ)という動作を組み合わせ、赤い箱の位置を認識し、円筒ではなく箱をつかむ形でハンドの制御を行い、赤い箱をつかむことができるようになるという。

なお研究チームでは今後、ロボットが導入されていない(ロボットの導入が難しい)、さまざまな現場作業を自動化することで、人の作業を支援するシステムを構築し、少子高齢化に伴う労働力不足の解決を目指すとしている。

形状が変わる物体のハンドリングに対応する深層学習型ロボット制御技術(解説)-日立