ビジネスのあらゆる領域でAI活用が推進されるようになった現在、AI市場はこれまでにない盛り上がりをみせている。さまざまなAIツールやフレームワークがリリースされ、開発ノウハウも蓄積されるなど、AI活用の裾野は広がっており、分野を問わずAI導入の検討が進められている状況だ。

そのなかで重要度を増しているのがAI開発環境の選択である。膨大なコンピューティングリソースが必要なAI開発においては、自社が“やりたいこと”を明確化し、最適なシステム構成を見出すことが求められる。ここで選択を誤るとリソース不足で成果が出せなかったり、成果に見合わないコストがかかったりといった事態を招くことになりかねない。

本稿では、「AI Everywhere」のコンセプトを掲げ、データセンター、クラウド、エッジでAIワークロードを強化するためのプロセッサーを展開するインテルの呉 孝展 氏と、先進のAI機能を特徴とするインテル® Core™ Ultraプロセッサーを搭載したAI PCを発表し、AI開発向けのワークステーションの販売も行っている日本HPの大橋 秀樹 氏がAIをテーマに対談を実施。そのなかで明かされたAI開発の現在地や開発環境構築のポイントを紹介したい。

対談者

株式会社日本HP

エンタープライズ営業統括 ソリューション営業本部 本部長 大橋 秀樹 氏

インテル株式会社

クライアントコンピューティング営業本部 営業戦略スペシャリスト 呉 孝展 氏

“実はとても重要” AI開発における見落とされがちなCPUの役割とは

呉氏:AI開発環境はサーバー、クラウド、ローカル環境(ワークステーション)と、さまざまな選択肢が存在します。グローバルでは、サーバー市場の約2割がAI用途で導入されているという調査結果が出ており、同じくワークステーション市場も、約2割がAI開発用途で活用されていると考えられています。IDCの調査では、AI×ワークステーションのマーケットは、2024年までに年間25億ドル規模にまで拡大すると予測されており、注目度が高まっている現状が伺えます。

大橋氏:インテルでは、サーバー向け、ワークステーション向けにXeonプロセッサーのラインナップを拡充されていますが、AIワークステーションが注目されている理由についてどのように考えていらっしゃいますか。

呉氏:AI開発などにおいて、GPUをコンピューティングリソースとして利用するというアプローチが一般化してきたなかで、AI=GPUというイメージを持つ方も多いと思います。ですが、AI開発と一口に言っても、データの整理・分析からモデル構築、トレーニング、推論処理とその内訳はさまざまで、そのすべてにGPUが必要というわけではありません。

たとえばモデルトレーニングに関してはGPUに強みがありますが、データの準備や分析においてはCPUのほうが使いやすい面もあります。そのため、CPU性能を重視してワークステーションの導入を検討する企業も増えてきました。

大橋氏:確かにAI開発において、プロセッサー(CPU)の重要性は認識されていないと感じています。学習でも推論でも、高性能なGPUさえあれば良いという考えを聞くこともめずらしくありません。極端な話、インテル® Core™ プロセッサーシリーズを搭載するPCでも、グラフィックボードのハイエンドモデルが載っているPCならばAI開発には十分と思っている方も多いのではないでしょうか。

呉氏:データサイエンティストの各作業の割合を調査したところ、「データローディング」(19%)、「データ整理・フィルタリング」(26%)、「データ分析・可視化」(21%)、「モデル選択」(11%)といった作業は、実はGPUではなくCPUで行うほうが効率的と考えられています。

つまり、データサイエンティストが行う作業のうち、77%の作業がCPUに向いているというわけです。また、CPUでこれらの作業を実行する際には、CPUの性能はもちろん、大容量のシステムメモリ(DRAM)も必要となります。膨大な量のデータをメモリ上にロードして処理を行うことで、高いパフォーマンスを得られるからです。このため、高性能CPUと大容量のメモリを搭載できるワークステーションは、AI開発環境の構築において非常に有力な選択肢となります。

大橋氏:これまでのAI開発では、GPUのVRAM上にロードするデータが溢れたときに使うのがシステムメモリという認識で、システムメモリの容量や速度はそれほど重要視されていませんでした。ですが、CPUで行う計算領域を明確化すれば、必要なメモリ容量も見えてきますし、作業によってDRAMとVRAMを使い分けることができる。その意味では、GPUはもちろん、大容量のシステムメモリも搭載できるワークステーションへの注目が髙まっていることが理解できます。

呉氏:また、サーバーやクラウドでAI開発を行う際の懸念を払拭できるのも、ワークステーションのメリットといえます。たとえば多くの社員が共同で利用しているサーバー上にAI開発環境を構築した場合、ネットワーク帯域を占有してしまい、他の業務に影響を及ぼしてしまう可能性が否めません。サーバーリソースを数時間占有したものの、報告できるような結果が出なかった、となってしまうと、その後の開発に積極的に取り組みづらくなることもあり得ます。

高性能なクラウドサーバー上のVMでAI開発を行うケースでも同様で、長い時間をかけて分析を行った場合、結果の有無にかかわらず従量課金でコストはかかり、ストレージ利用料も含めると年間コストは膨大になってしまいます。また、コストがかかれば、当然結果も求められるため、データサイエンティストにかかるストレスも相当のものとなるでしょう。一方、ワークステーションならば、ローカル環境に設置された自分だけのマシンで作業できるため、リソースやコストを気にすることなく開発に専念することが可能になります。

大橋氏:とはいえデータサイエンティストが、こうしたボトルネックを考えたうえで、開発環境を構築できるかというと、そこまでの余裕がないケースがほとんどではないでしょうか。結果を出すことに注力したいと考える方も多いと思います。そのため、今後はベンダー側が、ユーザー企業のニーズを汲み取り、最適なシステム構成を提案していく流れが主流になってくると考えています。

AI開発を行うためのシステム構成に“最適解“はあるのか

呉氏:AI処理のパイプラインは、データの準備、モデルのトレーニング(ML/ディープラーニング)、推論処理(デプロイ)という流れになります。現在、大規模なディープラーニングのモデルトレーニングはサーバーで行うケースが一般的ですが、その前の段階であるモデルアルゴリズムの開発・テストではワークステーションを利用するという動きが加速しています。先に述べたようにローカル環境に設置できるためレスポンスと自由度が高く、メモリ搭載容量も大きい。自分専用のマシンならば、フレームワークやソフトウェアSDKの設定を毎回行う必要もなく、効率的な作業環境を構築することができます。

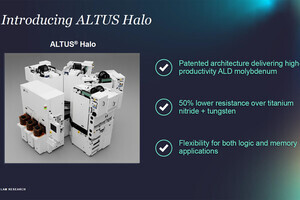

インテルでは、ワークステーション向けのCPUとしてインテル® Xeon® W-3400 プロセッサー、インテル® Xeon® W-2400 プロセッサーを提供しています。第4世代 インテル® Xeon® スケーラブル・プロセッサー(開発コードネーム:Sapphire Rapids)をベースに、ワークステーション向けに必要な機能を盛り込んだ製品で、ベクトル演算を高速化するインテル® AVX-512や、マトリクス(行列)演算を高速化するインテル® AMX(Advanced Matrix Extensions)など、AI機能を拡張するアクセラレーターを搭載しました。

システムメモリも最大4TB(W-2400は最大2TB)までサポートしており、Xeon Wベースのワークステーションであれば、データサイエンスにおける独自のワークフロー、ツール、ハードウェアのニーズに応えられると思います。

大橋氏:ここまでの話を聞いて、AI開発におけるXeonプロセッサーを搭載したワークステーションの役割について、理解を深めることができました。これまでデータ解析、HPC用途では、AVXアクセラレーターが搭載されたCPUでなければベクトル演算の高速化が図れない、という提案はしていましたが、AMXアクセラレーターが搭載されたSapphire Rapidsならば、GPUの領域とされていたマトリクス演算をCPUでも高速化できる、と案内できます。ベンダーとしては、Xeon搭載ワークステーションのメリットを改めて実感しました。

呉氏:また、先ほど大橋さんが話されたユーザー企業の環境に合わせたシステム構成を提案するという観点でいうと、AIフレームワーク/SDKを使用する際、それぞれCPUのどういった要素を必要としているか、というのも考えなければいけないと思います。

大橋氏:なるほど、つまりユーザー企業のニーズを汲み取るだけでなく、どのフレームワークやSDKを使用するのかまで想定しないと、システム構成の提案が難しいということですね。

呉氏:以前に弊社では、主要なAIフレームワーク/SDKが、CPUの5つの要素のうち、どの要素を必要としているかを調査したことがありました。5つの要素は次の通りです。

- CPUのコア数

- ベースクロック(周波数)

- AVX-512アクセラレーター

- メモリ容量

- NTEL DL BOOSTベクトル・ニューラル・ネットワーク命令 (VNNI)

結果としては、用いるフレームワークやその目的によって必要とされるCPUの要素はさまざまで、とあるAIフレームワークではCPUのコア数、AVX-512アクセラレーター、メモリ容量の3要素を必要としていました。一方で別のフレームワークでの検証では、ベースクロックとメモリ容量の2要素だけという結果も出ています。この調査からわかったのは、ユーザー企業の環境やニーズによってシステム構成のポイントは変化するため、すべての環境に対応する最適解というものは存在しないということでした。

大橋氏:これは非常に参考になる調査ですね。開発者も使用しているフレームワークにどのようなシステム構成が必要なのかを把握している方は少ないと思います。それ以前に、AI開発にどのフレームワーク、SDKを使うのかという部分でも、まだ手探りな企業が多いと感じています。

呉氏:AI開発に取り組む企業からは「システムを構築するうえで何を重視すれば良いのか」とよく聞かれますが、明確な回答は難しいです。どのようなフレームワークを使っていて、何を実現したいのか、まずはそこを知らないと正しい答えは出てきません。

「ハイエンド=デュアルソケット(デュアルCPU)」という認識も、必ずしも正解とはいえない

呉氏:インテル® Xeon® W-3400 プロセッサー シリーズのパフォーマンスとしては、興味深いベンチマーク結果があります。2世代前のW-3275(シングルソケット/28コア)、Xeon Gold 6258R×2(デュアルソケット/28コア×2)とXeon W9-3495(シングルソケット/56コア)で、pythonのフレームワークでパフォーマンス比較したもので、最新世代のパフォーマンスが25~75%向上していることが確認できます。

CPUのアーキテクチャが大きく進化しているので、この結果は妥当といえますが、興味深いのは古い世代ではコア数の差がパフォーマンスに反映されていない結果が出ていることです。使用したフレームワークがシングルノードを想定して作られているため、デュアルCPUの環境ではCPU間のデータ転送に遅延が発生したためと考えられます。

大橋氏:ワークステーション分野では、シングルソケットを採用した製品も増えていますが、ハイエンド=デュアルソケット(デュアルCPU)というイメージが強いなか、シングルソケットでコア数が多い最新CPUを選択することを躊躇する企業も少なくありません。ワークステーションベンダーとしても、シングルソケットを選ぶ動機付けが薄いと感じることがありましたが、このベンチマークからはメモリバンクも1つでシンプルにデータにアクセスできるシングルソケットの優位性も見えてきました。Xeon Wシリーズ搭載のワークステーションを採用する根拠の1つと感じます。

呉氏:並行処理を重視したフレームワークであればコア数の違いが活きてきますし、20コアがマックスのフレームワークで、どちらも20コア以上のCPUならばベースクロックの差が活きてきます。CPUの世代によるアーキテクチャの違いを含め、考えるべきポイントは多いといえるでしょう。

インテルでは、モバイルワークステーション(30~40GB、4万行のデータサイズ)に第13世代インテルCore i9 プロセッサー、メインストリームワークステーション(40~512GB、50~100万行のデータサイズ)にインテルXeon W7/W5-2400プロセッサー、エキスパートワークステーション(512GB以上、数千万行のデータサイズ)にインテルXeon W9/W7-3400プロセッサーを推奨していますが、これもユーザー企業のニーズや環境によって変わってくるので、あくまで指針の1つとして捉えていただければと思います。

AI PCに続く新しいAI開発のコンセプトは“AI ワークステーション”

大橋氏:最近の動向としては、金融機関など、これまで引き合いが無かった分野からAIの開発や推論のPoCを目的としたワークステーション導入のご相談が徐々に増えてきています。

ローカル環境でトライ&エラーを何度も試せるワークステーションは、サーバーやクラウド環境に比べてPoCに向いていると思います。とはいえ、中途半端なハードウェアを導入すると成果は出ない、時間も予算も無駄になるなど良いことがなく、ハードウェア環境がボトルネックとなり、AIを導入する価値が無いと判断されかねません。

ボトルネック、つまりパフォーマンスが上がらない要因を特定するのは難しい作業で、特にPoCの場合はハードウェアに起因するのか、フレームワークに起因するのか、問題を切り分けていく必要があります。

呉氏:サーバーやクラウドという選択肢を否定するつもりはありませんが、これからのAI開発環境においてワークステーションの重要性は高まっていくと思います。その意味でも、やりたいことや環境にマッチしたシステム構成を把握することが重要です。なかでも、CPUとシステムメモリの関係性を考えていくことが大切で、前述したように、77%に及ぶデータサイエンティストの作業には、CPUの処理能力と大容量のメモリが必要となります。

ここまで話してきた「AI=GPU」や「ハイエンド=デュアルソケット(デュアルCPU)」といった“思い込み”を払拭し、フラットな視点でニーズに合ったシステム構成を考えていけば、CPUとメモリに投資する価値があることに気づくはずです。

大橋氏:規模によってはサーバーが必須になるケースもあるかと思いますが、ワークステーションにおける自由度の高さと導入のしやすさは、やはり大きな魅力です。一方でテレワークが浸透した昨今では、ワークステーションの導入により、データサイエンティスト、AI開発者が出社を強いられるのではといった懸念もあります。ですが、日本HPでは低遅延のリモートデスクトップソリューション「HP Anyware」を提供しており、これを活用することで、柔軟なワークスタイルを維持したまま、ワークステーションを利用できるようになります。

呉氏:日本HPも、AIを重要なテーマとしてソリューションを展開されていると思います。最近ではインテル® Core™ Ultraプロセッサーを搭載したAI PCも発表されていますが、ワークステーションの分野においてもAIを前面に押し出していかれるのでしょうか。

大橋氏:そうですね、現在日本HPではAI向けのワークステーションとして「HP Z8 Fury G5 Workstation」を提供しております。シングルソケットで最大56コアの Xeon W9 プロセッサーを採用し、最大2TBのメモリを搭載可能。GPUに関しても最大4基のグラフィックボードを搭載できるなど、AI開発向けのワークステーションと称して問題のない製品に仕上がっています。

また北米では、すでにAI PCに続く”AIワークステーション”というコンセプトも打ち出し始めており、今後は日本での展開も検討しています。

呉氏:インテルとしても「AI Everywhere」というコンセプトを掲げており、サーバー向け、ワークステーション向け、PC向け、エッジ向けなど、AI活用を見据えたラインナップを拡充していく予定です。

大橋氏:今後もインテル様とは密接に連携して、協働体制でAI活用を推進していければと考えています。本日はありがとうございました。