AMDは、Hot Chips 27において、高バンド幅メモリをGPUと同一パッケージに搭載するGPU「Radeon R9 Fury」について発表を行った。ビジネス的にはFuryはすでに発表されているが、学会での発表は初めてであり、同社のJoe Macri CTOが発表するとあって、注目の発表となった。

Furyの最大の特徴は、業界で初めてこれまでのGDDR DRAMに変えてHBM(High Bandwidth Memory)を採用したことである。これはMacri氏がJEDECのHBMを含むDRAMの規格を検討するグループの委員長を務めてきたことと無関係ではないと思われる。

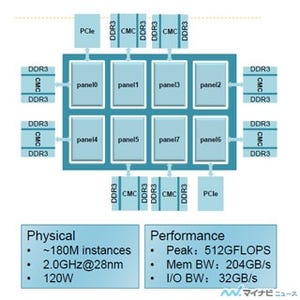

インタポーザと3D積層のHBM搭載がポイント

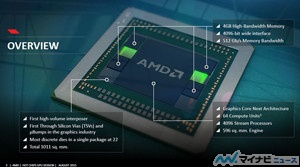

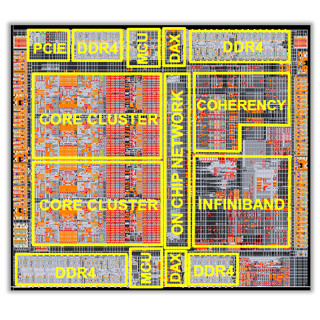

次の図の写真の中央のAMDマークがあるのがFuryチップで、面積は596mm2、64Compute Unit(CU)を集積し、4096個のストリームプロセサを搭載している。そして、左右の黄色く見えるエリアの上下に搭載されている4個のchipがHigh Bandwidth Memoryで、1個あたりの容量は4GB、メモリバンド幅は512Gbit/s(と書かれているが、後の説明では1024Gb/sになっており、こちらが正しい)である。

これらの合計5個のチップを載せている板がインタポーザで、面積は1011mm2となっている。後に詳細な構造が出てくるが、これらのチップはマイクロバンプでインタポーザと接続し、下側のパッケージとインタポーザは従来のバンプで接続する。そして、これらのマイクロバンプやバンプの間の配線がインタポーザに作り込まれている。上側のマイクロバンプと下側のバンプを接続する配線にはインタポーザのシリコン基板を貫通する接続が必要であり、TSV(Through Silicon Via)が使われている。

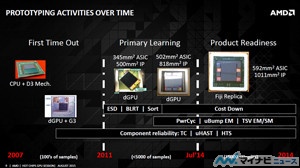

次の図に書かれているように、インタポーザを大量に使用する量産製品に使うのは初めてであり、グラフィックス業界でマイクロバンプやTSVを使うのは初めてである。しかし、XilinxのVirtex 7 FPGAではインタポーザをすでに使っているので新奇な技術というわけではない。

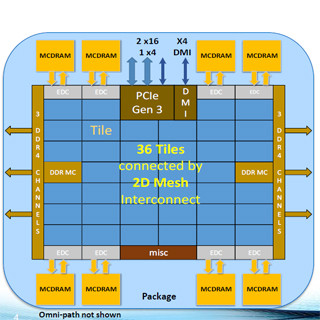

次の図は、FURY GPUの断面で、左の写真の白い電球のように見える部分がバンプで、その下の横線に見える部分がパッケージ基板の中の配線層の断面で、外部ピンにつながるビアが少し見えている。電球のように見えるバンプの上の部分がインタポーザで、白い2本の縦線がTSVの金属部分の断面と思われる。配線はインタポーザの上面付近にあると思われるが、この写真ではほとんど識別できない。

インタポーザの上面に並んでいるのがマイクロバンプで、上側の少し灰色の部分と下側の白い部分で接合している。マイクロバンプの上側がチップで、水平に、多少、白っぽい部分があるが、これはチップ内部の配線の断面が見えている。

右側の図は断面の模式図で、4枚のHBM DRAMダイと下側のロジックダイはTSVとマイクロバンプで接合されており、さらにロジックダイはマイクロバンプでインタポーザに接続されている。そして。GPUチップはHBMの隣に置かれ、インタポーザの配線で接続されている。この模式図では配線はインタポーザの中間にあるように描かれているが、実際は写真のように、表面にへばりついている感じである。

この図から分かるように、DRAMダイからGPUダイまでの配線は非常に短い。このため、少ない遅延時間で高速にデータを伝送できる。また、HBMとGPUの間は1024本のデータ線があり、これはGDDR5 DRAM(32本)やDIMM(64本)に比べて桁違いに多い。プリント板より格段に微細な配線が作れるインタポーザであるから、この多数の配線が可能になっている。

AMDは2007年ころからインタポーザによるマルチチップの接続技術を開発してきたという。2011年以前は、数100個程度を作る研究開発の段階であったが、2011年以降は5000個以下のサンプルを作って部品としての信頼度を評価する段階に移行し、2014年7月からは5000個以上を作る量産評価の段階に入った。

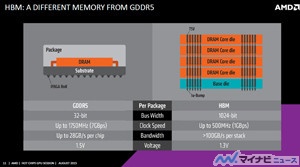

GPUのメモリとして使われてきたGDDR5は、1個のDRAMチップをパッケージに入れたもので、最大1750MHzクロックで、その4倍の7Gb/sでデータを転送する。1チップに32本のデータ線を備え、28GB/sのメモリバンド幅を持っている。一方、HBMは4枚のDRAMチップとロジックチップをTSVで接続して積層し、データ線は1024本存在する。クロックは最大500MHzでデータ転送速度は1Gb/sである。

GDDR5と比べるとデータ転送速度は1/7であるが、信号線は32倍の本数があるので、GDDR5チップの4~5倍のメモリバンド幅を持っている。

HBM 4個とGDDR5 12個を比較すると、前者のバンド幅は512GB/s、後者のバンド幅は336GB/sとなり、HBMの方が、約60%バンド幅が大きい。一方、HBM+インタポーザは配線が短く、寄生容量が小さいので消費電力は60%小さい。

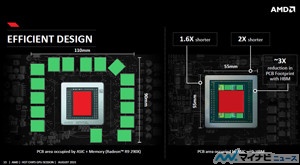

また、次の図の左側は従来のGPUボードの実装で、中央のGPUチップのパッケージを16個のGDDR5 DRAMが取り巻いており、110mm×90mmのボード面積となる。一方、HBMはGPUパッケージに内蔵されるので、パッケージは55mm角と少し大きくなるが、外付けのDRAMは不要であるので、おおよそ1/3のボード面積で済む。

(次回は9月25日に掲載します)