人物姿勢推定の難しさ

筆者は現在チームスポーツの映像を対象とした、「動画像」からの人物姿勢推定という研究を行っているのですが、この人物姿勢推定という問題は、コンピュータビジョン分野の中でのセンシング技術の中でも難しい問題であり、まだ完全には解けきれていません。その理由は、以下の図のように、人の姿勢が画像に映る際には非常に多くのバリエーションがあり、画像が入力の時向けにそれらすべてのバリエーションに対応できるアルゴリズムはまだ存在していない、というのが理由です(※正面向きの人物に対しては、画像一枚からでも姿勢推定ができる技術は実現されています)。

姿勢そのもののバリエーションの多さも去る事ながら、色々な体型、身長、服装に加えて、画像に人が映る大きさ(スケール)や位置によってもさまざまな変化があります。これが例えば「歩いている時の姿勢限定で姿勢を推定したい」というように姿勢の変化を限定すれば、歩いている人の画像パターンをすべて知っておけば姿勢を推定できるようにはなるのですが、Kinectが実現しているような「人の自然な姿勢すべて」を推定する技術は、画像ベースでは実現できていませんでした。それが、Kinectの登場によりカメラからのRGB画像の代わりに3Dデプスを入力とすることで、「3次元の人間の形(Kinectの映る前半分だけですが)」という豊富な情報が手に入れるようになり、リアルタイムでの姿勢推定技術が実現されることとなりました。

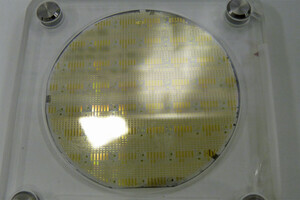

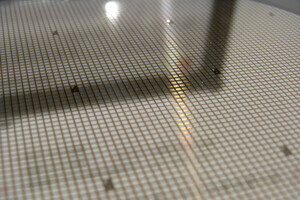

以下の図をご覧いただくと、Kinectが見ている人の3D情報のイメージがわかりやすいと思いますが、このうちカメラ位置側からみた、各画素に距離の値が格納されている「距離画像」を、Kinectは取得することができます。

コンピュータビジョンが専門の方であればご存知のとおり、RGB画像の場合、そもそも人の領域だけを抽出することからして背景状況によってはまず難しかったりするわけですが、Kinectの場合、撮影した空間の3次元形状情報が手にはいるので、人の領域だけを3D範囲で区切ればたやすく抽出することができます。しかも、画像では服装によって変化する服のテクスチャを、「人間の表面の3次元的形状」のみを処理の対象にすることで実質無視する(=形状しか入力としてもちいない)ことが可能となり、人の部位ごとに3次元的な位置と形の違いがわかるので、RGB画像で姿勢推定を行うよりも、距離画像で姿勢推定を行うには有利になるという利点が生まれるのです。また、画像だけではわからない実世界のスケール(大きさ)が、距離画像だと直接取得できるのも利点です。

今回は人物領域の処理についてのみ解説していますが、これらの利点は人以外の周辺環境や物体を処理する際でも同じ利点があると言えます。要するに「3次元空間の形をそのまま処理できる」ことで、実現できる技術が非常に増えるのというのが、距離画像データからの3D形状を入力とした3次元的コンピュータビジョンの利点となるのです。

林 昌希(はやし まさき)

慶應義塾大学大学院 理工学研究科、博士課程。

動画からのチームスポーツ映像解析プロジェクトにおいて、選手の姿勢の推定、およびその姿勢情報を用いた選手の行動認識の研究に取り組み中。人の振る舞いや属性を理解する「ヒューマンセンシング技術」全般が専門。

有料メルマガ「DERiVE メルマガ 別館」では、コンピュータビジョンの初~中級者のエンジニア向けへの情報を発信中。Point Cloud Libraryについてのセミナーも行うなど、コンピュータビジョン技術の普及やコミュニティ拡大に取り組んでいる。

翻訳書に「コンピュータビジョン アルゴリズムと応用 (3章前半担当)」。