Amazon Web Services(AWS)は4月13日(米国時間)、ジェネレーティブ(生成)AIの構築ツール「Amazon Bedrock」を発表した。現在、限定プレビュー版として提供されている。

「Amazon Titan」を含む4つの大規模言語モデルに対応

生成AIシステムを開発するAI21 Labs、Anthropic、Stability AIに加え、Amazonの大規模言語モデル(LLM)をAPI経由でアクセスできる。

同サービスは、ユーザーが基盤モデルを用いた生成AIベースのアプリケーションを構築・拡張でき、Amazonの大規模言語モデル「Amazon Titan」を含む、AI21 Labsの大規模言語モデル「Jurassic-2」(スペイン語、フランス語、ドイツ語、ポルトガル語、イタリア語、オランダ語のテキストを生成)、Anthropicの「Claude」(さまざまな会話やテキスト処理タスクを実行可能)、リアルな高品質の画像、アート、ロゴ、デザインを生成できるStability AIの「Stable Diffusion」にAPI経由でアクセスできる。

モデルのカスタマイズが容易であり、Amazon S3にある20程度のラベル付き例をBedrockに提示するだけで、大量のデータに注釈を付けることなく、特定のタスクのためにモデルを微調整することが可能。

例えば、小売業において発売予定のハンドバッグの新ラインのための広告やキャンペーンのコピーについて、過去のキャンペーンで最も効果のあったキャッチフレーズのラベル付き例と、関連する商品説明を提供すれば、自動的に新しいハンドバッグのソーシャルメディア、ディスプレイ広告、Webコピーの効果的な生成ができるという。

Amazon Titanでは2つのモデルを準備

Titanに関しては、2つのモデルを用意。現在、複数のユーザーとプレビューを行っており、1つは要約、テキスト生成(例えばブログ記事の作成)、分類、Q&A、情報抽出などのタスクに対応する生成型の大規模言語モデル。

もう1つは、テキスト入力(単語、フレーズ、または場合によっては大きなテキスト単位)を、テキストの意味的な意味を含む数値表現(埋め込みとして知られている)に変換する埋め込み型の大規模言語モデルとなる。

生成AIは会話、ストーリー、画像、動画、音楽など、新しいコンテンツやアイデアを生み出すことができるAIの一種。そのほかのAIと同じく、膨大な量のデータで事前に訓練された大きなモデルで、一般的に基盤モデル(Foundation Model)と呼ばれるモデルで駆動する。

昨今、ML(機械学習)の進歩(特にトランスフォーマー型ニューラルネットワーク)により、何十億ものパラメータや変数を含むモデルが登場し、2019年の最大の事前学習済みモデルは3億3000パラメータだったのに対して、現在の最大のモデルは5000億パラメータ以上となっており、数年で1600倍もの規模に拡大しているという。

大規模言語モデルのGPT3.5やBLOOM、Stability AIのStable Diffusionなど、昨今の基盤モデルはブログ記事の作成、画像の生成、数学問題の解決、対話、ドキュメントに基づく質問への回答など、複数の領域にまたがる幅広いタスクを実行できる。

基盤モデルのサイズと汎用的な性質は従来のMLモデルとは異なり、テキストの感情分析、画像の分類、トレンドの予測など、特定のタスクを実行するほか、複雑な概念を学習することができる大量のパラメータを含んでいるため、多くのタスクを実行することが可能。

さらに、インターネット上のさまざまな形態のデータや無数のパターンに事前に触れることで、その知識をさまざまな文脈で応用することを学び、一般的に有能なモデルがゼロからモデルを学習するために必要なデータと計算量の一部を使用し、ドメイン固有の機能を実行するようにカスタマイズすることも可能としている。

カスタマイズされた基盤モデルは銀行、旅行、ヘルスケアなど幅広い消費者産業において、企業の声、スタイル、サービスを体現し、ユニークな顧客体験を生み出すことができるという。

例えば、社内回覧用の日次レポートを、関連するすべての取引から自動生成の必要があるが、過去のレポートを含む独自データのモデルのカスタマイズにより、基盤モデルがレポートの読み方や生成に使用したデータを学習することができるようになるという。

基盤モデルのためのインフラ「Amazon EC2 Trn1n」と「Amazon EC2 Inf2」

AWSでは基盤モデルの実行、構築、カスタマイズなどを行うためのインフラとして「Amazon EC2 Trn1n」、推論を最適化する「Amazon EC2 Inf2」の一般提供開始を発表している。

Trn1インスタンスは他のEC2インスタンスと比較して、トレーニングコストを最大50%削減でき、800Gbpsの第2世代Elastic Fabric Adapter(EFA)ネットワークで接続された複数のサーバにトレーニングを分散させるように最適化されている。

Trn1インスタンスをEC2 UltraClusterに導入することができ、PB(ペタビット)スケールのネットワークで同じAWSアベイラビリティゾーンに配置されたTrainiumチップ(6エクサフロップス以上のコンピュート)3万個まで拡張することが可能。

一方、Inf2インスタンスは、前世代のInferentiaベースのインスタンスと比較して、最大4倍のスループットと最大10倍のレイテンシを提供するほか、大規模な分散推論をサポートするために、アクセラレータ間の超高速接続を備えているという。

これらの機能により、他の同等のAmazon EC2インスタンスと比較して、推論価格のパフォーマンスが最大40%向上するという。

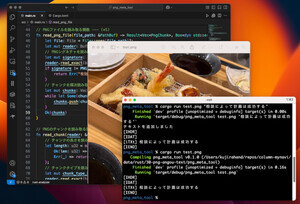

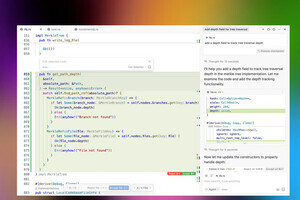

機械学習を利用したコードを提案する「Amazon CodeWhisperer」

さらに、Python、Java、JavaScript、TypeScript、C#に加え、Go、Kotlin、Rust、PHP、SQLなど10言語に対して、機械学習を利用したコードを提案する「Amazon CodeWhisperer」の一般提供を開始。個人ユーザーであれば無料で利用できる。

CodeWhispererは、VS Code、IntelliJ IDEA、AWS Cloud9などのIDEからアクセスでき、AWS Toolkit IDE extensionsを介して、多くのIDEからアクセスできることに加え、AWS Lambdaコンソールでも利用が可能。

CodeWhispererは、公開されている数十億行のコードから学習するだけでなく、Amazonのコードでトレーニングされている。

生成AIツールが提案するコードにセキュリティ上の脆弱性について、CodeWhispererは検出が困難な脆弱性や暗号ライブラリのベストプラクティスを満たしていない脆弱性などを発見し、改善策を提案するためのセキュリティスキャン(自動推論による)を行う。

開発者が責任を持ってコーディングできるように、CodeWhispererは偏見や不公平とみなされる可能性のあるコード提案をフィルタリングし、顧客が参照または使用許可を求めるオープンソースコードに類似したコード提案をフィルタリングしてフラグを立てることができる。