KDDI総合研究所は1月24日、デジタルツイン実現に向けたXR(Extended Reality)領域の取り組みに関する記者説明会を開催した。同社は2030年をデジタルツインの時代と捉え、これを支えるXR技術の研究に注力している。

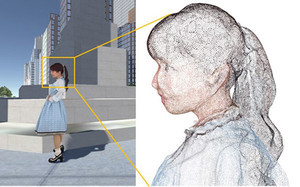

説明会では、没入型でより自然なXR体験を実現するための技術として、三次元空間を点(位置と色情報)の集合で表現する3D点群データの圧縮・リアルタイム伝送における実証実験の成果と、新たに開発した音場のインタラクティブ合成技術が発表された。

【関連記事】

≪「熱い想いと最新技術のコラボで、人の心を動かす体験を」- XR Project @YEBISU β.ver技術担当に聞く≫

≪生産性向上が高い建設ICTツールは「ドローン」 - スカイマティクスが調査≫

3D点群データを高効率に圧縮し、5G回線でリアルタイム伝送

説明会では、KDDI総合研究所が3D点群データの圧縮・リアルタイム伝送の実証実験において、3D点群圧縮技術の国際標準方式であるV-PCC(Video-based point cloud compression、映像ベース方式)と、G-PCC(Geometry-based point cloud compression、座標ベース方式)に対応したリアルタイムコーデックを用いた伝送を行ったと発表した。

V-PCCは動きのある人物などの3D点群データに適しており、G-PCCは点の位置の誤差が少ないため建造物などの3D点群データに適しているとされている。

V-PCC方式の実験では、事前にスタジオで生成した人物の高密度3D点群データを利用。G-PCC方式の実験では、3Dレーザースキャナで取得したKDDI総合研究所本社屋の3D点群データと、事前にドローンを利用して生成した建造物の広域3D点群データを用いた。

2つの実験では、KDDI総合研究所本社(埼玉県ふじみ野市)の専用ソフトウェアをインストールしたノートPCによってリアルタイムエンコードを実施し、5G回線を経由してKDDI research atelier(東京都港区)に伝送した。

その結果、圧縮をしないと膨大なデータ量となる3D点群データ(人物アバターの場合、非圧縮時の伝送データ量は1.2 Gbps)を、データ品質を落とすことなく圧縮し、効率的かつ安定的にモバイル回線で伝送できることを確認できた。

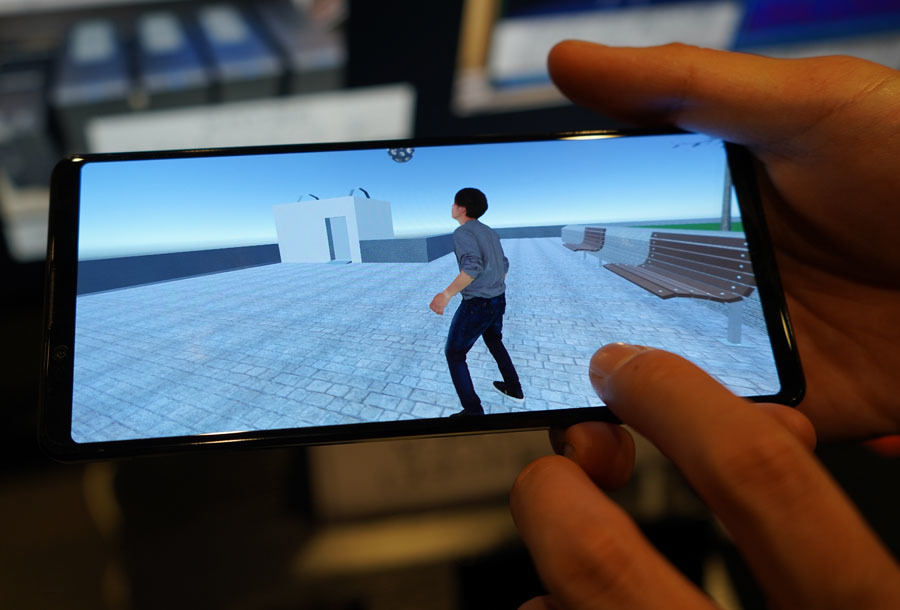

説明会では、V-PCC方式で圧縮した3D点群データのリアルタイム伝送のデモのほか、伝送されたデータをスマートフォン上で操作する展示などが行われた。

3D点群データをモバイル回線で扱うためには、従来技術比で2倍以上の圧縮性能が必要だが、点群データは処理の複雑性が高く、圧縮に関わる処理量が通常の映像の数百倍になるという。

KDDI総合研究所 先端技術研究所 XR部門長の内藤整氏は、「当社が開発したリアルタイムエンコーダーを用いることで、V-PCC方式では非圧縮時の1.0Gbps(2000万点/秒)のデータ量を40分の1に削減(25Mbps相当)できた。また、G-PCC方式では、26Mbps(30万点/秒)のデータ量を21分の1に削減(1.2Mbps相当)できた」の実験の成果を説明した。

なお、データの送信先と受信先でのデータ再生の遅延については、V-PCCのデータ伝送実験は人物の3D点群データの安定性を優先しているため約30秒ほどの遅延が発生したものの、G-PCCのほうは1秒ほどの遅延となった。KDDI総合研究所は今後の実用化に向けて、V-PCC方式の遅延解消を進めていく方針だ。

仮想世界のアバターと音の向き・動きを連動

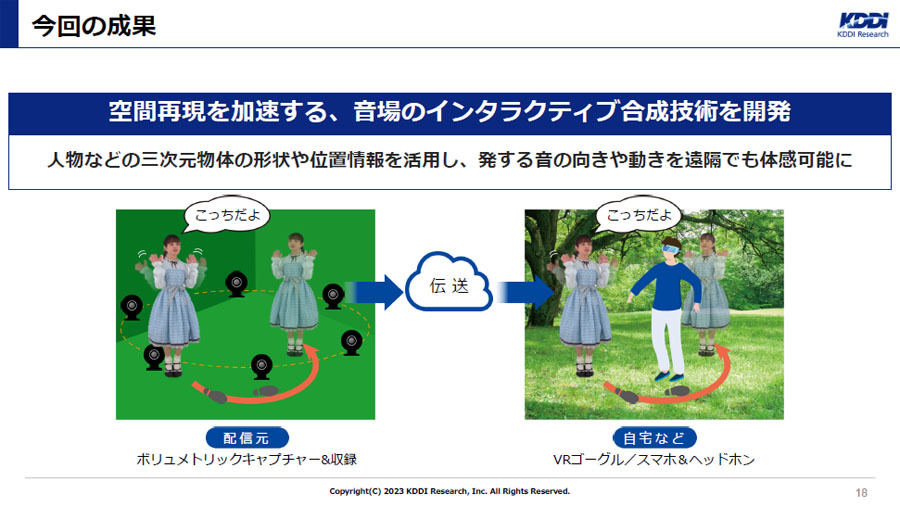

もう1つの発表内容である音場のインタラクティブ合成技術は、現実世界の人が発する音の向きや動きを、仮想空間でも体感可能とするために開発された。

同技術で、3D物体の形状や位置情報を活用し、撮影された人および視聴者の動作に応じて音源の向きや動きを伴った音場をリアルタイムで合成することができる。

例えば、被写体を取り囲むように設置したカメラで撮影した映像データを基に、3D点群のコンテンツを制作するボリュメトリックキャプチャーで作成した3Dアバターに対して、被写体を囲むように10本程度のマイクを離散配置して得られた音源を基に、被写体の向きや動きに合った音場を合成することができる。

現在、広く普及している3Dオーディオは、ユーザーの位置や向きの変化には追随できないため、演者の位置のみを考慮した音場の再現にとどまっている。また、演者へのマイク装着が必要なため、映像制作にも影響がある。

「今回開発した技術では演者がマイクを装着する必要はなく、音源そのものが立体的に聞こえるほか、近づいたり回り込んだりしたときの音色の変化も体感できる。そのため、仮想世界におけるアバターや人の動きと、発せられる音の向きや距離の変化などの動きを連動させて、より自然なオンラインコミュニケーションを楽しめる」と内藤氏は語った。

今後はV-PCC・G-PCCによる映像圧縮と、音場のインタラクティブ合成技術を組み合わせた検証や評価を進めるという。

2023年度中には、メタバースプラットフォーム上でのアーティストのライブ中継の実証実験や、スマートドローンと共同での建設現場のDX(デジタルトランスフォーメーション)に向けたフィールド試験を実施する予定だ。