NVIDAIは3月22日(米国時間)、プレイベートカンファレンス「GPU Technology Conference 2022(GTC 2022)」を開催。基調講演にて新アーキクチャ「Hopper」ベースの次世代アクセラレーテッドコンピューティングプラットフォームとなるGPU「H100」を発表した。

HopperアーキテクチャはAmpereアーキテクチャを継承したもので、そのネーミングは計算機科学者で、プログラミング言語COBOLの開発や、バグの逸話などで知られるGrace Hopper氏に由来したものとなる。

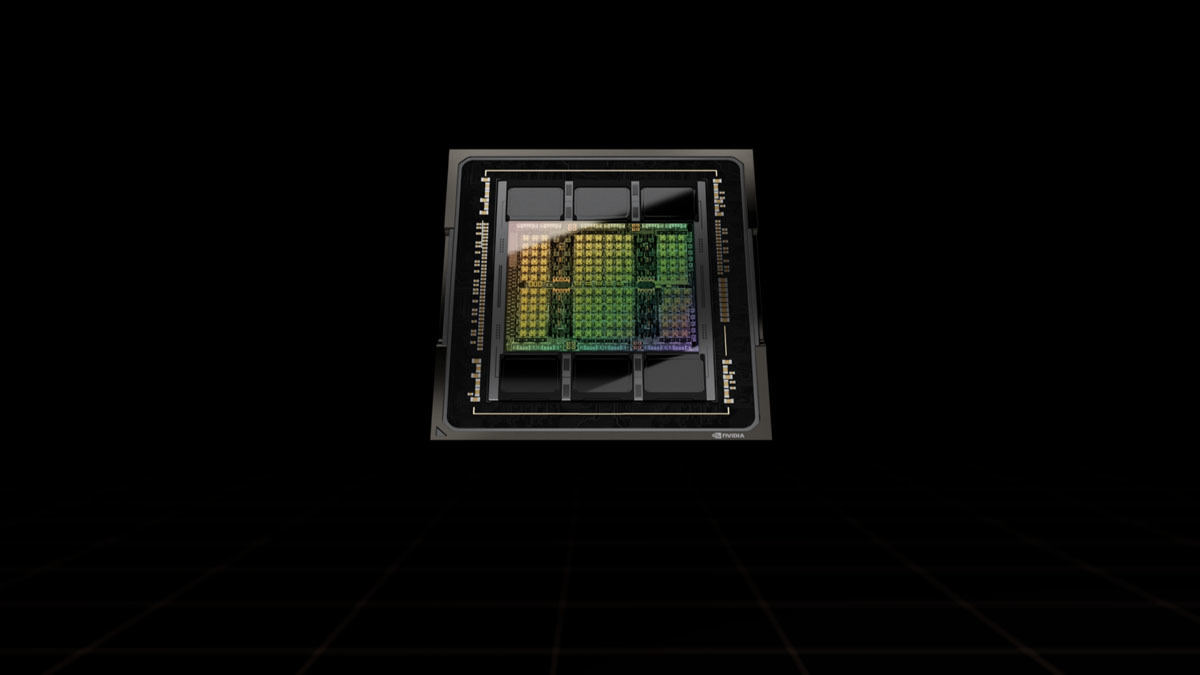

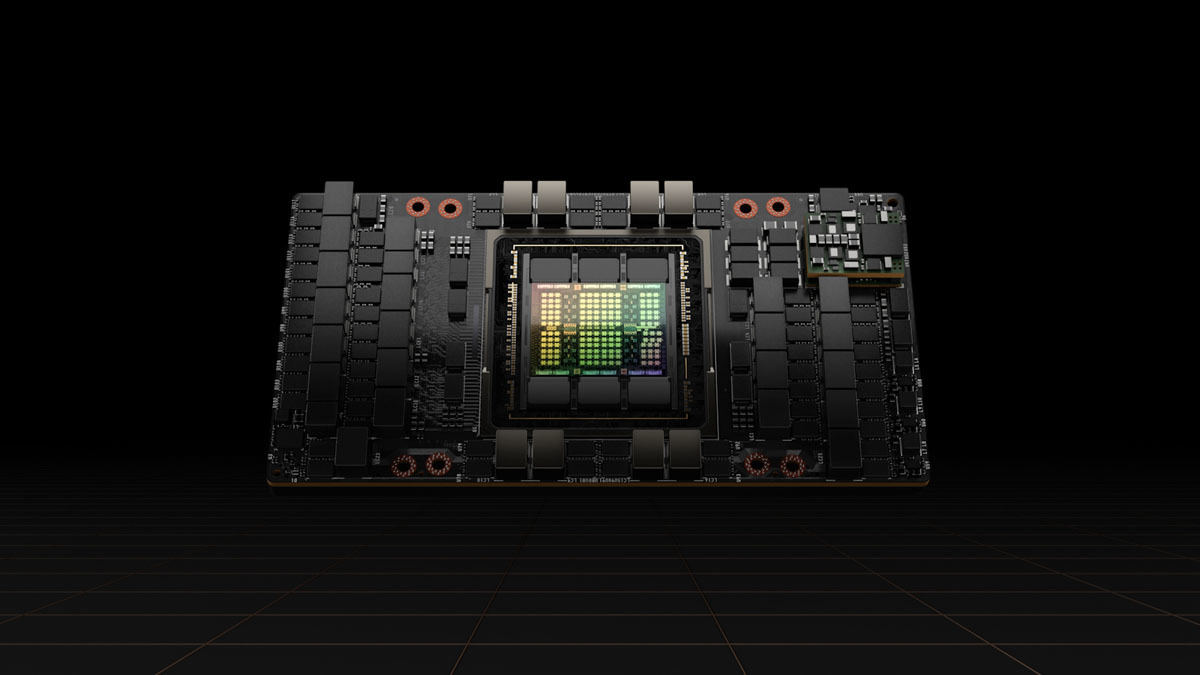

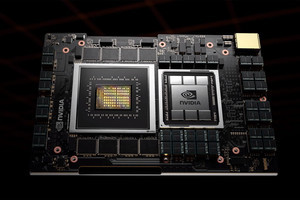

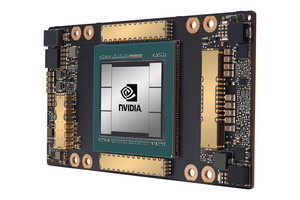

TSMCの4nmプロセス(4N)を採用し、約800億トランジスタを搭載。HBM3のサポートによる3TB/sのメモリ帯域幅と、PCI Express(PCIe)Gen5のサポートが提供されているほか、前世代比で6倍高速化された新しいTransformer Engine(従来のTensorコア)、前世代比で最大7倍に拡張された単一のGPUを7つの小さな独立したインスタンスに分割し、多様なジョブを処理できる第2世代Secure Multi-Instance GPU(MIG)テクノロジ、処理中にAIモデルと顧客データを保護するコンフィデンシャルコンピューティング機能、ルート最適化やゲノミクスを含む幅広いアルゴリズムで使用される動的計画法を、CPU比で最大40倍、前世代GPU比で最大7倍高速化する新たなDPX命令への対応などが盛り込まれている。

また、帯域幅が900GB/sに引き上げられた第4世代NVIDIA NVLinkの採用により、最大256基のH100を接続して活用することも可能となっている。

新たにFP8をサポート

Hopperアーキテクチャでは、FP8(8ビット浮動小数点演算)が新たにサポートされた。その演算性能は4000TFlopsで、前世代となるA100のFP16での演算と比べて6倍となる。また、FP16の場合では前世代比3倍の2000TFlops、TF32では同3倍の1000TFlops、FP64では同3倍の60TFlopsとしている。

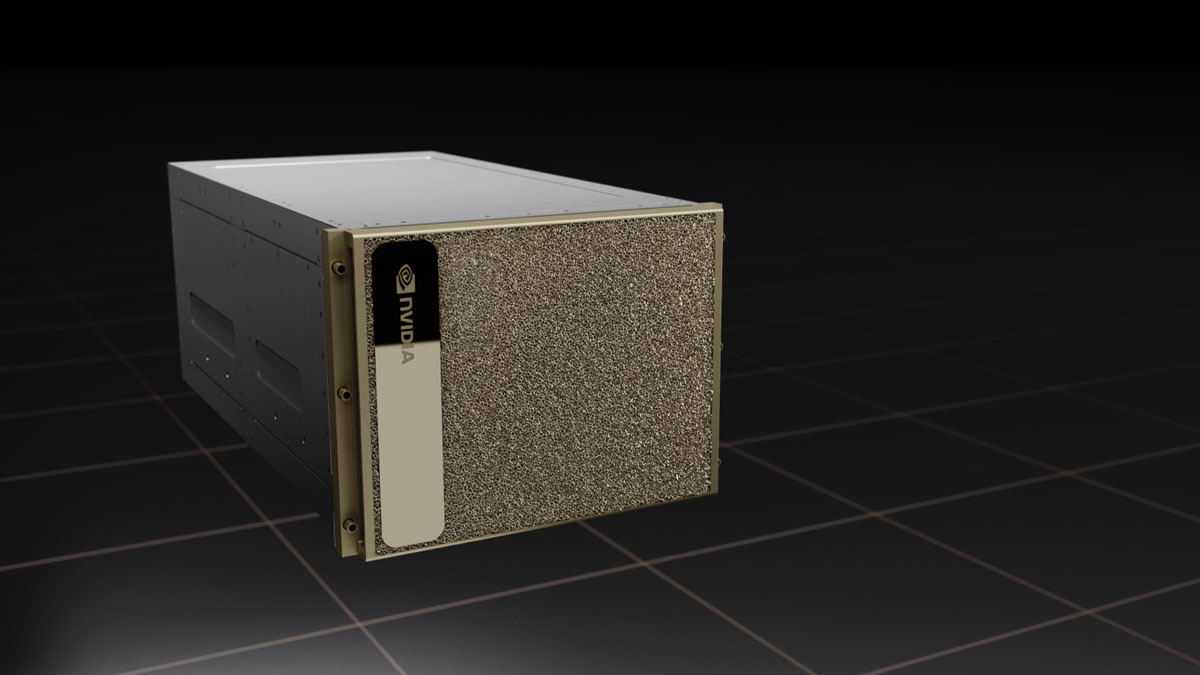

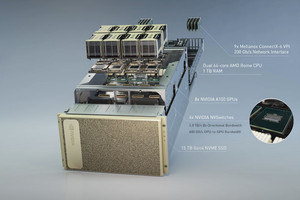

また、H100を8基搭載した第4世代DGXシステム「DGX H100」も併せて披露された。こちらはFP8で32PFlopsのAIパフォーマンスを提供するとしているほか、NVLink Switchにより構成させる次世代のNVIDIA DGX SuperPODでは32台のDGX H100ノードがネットワーク接続され、1EFlopsのAIパフォーマンス(FP8)を提供することになるとのことで、2022年後半からは、このDGX SuperPODを活用し、576台のDGX H100システムで構成されるスーパーコンピュータ「NVIDIA Eos」(FP8で18EFlops、FP64で275PFlops)の運用も開始する予定だとしている。

なお、H100 GPUは2022年第3四半期からの提供開始を予定しているほか、 Atos、BOXX Technologies、Cisco、Dell Technologies、富士通、GIGABYTE、H3C、Hewlett Packard Enteprise、Inspur、Lenovo、Nettrix、Supermicroから、H100アクセラレータを搭載したサーバの提供も予定されているという。