東京工業大学(東工大)は2月24日、エッジ端末でのAI応用の発展に向けて今後さらに重要となる、ディープラーニング技術の「深層ニューラルネットワーク」(DNN)モデルの高効率な推論を実現する「隠れニューラルネットワーク」(HNN)理論を利用した低消費電力型の新規アクセラレータLSIの試作チップを開発したことを発表した。

同成果は、東工大 科学技術創成研究院の廣瀬一俊大学院生、同・劉載勲准教授、同・本村真人教授らの研究チームによるもの。詳細は、集積回路に関する国際会議「ISSCC 2022(国際固体素子回路会議)」にて発表された。

AI技術の一種であるディープラーニングで用いられる情報処理モデルであるDNNは、「重み」といった計算パラメータを外部メモリから読み込む際に多大な電力を消費してしまうため、精度を求めてネットワークが複雑化・巨大化していくに伴って計算量が増化、結果として消費電力が増加するという課題がある。

そこで研究チームが今回注目したのが、「DNN全体の一部分だけを用いても推論精度が劣化しない」ような部分ネットワークを発見することで軽量なDNNモデルを実現できるHNN理論だという。

具体的には、HNN理論では重みを乱数の初期値のまま固定し、代わりにネットワークの各結合の重要度を表す「スコア」を学習。選択対象のスコアが上位のk%(kは任意の数)の結合に値1を対応させ、それ以外には値0を対応させた「スーパーマスク」を生成し、乱数初期値の重みとスーパーマスクの論理積をとることで、上位k%の部分ネットワークを発掘するというものだという。

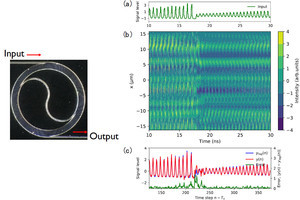

今回の研究では、HNN理論の特徴を活かせるハードウェア・アーキテクチャも考案され、「ヒデナイト(Hiddenite)」アーキテクチャと命名された。そして、そのヒデナイトを実際にハードウェア化したLSIチップをTSMCの40nmプロセスで試作(ダイサイズ3mm×3mm、4096個のニューロン演算器を並列動作)し、具体的な性能を実測評価したところ、LSI上でモデル情報を生成することで、記憶したり転送したりする情報量を削減できることが確認されたとする。

研究チームでは、新たに提案されたこの「オンチップモデル構築」技術が、今回の研究の根幹となる技術だとしている。従来型DNNの最少モデルである二値化ネットワークは、重みの正と負の割合が等しいため圧縮はできず、そのままチップに重みを転送する分の電力を消費してしまうが、HNN理論に基づく今回の場合は、二値の重みとスーパーマスクを必要とするため、一見するとモデルサイズは二値化ネットワークの2倍となるが、オンチップモデル構築技術により、転送量を二値化ネットワークのおよそ半分に削減することが可能であり、かつモデル構築による消費電力はモデル情報の転送の消費電力に比べて小さいため、全体として電力を削減できるという。

また、重みとスーパーマスクがそれぞれ1ビットであるため乗算器を必要とせず、演算要素がコンパクトになり、エッジ機器の限られたハードウェア量の場合でも、ニューロン演算器を多数配置して並列演算を行うことが可能だとするほか、その並列演算能力を余すことなく活かすため、畳み込みニューラルネットワークの4次元(入力チャネル数・特徴マップの高さ・特徴マップの幅・出力チャネル数)方向にバランスよく割り当てる工夫も施されているとしている。

そのため、試作チップは、DNNモデルの転送量を二値化ネットワークの半分に抑えながらも、最大34.8TOPS/Wの演算効率を消費電力40mW程度で達成したとするほか、推論精度も、従来と同等の値を達成することができたとしている。

なお、今回提案されたヒデナイト・アーキテクチャ自体は、より大規模なHNNのモデルに対しても汎用的に推論が可能であると研究チームでは説明しているほか、今後については、より一層の推論精度向上のための学習アルゴリズムやその動作原理の研究を推し進めるとともに、さらにそれを活かした高精度かつ高効率なDNNアクセラレータの実現を目指すとしている。