Googleが量子コンピュータを導入して機械学習などの研究を開始

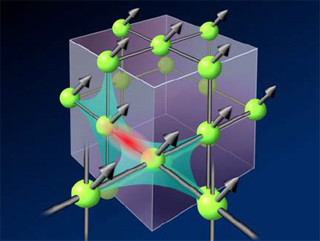

通常のコンピュータの1bitは0と1の2つの値をとるが、量子コンピュータの1qubitは0と1の両方の値を同時に取ることができる。このため、通常のコンピュータの演算はNビットの1つのデータ値についての計算しかできないが、量子コンピュータの場合はNビットが取り得るすべての2N通りの入力に対する計算を一度に行ってしまうことができる。荒っぽい言い方であるが、Nビットの量子コンピュータは2N並列で計算をやってしまう。Nが小さい場合は集積度の高いシリコンのLSIに負けてしまうが、Nが500とか1000になると圧倒的に高性能になると考えられている。これが、量子コンピュータが期待される理由である。

しかし、量子コンピュータの本流である量子ビット(Qubit)を量子ゲートで操作するタイプの量子コンピュータは10qubitかそこらの規模のものが研究的に作られているという程度で、実用にはほど遠い状態である。

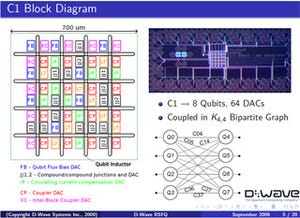

これに対して、今回のQuantum AI Labが導入するD-Wave Twoマシンは512qubitのマシンである。ただし、量子ゲートで演算を行うタイプの量子コンピュータではなく、Quantum Annealingという別の原理で計算を行う。

D-WAVEの量子コンピュータの原理を開発した日本人とは?

このQuantum Annealingは、1998年に東京工業大学の西森秀稔教授と当時博士課程に在学中の門脇正史氏が考案したものである。ということで、東工大を訪ね、西森理学部長からお話を伺った。

西森教授は、統計力学が専門で、当時はニューラルネットに熱ゆらぎを与えた場合の影響を研究していたという。これを熱ゆらぎではなく、量子ゆらぎを与えたらどうなるかと考えて、研究を始めたのだそうである。その結果、両者の影響は良く似たところがあり、最適化問題を解くSimulated Annealingと同様なことが量子系でも実現でき、量子系によるQuantum Annealing(量子アニーリング)の方がずっと高速に最適化された状態に落ち着くという結論が得られたという。この研究結果は1998年に発表され、門脇氏は、このテーマで博士号を取得している。しかし、この研究はあくまで理論的な興味で行ったもので、どのように実現するかについては、西森先生は興味が無かったという。

なお、西森先生のQuantum Annealingの論文発表の3年後の2001年にMITから、よく似た方法が発表され、米国では、こちらの論文のAdiabatic Quantum Computation(AQC:断熱量子計算)、あるいはAdiabatic Quantum Optimization(AQO:断熱量子最適化)という名称のほうが良く使われているという。

D-Waveの発表論文には両方の論文が引用文献として挙げられているが、西森先生の論文の方が時期が早く、D-Waveも門脇、西森がこの原理を初めて提案したことを認めている。

アニールは一旦高温にしてから徐々に冷却してエネルギーが最低の安定した状態にもっていく方法であり、これを真似て、エネルギー最低の状態を最適化問題の解になるようにして、系の状態が変わり易い高温の状態から徐々に温度を下げるアニールプロセスをシミュレートし、最後のエネルギー最小の状態として最適解を求めるのがSimulated Annealingである。

Quantum Annealingも、当初は量子ゆらぎの多い状態から、徐々にゆらぎを減らしてエネルギー最低の状態に持っていくと、最適化問題の解になるという計算手法である。このような計算方法であるので、Quantum Annealingで解けるのは離散的最適化問題だけであり、量子ゲートを使うコンピュータが扱えるすべての問題が扱えるわけではないが、離散的最適化問題は適用範囲が広いので、実用的には十分な意味がある。

Quantum Annealing自体は、学会でも量子コンピューティングであると認められているのであるが、D-Waveのマシンが本当に量子コンピューティングを行っているのかどうかについては、異論があり、学会でも議論があるという。

量子コンピュータが2Nの並列計算ができるのはN個のqubitが量子的にコヒーレントな状態にあるからであるが、計算を行う期間、多数のqubitをコヒーレントな状態に保つことが出来ないため、量子ゲートを使う量子コンピュータのqubit数は10個程度に留まっている。

なぜ、D-Waveがこれほど多くのqubit数のマシンを動かせるのか分からないが、西森先生は、量子ゲートによる量子計算は系のエネルギーが高い状態で演算を行うのに対して、Quantum Annealingは、系のエネルギーが最低となるようにする計算法であり、本質的に安定性が高い計算法であるという。

しかし、多くの量子コンピューティングの研究者にとっては、D-Waveが128やそれ以上のqubitでコヒーレンシを維持してQuantum Annealingを実現できるというのは信じがたく、結局はSimulated Annealingなどの他のメカニズムで動いているのではないかと疑う学者が問題点を指摘しているという状況になっている。そして、このように指摘に対して、D-Waveが反論するというプロセスが続いているという。

西森先生は、当初はD-Waveから論文なども出ておらず、量子コンピュータという主張は、9割は眉唾と思っていたが、2010年ころから論文も多く発表され、批判に対する反論も妥当で、今は、五分五分より多少信じる方に傾いているとのことである。しかし、究極的な証明は、qubit数が多いマシンで、通常のコンピュータを圧倒的に越える性能の実現を待つ必要があるという。

単にqubit数の多いチップを作るだけであれば微細化を行ったり、チップを大きくしたりすれば良いのであるが、本質的な問題はこのコヒーレンスの維持で、なぜ、本流の量子コンピューティングではうまくいかず、D-Waveは多くのqubitのコヒーレンスを維持できるのか? さらにqubit数を増やしてもコヒーレンスを維持できるのかである。

また、実用にあたっての問題が2つある。1つは歩留まりで、すべてのqubitは高い精度で特性が一致していなければならない。D-Waveはqubitの特性のずれを補正するメカニズムを組み込んでいるが、特性のずれが大きかったり、補正系に製造欠陥があったりすれば完動品にはならない。

もう1つの問題は熱エネルギーである。断熱量子計算とも呼ばれるように、Quantum Annealingでは外からの熱エネルギーの流入は雑音になる。このため、D-Waveはチップを21mK(ケルビン:絶対温度で0.021度)に冷却している。しかし、qubit数が数10個以上になると状態間のエネルギー差よりも21mKの熱エネルギーのほうが大きくなってしまうという。

Qubit数が増加すると状態間のエネルギー差は減少する傾向にあり、より低温に冷却する必要がある。発熱が無ければ、さらに1/1000のマイクロケルビンの温度を達成することも可能であるが、チップが電力を消費し、発熱がある場合は、温度を下げるのは容易ではない。また、D-Waveのマシンでは入出力や電源の供給に数100本のケーブルがあり、これらの電線を通しての熱の流入もある。このため、増加するqubit数によるエネルギー差の減少に見合う温度の低下は容易ではない。

温度が高いと最低エネルギーではない状態で落ち着いてしまう確率が高くなる。それでも、最低エネルギー状態になる確率がある程度残っていれば、繰り返しQuantum Annealingを行えば、そのうち、最適解に落ち着くケースが出てくるので、これは致命的な問題ではない。

量子コンピュータが日常に役立つ日がくればノーベル賞の受賞の可能性も

西森先生らの論文ではSimulated Annealingより速く結果が得られるという結論であったが、西森先生によると、Quantum Annealingによる計算がどれだけ時間がかかり、それが通常のコンピュータによる計算と比べて短い時間で最適解を見つけ出せるかどうかは、完全には分かっていないとのことである。また、D-Waveの論文でも、Quantum Annealに掛かる時間を求めるのは非常に難しいことが指摘されている。

このように、悲観的に見ると、本当にQuantum Annealingで高速に最適化問題が解けるかどうか証明されていない、本当にD-Waveのアプローチでコヒーレンスが維持できてQuantum Annealingが実現できているのか、温度の問題や歩留まりの問題はどうなるのか、問題が山積という感じである。

しかし、楽観的にみれば、128qubitのD-Waveの量子コンピュータが通常のコンピュータより高い性能を示している問題も多くあり、qubitが増えると、従来のコンピュータでは解けなかった大規模な最適化問題が解けるようになる可能性が大きい。

そうすると、配送の最適化や製品開発の過程で必要となる様々な大規模な最適化が可能となり、配送時間や必要なエネルギーが減り、製品の性能があがり、コストが減るという効果が期待される。また、Googleが目指すマシンラーニングが進歩すれば、だんだん賢くなるサーチエンジンなどの実現が可能になる。

Quantum Annealingを使うD-Waveのマシンは、量子ゲートを使う実験室の量子コンピュータとは比べ物にならないほどの高い技術的な完成度を持つマシンである。このマシンを使ってNASAやGoogleが世の中を変える多くの成果を出し、Quantum Annealingを使う量子コンピュータが我々の生活に欠かせない要素になっていくという可能性も十分に有る。非常に多くのifを含んでいるが、もし、そうなれば、西森先生、門脇氏にノーベル賞というのもありえないことではない。