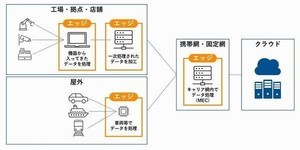

データ活用・統合の新潮流であるデータ仮想化について、背景や需要、ユースケースを紹介する本連載。前回は、IT業界のトレンドの1つであるエッジコンピューティングとデータ仮想化について説明しました。今回は、機械学習(ML)とデータ仮想化について見ていきます。

機械学習利用における課題を解決

著名なコンピューター科学者であり、機械学習の先駆者でもあるTom M. Mitchell(トム・M・ミッチェル)氏は、機械学習を「経験により、コンピュータープログラムの自動的な改善を可能にするコンピューターアルゴリズムに関する研究」と定義しています。言い換えれば、機械学習とは、膨大な量のデータを与えてコンピューターアルゴリズムを訓練し、与えたデータに基づいてアルゴリズムにデータ駆動型の推奨をさせることを可能にする、コンピューターサイエンスの一分野です。

このアルゴリズムは、エラーに関連する情報を特定し、将来的な意思決定の改善に利用します。今日、機械学習は、製造業、小売業、ヘルスケア、旅行、金融サービス、エネルギーなど、あらゆる主要産業で利用されています。機械学習の利用例には、製造業の予知保全や状態監視、旅行業の動的な価格決定、小売業のアップセルおよびクロスチャネルマーケティングなどが挙げられます。

Forbesによると、実に「企業経営者の57%が、AIおよびMLの発展による最も重要なメリットは、顧客体験とサポートの向上にあると考えている」といいます。しかし、機械学習を可能にするには、異なるソースから大量のデータを迅速に統合して処理できる高度なインフラが必要であり、複数のデータプラットフォームやツール、処理エンジンが関わるケースが多くあります。とはいえ、このようなインフラの構築や維持は、複雑でコストがかかるものです。

そこで、データ仮想化を活用すれば、機械学習プロジェクトのデータ統合プロセスを簡素化しながら、コストを削減し、機械学習の取り組みを加速させることができます。

機械学習向けデータレイクを有効活用するには

機械学習を利用するため、多くの組織がデータレイクを活用しています。構造化および非構造化されたソースを含む複数のソースから大量のデータを収集し、データを元のままの形式で保存できるからです。しかし、異なる形式のデータを保存することが、必ずしもデータの活用を促進するとは限りません。データの形式が異なっていると、機械学習に用いる前に、まずデータを統合しなければなりません。

今日の企業では、データインフラの分散化が進んでいるため、データの統合はより複雑になっています。データサイエンティストは、最大で80%もの時間をデータ統合の作業に費やしており、新しいアプローチが必要になっています。

さらに、元のシステムからデータを複製するのに時間とコストがかかり、関連するデータのごく一部のサブセットしかデータレイクに保存されないことにもなりかねません。企業は、複数の異なるクラウドプロバイダーやオンプレミスシステムに分散した、複数のデータリポジトリを保有している場合があります。

機械学習用にデータを適応させる負担はデータサイエンティストに課せられてしまいますが、彼らは必要な処理機能を利用することはできても、統合に必要なスキルを持っていないことが多いのです。ここ数年、データサイエンティストが簡単な統合作業を実行できるように設計された、データ準備のためのツールが登場していますが、多くのタスクではより高度なスキルが求められます。また、機械学習を利用にあたり、組織のITチームがデータレイクに新しいデータセットを作成するために呼ばれることがありますが、これは全体的な取り組みを遅らせる可能性があります。

データレイクやその他の多様なソースのメリットを最大限に引き出して機械学習を利用するには、新しいテクノロジーが必要です。

データサイエンティストを助けるデータ仮想化

データ仮想化の利用により、複数のデータソースから新しい中央リポジトリにデータを移動せず、データを元の場所に残したまま、リアルタイムでデータの統合ビューを作成することができます。データソースは、オンプレミスでもクラウドでも、あるいは構造化されていても、そうでなくてもかまいません。データ仮想化は、データレイクを含む膨大な数のデータサイロに対応します。

データサイエンティストは、データ仮想化を通じ、自らのニーズに最も適した形式でより多くのデータにアクセスできるようになります。また、データアクセス用のSQLスクリプトやAPIを自動生成するため、データサイエンティストは複雑な新しいデータ統合プロトコルや手順を学ぶ必要なく、データを統合することができます。

データ仮想化は、データの場所や元の形式に関係なく、あらゆるデータに対して単一のアクセスポイントを提供します。物理データ上に複数の機能を組み合わせて適用することで、データ仮想化は、ソースデータのコピーを別に作成する必要なく、同一の物理データに対して異なる論理ビューを提供します。データ仮想化は、さまざまなユーザーやアプリケーションのデータニーズを満たす迅速で安価な方法を提供し、機械学習用のデータを統合する際にデータサイエンティストが直面する、特定の課題の対処に役立ちます。

最善のデータ仮想化ツールは、タグやカラムの説明など、各データセットに関する広範なメタデータをはじめ、各データセットの利用者や利用時間、利用方法といった情報も含めて、利用可能なすべてのデータセットに関する検索可能なカタログも提供しています。

データサイエンティストにもたらすメリット

データ仮想化により、データ統合プロセスは明快かつシンプルになります。データの元の保存場所が、リレーショナルデータベース、Hadoopクラスター、SaaSアプリケーション、NoSQLシステムのどれであっても、データ仮想化は、一貫性のあるデータ表現とクエリモデルに従ってデータを公開し、データサイエンティストは、単一のリレーショナルデータベースに格納されているようにデータを表示することができます。

また、データ仮想化によって、ITデータアーキテクトとデータサイエンティストの責任を、明確かつコスト効率よく分離することが可能です。データ仮想化を活用すると、ITデータアーキテクトは再利用可能な論理データセットを作成でき、さまざまな目的に役立つ形で情報を公開できるようになります。また、従来の方法に比べて、論理データセットを作成して維持するのにかかる労力は低減されます。データサイエンティストは、さまざまな機械学習プロセスの個々のニーズに合わせて、論理データセットを適応させることができます。

機械学習はまだ黎明期の段階にあるかもしれませんが、より深い知見を通じて業務効率を高める方法として、企業がアナリティクスに注目していることから、機械学習の市場は今後4年間で44%成長すると予測されています。機械学習の採用が増え続け、データレイクの普及が進むにつれ、データ仮想化は、データサイエンティストの生産性を最適化するために必要性が高まっていくでしょう。

データ仮想化により、データサイエンティストはより多くのデータにアクセスでき、カタログベースのデータディスカバリーを活用できるようになります。さらに、データ統合がシンプルになることで、データサイエンティストはデータ管理業務の負担を負うことなく、自らのコアスキルに集中できるようになります。データ仮想化によりデータアクセスが簡素化され、機械学習もまたシンプルになります。その結果、ビジネス上の知見をコスト効率よくリアルタイムで収集できるというメリットを、組織全体で十分に享受できるようになるでしょう。

これまで、データ仮想化について、その背景や昨今のトレンド/キーワードとの関連を見てきました。ますますデータの量や種類が増え、その価値も高まることでしょう。データ活用がデジタルトランスフォーメーションの本質とも言われています。そのためのデータ基盤としてのデータ仮想化に引き続き注目しみてください。