新型コロナウイルス感染症のパンデミックの発生により、企業はDX(デジタルトランスフォーメーション))への迅速な対応が迫られています。同時に、消費者向けのクラウドサービスや5G、AIなどの新たな需要が高まるにつれ、データ通信量も飛躍的に増加しています。そのため、クラウドサービスやデータ通信のインフラストラクチャをサポートするデータセンターの強化と適切な管理・運用がこれまで以上に重要になっています。

また、AIや深層学習の進化には、膨大なデータの高速な計算と処理能力が必要であり、データセンターではこれらの要求に対応できる、より優れたサーバ環境が求められています。その一方で、より大規模で、高性能なサーバの動作や冷却に必要なエネルギー消費量の増加、さらに定期的に発生するシステム換装時の電子廃棄物の増加が、問題視されています。

これに伴いデータセンターでは、サーバやストレージの物理的な設置面積の縮小、効率的な冷却技術の採用などによる運用コストや電子廃棄物を削減する設計などが注目されています。

データセンターを地球環境にやさしいグリーン・データセンターにするには、次のような方法を考慮する責任があります。

ハードウェアのスペース効率向上で省エネ

データセンターの電力効率を上げるうえで、使われないスペースは無駄であり、環境面においても影響を与えます。そのため、「サーバ」「ストレージ」「ネットワーク機器」といったハードウェアのスペースの効率も最適化することが大切です。

ハードウェアは処理性能、価格性能比に加え、ラック当たりのノード搭載密度やストレージの搭載容量が、スペース効率を高めるために重要です。より高性能なサーバの採用と集約、仮想化技術などの活用により、ノード数自体を減らすことが有効です。

その具体策としては、シンプルなラックマウントサーバを必要に応じて迅速に⼊れ替えていく⽅法もあれば、マルチノードサーバやブレード型サーバなどを採用することで、物理的な設計の⼯夫によりハードウェアの構築に必要な各種ケーブルの本数の削減など、構成部品の点数とコストをトータルに削減して効果を上げる方法もあります。

データセンターは管理するノード数も膨大になるため、運用コストを抑える工夫も必要であり、ソフトウェアによる自動化や、アプリケーション、用途に合わせて日々柔軟にハードウェア構成を再構築できるような管理ソフトウェアも必要です。

また、設置面の耐荷重要件や、1ラックあたりに供給できる電力要件など、欧米と比較すると日本特有の制限も考慮する必要があるため、クラウド、データセンター向けのハードウェアには、用途に合わせてより柔軟性の高い設計と構成が可能なハードウェアベンダーが支持を得ています。

データセンターで利用される2種類の冷却技術

ハードウェアを冷却するエネルギーを削減することもデータセンターの消費電力を削減する上で効果的です。サーバは内部のCPU、メモリ、ストレージ、GPU、冷却ファンなどあらゆる構成部品の作動時に大量の熱を発生させます。その熱を十分に冷却できない場合は、ハードウェアがオーバーヒートを抑える作用によるパフォーマンスの低下、システムの誤作動、最悪の場合、システム障害を引き起こします。

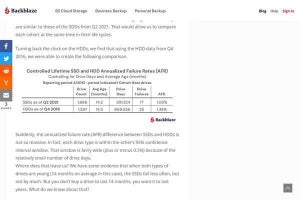

今の標準的なサーバルームの冷却温度(サーバの吸気温度)は21度から24度という調査結果があり、仮に15kWのラックで0.56度 (華氏1度) 増加するごとに、4%の電力を節約できると試算できます。より高い吸気温度で動作、運用できれば、年間数百万円から数千万円、数億単位のエネルギーコストを削減できます。

世界のグリーン・データセンターに認定されている先進的なデータセンターの冷却温度は29度超えていますがり、今後も冷却温度の上昇は続くとされており、それに伴い、ハードウェア自体の冷却設計も重要度が増しています。Supermicroの導入事例では電力使用効率を示すPUE 1.06を空冷で実現しています。

一般的にハードウェアを冷却する方法には、外気による空気冷却(空冷)があり、HPC/スーパーコンピューターの冷却においては従来から採用されている水冷を含む液冷方式があり、データセンターにおいても施設の規模や設置環境に応じて液冷も検討されつつあります。以下、各冷却方式の概要です。

外気冷却(空冷)方式

最も一般的な外気冷却方式でエネルギー効率を高めるには、サーバを従来の一般的なデータセンターでの動作温度よりも高い温度で動作保証するために、サーバやストレージから発生した熱を効果的に冷却できるように、筐体内部の各コンポーネントの配置やエアフローの設計などの最適化を追求する必要があります。

ブレードサーバでは、複数台のノードを共有のエンクロージャ内に集約することで、冷却ファン、ネットワークスイッチ、電源などを共有化して、エネルギーの利用効率性を高めることができます。一見同じようなサーバ製品でも、このような冷却最適化のノウハウが、ハードウェアベンダー各社の特徴と差別化になっています。

サーバラック内の搭載方法や、配置場所を調整することも、冷却効率の改善につながります。ラックを並べて配置し物理的なスペースを「コールド通路」と「ホット通路」により最適化することで、冷却システムをより効率的に機能させることができ、最も必要な場所に向けて冷気を送りこむことができます。

そして、空調設備と気流を最適化することで、データセンターの冷却に必要なエネルギーコストも削減できます。 また、ラック・スケール・デザインなどのサーバを動的かつ柔軟に分割・再構成を行い、要求に応じた規模のリソースを最適に割り当てることが可能になるアーキテクチャを採用したソフトウェアを活用することで、冷却にかかるエネルギーや関連コストもさらに節減することができます。

液体冷却方式

近年データセンターでも、常に最大の計算能力でより安定したコンピューティングを長時間継続して実現するため、HPC/スーパーコンピューターの分野で用いられてきた液体冷却の高効率性が注目を集めています。空冷却技術だけでCPUやGPUを賄うことが難しくなってきたといわれている中、Supermicroの試算では、液体冷却は最大で1,000倍の効率で熱を下げることができ、用途や規模によっては、液体冷却へ移行することでエネルギーコストを大幅に削減できる可能性があります。また、冷却時に必要なエネルギーを削減することは、二酸化炭素排出量を減らすことにつながります。

Supermicroが提供する液体冷却の最近の導入事例として、国内では、大阪大学サイバーメディアセンター「SQUID」スーパーコンピュータで採用されています。海外では、米ローレンス・リバモア国立研究所にて新型コロナウイルスに関する研究に使われているサーバで、液体冷却が採用されています。これらの事例では、液体冷却装置をサーバに搭載し、工場においてラック単位でのインテグレーションと検証を事前に完了し、ラックレベルで導入を可能にすることで、設置から運用までの時間を大幅に短縮するラック・プラグアンドプレイ・ソリューションを提供しています。

液体冷却にはコールドプレートを用いてコンポーネントを冷やして冷却用の液体は外部のチラーで循環冷却する方法や、冷却する特殊な液体プールにハードウェアを浸けてしまう液浸など、いくつかの手法があります。液体冷却には注意すべき点もあり、一般的な空冷方式に比べて追加で液体冷却用の設備投資が必要になるため、データセンターの規模に応じて費用対効果があるかどうかを考慮する必要があります。

ディスアグリゲート・サーバで電子廃棄物を削減

国連のGlobal E-Waste Monitor 2020 によると、2019年には世界で5,360万メトリックトン(Mt)の電子廃棄物が排出されており、その量は5年間で21%増加したことが明らかになっています。そこで、電子廃棄物などの環境問題やコスト削減を背景に、ディスアグリゲート・サーバ・アーキテクチャへの関心が高まっています。

ディスアグリゲート・サーバはCPU、メモリ、ネットワーク、ストレージ、I/Oデバイス、電源など、ライフサイクルがそれぞれ異なる各コンポーネントを分離して、それぞれのテクノロジーのライフサイクルに合わせて、コンポーネント単位で換装できるように、マザーボードや内部構造が設計されています。これにより、サーバやラック全体を交換することなく、新たなテクノロジーの早期導入や、パフォーマンスが低下してしまった特定の部品を、高速かつエネルギー効率の高いテクノロジーにコンポーネント単位で交換することできます。このようにコンポーネント単位で交換することで、電子廃棄物を大幅に削減できます。今後は、環境への影響を軽減しながら生産性を向上させるハードウェアの設計が重要になると予想されています。

以上、環境にやさしいデータセンターを構築するための方法を紹介してきました。データセンターによる消費電力量、二酸化炭素排出量、電子廃棄物量は増加傾向にあります。未来の世代のためにも環境への悪影響を減らすグリーン・データセンターなどの低炭素化が重要です。

PUEが1.25未満のデータセンターがグリーン・データセンターに分類されますが、一般的なデータセンターではPUE2.0にとどまります。加えて、Supermicroが2021年に発行したレポートによると調査対象になったデータセンターの半数以上がPUE1.5~2.5だったことが明らかになり、引き続きエネルギー効率の改善に向けた取り組みが欠かせません。

システム換装時に発生する電子廃棄物についても、サーバ全体ではなく該当するコンポーネントのみを交換することで環境への影響を軽減することができます。革新的な技術の進歩とデータセンターの総環境コスト(TCE)のバランスを取りながら、グリーンコンピューティングに取り組むことで地球および環境に配慮した持続可能な経済活動を継続することができるでしょう。

著者プロフィール

矢部 充(やべ みつる)Supermicro テクニカルマーケティングディレクター

Digital Equipment Corporation(DEC)、OracleでのSE職を経て、Silicon Graphics Inc. で17年間に渡り、ハイエンドグラフィックス製品、ワークステーション製品全体の製品技術統括として、防衛、航空宇宙、製造業、官公庁を中心に、シミュレーター、デザインレビュー、遠隔可視化、HPC/CAEの可視化、CAD、VR/ARなど、近年のあらゆるGPUビジネスの基礎となる市場開発に従事。約20年前にはSupermicro製汎用PCサーバーに国内初となる複数枚の市販GPUカードを搭載した汎用マルチGPUサーバの構築を手がける。現在はSupermicroで市場開発と推進を担当。