Googleはかつて「世界中の情報を整理する」というビジョンを実現するために、検索に最適化したシステムを設計し、データセンターをゼロから作り上げた。同じように同社は今、機械学習とAIに最適化したデータセンターの構築に取り組んでいる。昨年のGoogle I/Oでディープラーニング専用の処理ユニット「TensorFlow Processing Unit (TPU)」の開発を発表した。囲碁のプロ棋士を次々に打ち負かして大きな話題になった「AlphaGo」がTPUを使用しており、AlphaGoの急成長ぶりがTPUの評価も上がった。

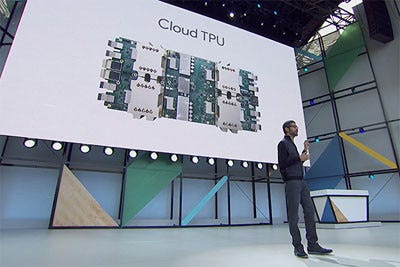

そして今年、Googleは第2世代のTPUを発表した。機械学習のプロセスは大きく「学習 (training)」と「推論 (inference)」の2つに分けられる。ビッグデータからモデルを構築する学習には多大なコンピュテーション能力が必要であり、昨年のTPUは推論の処理に限定した設計だった。第2世代のTPUは、学習と推論のどちらにも最適化されている。1枚のボードに4つのプロセッサを搭載し、演算能力は最大180テラFlopsになる。64台のCloud TPUを相互接続したTPUポッドを構成することで最大11.5ペタFlopsの演算能力を得られる。

第2世代のTPUをCloud TPUとしてGoogle Compute Engineに導入し、クラウドの機械学習サービスとして提供する。ユーザーはGoogleが公開したオープンソースソフトウエアの機会学習フレームワーク「TensorFlow」を使ってTPUをプログラミングできる。また、コンピューティング能力を必要とする機械学習の研究者に対して、「TensorFlow Research Cloud」プログラムを通じてCloud TPUを無料提供する。Cloud TPUを基盤に、Google Cloudは機会学習とAIのための理想的なクラウド環境になる。

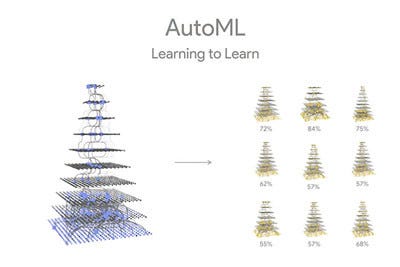

機械学習やAIの成長の壁になっているのは演算能力だけではない。機械学習モデルのデザインには専門的な知識やスキル、そして時間が求められ、現状でそうした技能に長けたエンジニアや研究者は限られる。それではAI優先のスケールアップは進まない。そこで、Googleは強化学習のアプローチで、ニューラルネットワークを用いて機械学習を自動化する「AutoML」というプロジェクトに取り組んでいる。骨の折れるモデルの学習をAIに任せて自動化することで、高度なスキルを持つ技能者でなくても機械学習を活用した開発を行えるようにする。