カリフォルニア州で、罰則を含む法的強制力のあるAI安全法案が上院で32対1の大差で可決されました。提出からわずか4カ月というスピード通過です。その背後にはAIの急速な進展とその潜在的脅威に対する恐れがあり、AI推進派との間でシリコンバレーを二分する論争が巻き起こっています。

「AIは自動車か、それともインターネットか」論争

ある会社が車を作り、十分な安全テストも行わすに販売して人命が損なわれるようなことになれば、その会社は責任を問われ、刑事罰は免れたとしても、存在賠償の支払いが求められることになるでしょう。

検索サービスで殺傷能力のある武器の作り方を調べた人が、結果で知り得た方法で誰かに危害を加えたとしても、検索サービスは原則的に第三者が発信する情報について責任は問われません。これはインターネットがオープン性、分散性、標準化、競争を原則とし、表現や言論の自由が認められるべきと考えられているからです。

では、AIチャットボットのような生成AIモデルの開発は、車のように開発者が十分な安全対策を行い、安全品質の責任を負うべきものでしょうか? それとも、インターネットのようにオープンであるべきものでしょうか?

カリフォルニア州で5月16日に、最先端のAIモデルの安全性を確保するための規制法案「Safe and Secure Innovation for Frontier Artificial Intelligence Models Act.」(SB 1047)が上院議会を通過しました(賛成32票、反対1票)。これが、AI開発の中心地となっているシリコンバレーを二分する論争を巻き起こしています。

米国のAI規制というと、昨年末にバイデン大統領がすでに大統領令を発布しましたが、それはAIの安全性に関する原則を示したのみで、実行は自主的な取り組みに任せられています。カリフォルニア州のSB 1047は、罰則を含む法的な強制力を持つという点で異なります。

カリフォルニア州のAI安全法案という言葉について初めて聞いた人も多いと思います。それもそのはずで、米国でAI分野に携わっている人でも同州の上院可決まで知らなかったという人が少なくありません。

というのも、2024年2月にスコット・ウィーナー上院議員によって提出されたばかりの法案だからです。4月に上院司法委員会を通過し、わずか4カ月で上院を通過しました。

しかも、上院では賛成32票、反対1票という大差で可決され、成立が有力視されています。欧州連合のAI法が3年かかって成立した記憶がまだ新しく、SB 1047がこれほど迅速に前進していることに多くの人が驚いています。

高度なAIシステムは「危険な能力」?

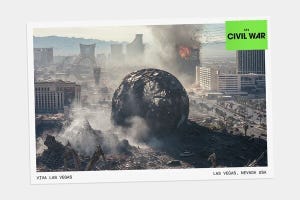

SB 1047は、対象となる高度なAIシステムの開発者に対し、「危険な能力」を特定するための安全性評価を実施することを義務付けています。危険な能力とは、生物兵器、化学兵器、核兵器といった大量破壊兵器の作成や使用を可能にする能力や、公共の安全に対する脅威を生み出す可能性を指します。

要求される安全対策には、AIシステムが危険な動作をした場合にシャットダウンする機能や、新たに設立される規制機関に事故を報告する仕組みなどが含まれます。コンピューティング・クラスタ運営者は、顧客情報を取得・確認し、毎年検証・評価しなければなりません。

カリフォルニア州司法長官は、違反に対して民事訴訟を起こすことができ、違反した場合、モデル開発費の最大30%の罰金が課される可能性があります。

-

MetaのチーフAIサイエンティストであるヤン・ルカン氏は、 SB 1047が「カリフォルニア州の技術的イノベーションの素晴らしい歴史を破壊する。これはAI安全法案ではなく、トロイの木馬だ」という投稿を紹介(@ylecun)

シリコンバレーのAI推進派はSB 1047に猛反発しています。

6月5日、スタンフォード大学のHAI(Human-Centered Artificial Intelligence)の5周年イベントでもSB 1047が議論の1つになりました。その中で、Andreessen Horowitzのマーク・アンドリーセン氏は「強力なAIとオープンソースを規制するには、(ジョージ)オーウェルが赤面するような度合いの広範な監視が必要なだけでなく、それを世界的に実施する必要があります」と述べました。

安全性が証明されるまで技術開発を抑制するのは、明らかな脅威が存在する場合には適切な対応となり得ます。しかし、AIが潜在的に人類に深刻な危害をもたらすという主張に根拠はなく、その開発を抑制するのは合理的ではないというのが推進派の主張です。

たとえば、Google Brainの共同設立者である研究者・投資家のアンドリュー・ン氏は、「私が『AIが悪になることを心配していない』と言うのは、(火星の植民地化を想定して)火星の人口過剰を心配していないのと同じ理由です」と述べています。そして、米国は中国やロシアとの競争に直面しています。

SB 1047で特に危惧されているのが、アンドリーセン氏も指摘しているオープンソースの取り組みへの影響です。近年のAI開発では、オープンソースの開発が画期的な進展の推進力となってきました。

SB 1047のもとでは、開発者が安全策を講じて公開したとしても、公開後の技術の使われ方によって開発者の責任が問われる可能性があります。その結果、AI技術開発や知識が大企業に集中し、AI新興企業が台頭する可能性が損なわれるかもしれません。

-

AIオープンソースコミュニティのリーダーであるHuggingFaceのCEO、クレム・デラング氏は「カリフォルニア州と米国のイノベーションの両方にとって大きな打撃になる」と懸念を表明。 (@ClementDelangue)

AIに何ができるかをよりよく理解する

シリコンバレーの技術者や研究者がすべてAI推進派というわけではありません。同じぐらい多くのSB 1047の支持者がいるから、同法案がスムーズに進んでいるのです。SB 1047支持者は、「意図せざる結果」は予測も防止も困難なものであり、AIには「差し迫った明らかな脅威がない」という見方は、急速な進化を遂げているAIに対して楽観的すぎると指摘しています。

技術がオープンソースで公開されても、学習データが非公開であったり、動作原理や内部プロセスの複雑さから出力の予測が困難であるなど、透明性の課題が残されています。さらに、GoogleやOpenAIといったAI技術を開発する企業内部からも、現従業員や元従業員から成るグループが、AI技術開発の現場にいる者だけが知る懸念を公表することに対して保護を求める声が上がっています。

私見を述べると、SB 1047は法的強制力を持つものの、責任法に関して何かを追加しているわけではありません。SB 1047で課せられる責任は、SB 1047の有無に関わらず、AIモデルの開発者が負うものです。

オープンソースモデルに取り組んでいる企業や小規模な開発者への影響についても、1026 FLOPs以上の計算能力で学習されていて1億ドル以上の計算コストがかけられたAIモデルに対象を限り、小規模な開発者の責任と報告義務を軽減するなど、様々の対策が修正案で講じられています。SB 1047に対して、カリフォルニアおよび米国のAI開発競争力を「骨抜きにする」というのは過度な警戒に思えます。

それにも関わらず、SB 1047が論争を巻き起こしているのは、AI開発が冒頭の「AIは自動車か、それともインターネットか」という疑問に対する答えを得られていないからではないでしょうか。

たとえば、中央集権的な管理を受けない取引や契約を可能にする分散型技術のブロックチェーンは、その性質上、規制なく自由に開発・利用されるべきというコンセンサスの上で必要な規制が論じられています。

プライバシーとセキュリティの保護を目的とした暗号化技術は、個人や企業が自分たちの情報を守るために自由に利用できるべきというコンセンサスの上に成り立っています。自動運転車にはインターネットの進化とともに発展した技術が数多く用いられていますが、その開発・利用は自動車と同様の安全基準に沿って行われるべきと考えられています。

そうした根本があるからこそ、規制について支持者と反対派が対立しても議論が噛み合っていましたが、AI開発はそうではありません。

深層学習の"ゴッドファザー"と呼ばれるヤン・ルカン氏、ジェフリー・ヒントン氏、ヨシュア・ベンジオ氏の間でも、ベンジオ氏とヒントン氏はSB 1047を支持し、ルカン氏は懐疑的な見方を示しています。

チューリング賞の受賞者の間でもAIモデル開発の根本的なアプローチで意見が分かれています。私はこれほど重要な問題で、これほどコンセンサスが得られていない論争に出会ったことがありません。

政策対応を正しく行うには、AIに何ができるかをよりよく理解し、政策対応を必要とする危害のシナリオを正しく把握する必要があります。SB 1047の支持派も、反対派も、AI技術の安全かつ持続可能な発展を促進し、社会全体に利益をもたらすべきという点では一致しています。

しかし、SB 1047はAIシステムが人類に危険をもたらす可能性があるという考え方を前提としています。その前提が正しいかどうか、AI開発のスタート地点をどこに置くかが決まっていないのにレールを作って走り出そうとしているから、大きな反発を招いているのです。この問題が解決しない限り、今後もあらゆる判断において同様の大きな論争が繰り返されることになるでしょう。