埼玉大学と近畿大学(近大)の両者は11月6日、白地に金の飾り(白/金)または青地に黒の飾り(青/黒)という、人によって見え方が大きく2パターンに分かれる錯視画像として、2015年にSNS上で話題になった「#TheDress画像」の錯視が生じる脳の仕組みが未解明だったものの、その要因が経験に基づく画像の解釈の違いにあることを計算機モデルを用いて示したと共同で発表した。

同成果は、埼玉大大学院 理工学研究科の栗木一郎教授、同・清川宏暁助教、近大 情報学部の篠崎隆志准教授らの共同研究チームによるもの。詳細は、動画などが不可欠な知覚研究の新興分野を扱う学術誌「i-Perception」に掲載された。

実は未解明だった話題のドレスの謎に迫る

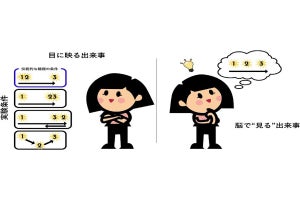

現実に目の前に存在する物体の色は、太陽光や照明などの入射光を物体が吸収せずに反射した残りの光を基に、脳内で処理されることで認識される。しかしそれを画像で見る場合、その構図の中には照明が写らないように撮影されることが多いため、画像中の陰影や色味などから照明光を推測することになる。#TheDress画像は、この照明光の推定における個人差が大きいと考えられている。

晴天時の日陰にある白い物体は、青空の光を反射するため青白く見える。しかし、経験的にこれが白い物体だと学習すると、脳が青白い光を白い物体と解釈する「ブルー・バイアス」現象が生じることが知られている。このブルー・バイアスが強く作用すると、#TheDress画像は青/黒ではなく、白/金に解釈されると予想されていた。だが、このブルー・バイアスは経験的に獲得されるため個人差があり、実験的に操作することが困難なことが課題だ。

そこで研究チームは今回、経験的に獲得されるブルー・バイアスの個人差を計算モデルとして実現した場合に、その計算モデルが人間のように白/金や青/黒のような個人差を#TheDress画像に対して示すのかを調べたという。

今回の研究では、DNN(深層学習)モデルの一種である計算モデル「pix2pix」を用い、入力した画像を日本語の基本19色に変換した画像で出力するような機械学習を行い、人間が色を色名で答える状況が模倣された。この機械学習は、計算モデルに入力画像と正解をペアで与え、その正解との誤差が小さくなるように計算モデルを最適化する手順となる。さらに、この画像と色名付けの関係を学習させる際、青空の下に白い被写体がある構図の画像(ブルー・バイアス画像)を含める比率を10%刻みで10段階に変化させ、合計10種類のモデルが作成された。

-

DNNモデルの機械学習時にブルー・バイアス画像を混ぜて比率を変えたモデルに対し、#TheDress画像を用いてテストした結果の例。左から、元画像(入力画像)と、ブルー・バイアス画像の比率が0%~50%の場合の出力例が示されている。パーセンテージが増えるほど、青/黒から白/金へと変化することが確認された。ちなみに、実際には、同じ条件で10回繰り返してDNNモデルを作成した上で、評価が行われた(出所:埼玉大プレスリリースPDF)

その結果、ブルー・バイアス画像の比率が0%~50%までの間で#TheDress画像に対する出力が段階的に変化し、青/黒から白/金に至る画像が出力された。なお、色名付けの学習の際には#TheDress画像は一切使っておらず、学習が済んだ後のテスト段階においてのみこの画像が使用された。この結果は、ブルー・バイアスに関わる情景に接する機会や、青空の下で白い物体に着目する機会に依存してブルー・バイアスの個人差が生じ、その結果、#TheDress画像における色の感じ方についての個人差が生じた可能性が示されているとした。

計算モデルを用いることの最大の利点は、極端な環境での学習や解剖など、人間が対象ではできない実験手法が可能な点だ。今回の研究では、極端な環境での学習を実施する方法が用いられたが、研究チームは今後、計算モデルの内部を分解し、ブルー・バイアスによって生じる情報表現の違いの解読を試みるという。その結果、人間の脳内におけるブルー・バイアスの情報表現について手がかりを得られる可能性があるとした。得られた手がかりをもとに、脳機能計測などの手法を用い、脳内の色情報処理についてさらなる解明を進める予定としている。