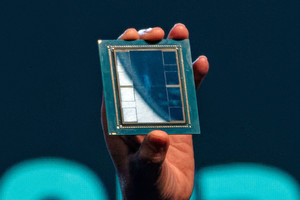

AMDは10月10日(米国時間)、次世代AIインフラの大規模展開への対応に向けて、AMD CDNA 3アーキテクチャベースのアクセラレータ「AI Instinct MI325X」を発表した。

同アクセラレータは、256GBのHBM3Eメモリにより6.0TB/sの帯域幅を提供することで、NVIDIA H200と比べて容量が1.8倍、帯域幅が1.3倍に向上。これにより、Mistral 7BのFP16推論性能が最大1.3倍、 Llama 3.1 70BのFP8推論性能が最大1.2 倍、 Mixtral 8x7BのFP16推論性能が最大1.4倍向上するという。

2024年第4四半期より出荷される予定で、2025年第1四半期からDell Technologies、Eviden、Gigabyte、Hewlett Packard Enterprise、Lenovo、Supermicroなどのプラットフォームプロバイダからシステムが提供される予定だという。

また、同社は次世代アクセラレータとして、AMD CDNA 4アーキテクチャベースの「AMD Instinct MI350シリーズ」も発表しており、アクセラレータごとに最大288GBのHBM3Eメモリを搭載し、CDNA 3ベースのアクセラレータと比較して推論性能が35倍向上するように設計されているという。こちらは、2025年下半期の発売が予定されているという。

次世代AIネットワークに向けた2製品も発表

同社はAIインフラにおけるCPUやアクセラレータの効率的な活用に向けたAIネットワーキングを実現することを目指し、フロントエンド向け「AMD Pensando Salina DPU」、バックエンド向けにUltra Ethernet Consortium(UEC)対応AI NIC「AMD Pensando Pollara 400 NIC」も発表している。

AMD Pensando Salina DPUは、同社の第3世代DPUという位置づけで、400Gのスループットをサポートし、前世代比でパフォーマンス、帯域幅、スケールが最大2倍向上したという。一方のAMD Pensando Pollara 400は、AMD P4プログラム可能エンジンを搭載したUEC対応AI NICで、次世代RDMAソフトウェアをサポートしているという。

いずれも2024年第4四半期に同社顧客での試用が開始され、2025年上半期より利用可能になる予定だという。