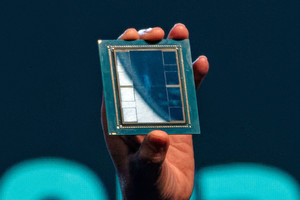

AMDは9月26日(米国時間)、同社のAIアクセラレータ「AMD Instinct MI300X」が、オラクルの提供する「Oracle Cloud Infrastructure(OCI)Compute Superclusterインスタンス」に搭載されたことを発表した。

それによると、数千億のパラメータで構成されるAIモデルの場合、MI300Xを搭載したOCI Superclusterインスタンスは、OCI上のほかのアクセラレータで使用されているのと同じ高速ネットワークファブリックテクノロジを活用することで、単一クラスタ内で最大1万6384個のGPUをサポート。これらのOCIベアメタルインスタンスは、大規模言語モデル(LLM)の推論やトレーニングなど、負荷の高いAIワークロードを実行するように設計されているという。

また、MI300XはOCIによって検証された広範なテストを経て、バッチサイズが大きい場合でもレイテンシが最適なユースケースに対応できるAI推論およびトレーニング機能と、単一ノードに最大のLLMモデルを適合させる能力が確認されたとのことで、特に低遅延が重要なケースに適していることが示されたともしている。

なお、Fireworks AIなどの企業がすでに利用しており、Fireworks AIでは、MI300Xを搭載したOCIコンピュートソリューションを活用する形で、100を超えるモデルを備えた生成AIを構築および展開するために設計された高速プラットフォームを提供しているという。