サイバーエージェントは12月4日、同社の人工知能技術の研究開発組織「AI Lab」が大阪大学大学院、東海国立大学機構、名古屋大学、海遊館の4者とともに、大規模言語モデル(LLM)を利用した複数の接客ロボットの自律・遠隔制御の実証実験を実施したと発表した。

同実証実験では、「自律・遠隔接客ロボット」からオペレータへの最適な対話要約手法およびインタフェースの検討を行った。海遊館の運営する生きもののミュージアム「ニフレル」にて、LLMを用いた自律対話システムと、対話要約インタフェースを備えた遠隔操作システムを実装した展示案内アバターロボットを6体設置。これらのロボットが来場客への館内案内・展示紹介を行った。

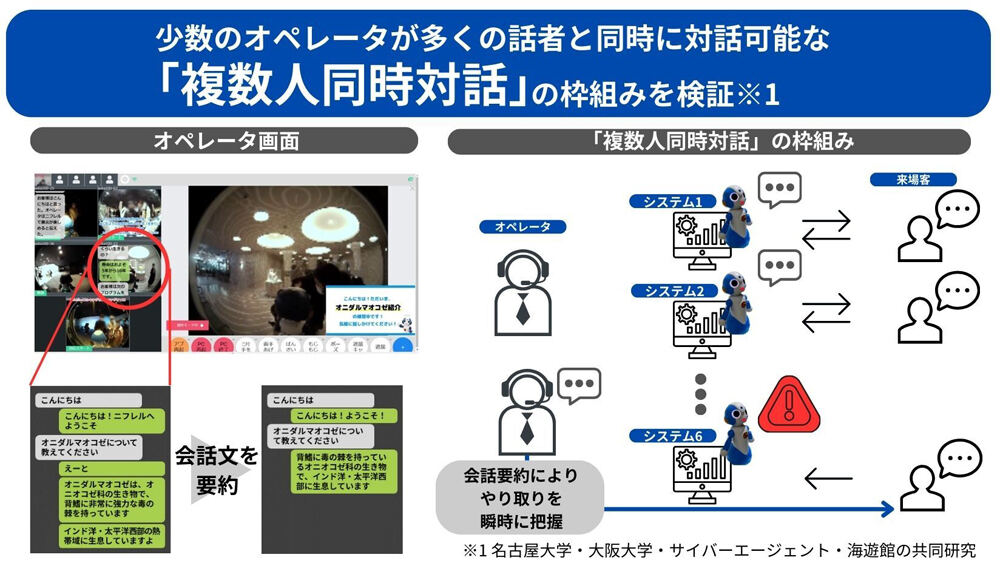

ロボットが適切に対応出来なかった場合に、2名のオペレータがロボットを通して接客対応をする。「大規模言語モデルに基づく自律対話システムによる発話の正確性および対応が困難となる条件」「対話ロボットからオペレータへそれまでの対話を共有する際、要約の種別や方法による来場客満足度の変化」の2点を調査した。

複数人同時対話の枠組みを検証するため、26日間行われた実証実験で計14万回以上の発話、および2000回以上の介入に関するデータを収集。分析の結果、大規模言語モデルを適用したシステムは高度な自律対話を実現できることが判明したという。

一方で、ロボットが適切に対応できずオペレータが介入したデータを分析したところ、人物の認識やロボット周辺のリアルタイムな状況などが含まれる対話は、言語モデルから得られない情報に起因することが分かった。

またオペレータは対話をモニタリングする画面において、音声認識結果をそのまま見るだけでなく、その自動要約結果も見ることができた。対話形式を要約したとき(長い対話を短い形式の対話として要約したもの)の方が、音声認識結果そのままを表示したときと比較し、対話のやり取りを瞬時に把握するために有効であることが示されたとしている。

サイバーエージェントらは今後、今回発見した知見をもとにさらなる実験を行い、新たな有用な対話要約手法の探索や自律案内機能の改善・改良を行っていく考えだ。