日本マイクロソフトは4月20日、GPT-4を採用したAIアシスタントツール「Microsoft Security Copilot」(マイクロソフト セキュリティ コパイロット、以下Security Copilot)に関するメディア向けのオンライン勉強会を開催した。

Security Copilotは、2023年3月28日(米国時間)にプレビュー版のリリースが発表されたセキュリティ担当者向けのツールだ。ChatGPTと同様、プロンプトにテキストで要望・指示を入力して利用する。勉強会では、同ツールの開発背景や効果的に活用するにあたってのポイントが紹介された。

運用経験がないエンジニアのセキュリティ業務を支援

Security Copilotにはサイバー攻撃などの分析機能は実装されておらず、普段から利用しているマイクロソフトのサービスが生成したデータの検索・集約が同ツールの主な機能となる。

そのため、日本マイクロソフトはSecurity Copilotについて「業務円滑化のためのインターフェース」と位置付ける。

日本マイクロソフト 技術統括室 チーフセキュリティオフィサーの河野省二氏は、「プログラミングスキルのないエンジニアでも、チャットを通じて、組織内のマイクロソフトソリューションからセキュリティデータを横断的に活用可能とする。そのためのインターフェースがSecurity Copilotだ」と説明した。

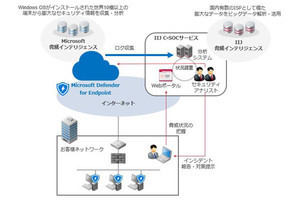

マイクロソフトは現在、Microsoft Defenderをはじめとしたセキュリティソリューション群「Microsoft Security」を提供している。また、Microsoft 365やWindowsなどのマイクロソフト関連ソリューションのデータはMicrosoft Graphに蓄積されている。

セキュリティ業務の運用高度化のために、マイクロソフトはセキュリティにまつわる情報を一元管理できるダッシュボードのほか、セキュリティ関連データを横断的に検索できるAdvanced Huntingや、Microsoft Graphと他のアプリケーションを連携してデータ活用するためのGraph Security APIを提供してきた。

「だが、セキュリティ運用経験の無いエンジニアは、ダッシュボードでインシデントを検知しても何をしたらいいかわからない。また、Advanced HuntingやGraph Security APIを利用するにあたってはクエリやプログラミングのスキルが必要だ。セキュリティ分野の『Do more with less(より少ないリソースでより多くを)』を実現するため、今回、Security Copilotが提供されることとなった」とSecurity Copilotの開発背景を河野氏は明かした。

データのリソース次第でアウトプットの質が変わる

Security Copilotで具体的に行えることとしては、「インシデント対応」「脅威ハンティング」「報告書の自動作成」が挙げられた。

ユーザーの質問に対して、Security Copilotは進行中の攻撃を特定して、被害規模を評価したり、過去のインシデントで実証された戦術に基づく対応方法を提供したりできるという。また、既知の脆弱性の影響度合いや、IoC(Indicator of Compromise、侵害の痕跡)の有無を調査することも可能だ。

発生したインシデントを要約した報告書は、PowerPointやWordなどアプリケーションを指定して作成できる。経営層向け、社外ステークホルダー向けなど報告先に合わせたカスタマイズも可能としている。

このほか、すでに解決しているインシデントの詳細を深掘りするなど、セキュリティ専門家向けのツールとしても活用余地があるという。

「SOC(Security Operation Center)のTier1の負荷を削減できると、プレビュー版を試したユーザーから注目されている。今後の一般提供では、『あなたが知りたいのはこちらですか?』といった提案を表示する機能の提供も考えられる」(河野氏)

その一方で、Security Copilotへの過度な期待は禁物だという。Security Copilotはあくまで、Microsoft Graphに蓄積されたデータや各種セキュリティサービスが生成しているデータを基にアウトプットを行う。そのため、参照するリソースやセキュリティサービスの使い方によってアウトプットの質が左右される。

ログやトレーニングデータはユーザーのテナント内に存在

マイクロソフトは、生成AIを利用したテキストチャットでやりとりを行うAIツールを「Chat AI」と総称しているという。勉強会ではChat AIにおけるデータの取り扱い姿勢も解説された。

「企業や組織が保有するデータは所有者のものであり、AIモデルの基盤を訓練するためには利用されない。それらのデータは企業などのコンプライアンスやセキュリティ対策によって保護される」と河野氏は強調した。

Bing AI Chatの場合は、Bingにおけるセキュリティポリシーを踏襲しており、ログの記録においては利用者情報を削除し、トレーニングデータからも個人情報を削除している。

Security Copilotを含めたCopilotシリーズは、社内のリソースを使うことを前提にしたモデルとなる。ユーザーがプロンプトに入力した際の認証と通信は暗号化される。また、ユーザーがAIにアクセスした際のログやサービスインスタンスの設定・ルール、AI教育のためのトレーニングデータなどは、Microsoft OneDriveやMicrosoft SharePointと同様にマイクロソフトがアクセスできないユーザーのテナント内に存在する。

マイクロソフトユーザーからは、「入力した質問に会社の機密情報が含まれた際に、その情報がどこに、どの程度の期間保管されるか?」について多く質問されるそうだ。

この問いに対して、河野氏は「Copilotシリーズが参照するデータは、社内の情報が蓄積されたMicrosoft Graphに存在しユーザーが制御している。そのため、企業や組織の管理者がMicrosoft Graphにどのようなポリシーを適用して、データを管理するか次第で機密情報の取り扱い方も変わる」と答えた。