東京工業大学(東工大)と科学技術振興機構(JST)は、頭皮で記録された脳波信号(EEG)から音声を直接再構築するために有望な手法を開発したと共同で発表した。

同成果は、東工大 科学技術創成研究院の吉村奈津江准教授(科学技術振興機構さきがけ研究者兼務)、同・明石航大学院生(研究当時)、同・神原裕行助教、同・緒方洋輔特任助教(研究当時)、同・小池康晴教授、同・ルドビコ・ミナチ特定准教授らの研究チームによるもの。詳細は、独科学技術誌「Advanced Intelligent Systems」に掲載された。

脳活動信号から脳内の情報を読み出すブレイン・マシン(コンピュータ)・インタフェース(BMI)に関する研究が活発だ。BMIは、障がいのある人が脳波で直接機器を操作するという方面での研究も進められているが、それと同時に同じ技術を用いることで、研究者が何十年にもわたって研究してきた脳内の情報処理過程の解明にも大きく貢献しているという。

BMIを活用する技術として、脳波から音声情報を読み出しというものがあるが、その研究も進む。吉村准教授らが取り組んでいるのが、脳内の神経細胞の活動を反映した電気信号を頭皮に付着した電極から記録するEEGを用いて音声情報を読み出すという技術だ。EEGから脳内の神経活動を機械学習により推定し、筋活動、指の動きなど、これまでEEGからでは困難だと考えられてきた情報を抽出することに成功してきた。

なお、より確実に脳波を取得するため、電極を頭蓋骨下の脳皮質表面に埋め込む手術を伴う「皮質脳波信号(ECoG)」を使用して聴覚処理に関連する脳領域から直接信号を取得し、それによって音声合成を試みるという研究も行われている。しかし機械学習技術を用いても、ECoGでは聞き取りやすい音声の合成は依然として困難な状況にあったため、今回の研究成果は非侵襲的であるにもかかわらず、大きな躍進といえそうだ。

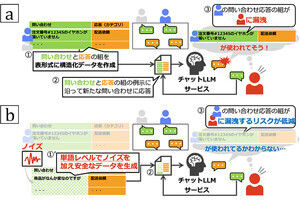

今回の研究では、音声認識や音声合成に用いられている、音源の内容を表す特徴を時系列信号として抽出した「メルケプストラム」という音声情報を表現しているパラメータを「畳み込みニューラルネットワーク」(CNN)モデルで推定。物理的に提示または想起された母音を、EEGから合成するというものである。

具体的には、まず頭皮32か所のEEG電極から、参加者が母音の「ア」、「イ」、および白色雑音を聞いているときと、そののちに聞いた音声を想起しているときのEEGを記録。そして、聞かせた音源のパラメータ信号をEEGからCNNを用いて推定して音源の復元が行われた。そして、復元された音声が耳で聞き分けられるかどうか、別の参加者による聞き取り判別試験も行われ、すべての参加者の脳波データにおいて、おおよそ85%を超える判別が可能だったとした。

-

EEGから推定した音源パラメータ波形と復元した音声の聞き取り精度を示した結果。(A)元の音源パラメータ波形(青)とEEGから推定した波形(赤)の比較(R2=1で、完全一致)。(B)音を聞いたときのEEG(上)と、音を思い出したときのEEG(下)でどの参加者も高いR2分布を示したという。「ア」と「イ」の違いはR2が0.8を超えると80%以上の確率で聞き分けられたとした (出所:共同プレスリリースPDF)

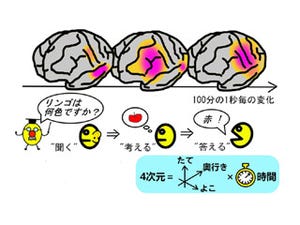

このような高い精度で音声情報を抽出できたということは、CNNが音源推定に利用した脳の領域と信号の時間的なタイミングが、脳内の音声処理過程を間接的に反映していることが考えられるという。その領域の調査が行われた結果、脳内の聴覚処理において、何の音かを検知するための信号が処理される「Whatストリーム」と呼ばれる脳領域群が主に使われていることが判明したとした。

今回の研究成果は、コンピュータが抽出した脳内の特徴が脳科学的にも妥当であったことを示唆しているとする。また吉村准教授らが注目しているのが、音を聞いているときと音を思い出したときでCNNが抽出した脳領域に違いがあり、個人ごとの脳領域の違いも見られたことだという。

今回は2種類の母音の違いだけを調べた研究ではあるが、耳で聞き分けられる聴取性能の高い音声をEEGから再構成できたため、本人がどのように聞こえているかを第三者に伝えることができる可能性があり、聴覚検査の客観的な手法として使える可能性があるとした。

また、この技術をさらに進歩させることで、個人の脳内のどの領域が聴覚・音声・言語処理に関係しているのかについての理解を深めることが期待され、BMIなどのさまざまな将来のアプリケーションへの道を開く可能性があるとしている。