サーバ自体も独自に最適化

また、Facebookはサーバ自体にも工夫を凝らしている。

市販のサーバは前面板、上側のカバーなどが付いている。これはコスメティックな面もあるが、妨害電波を遮蔽してVCCIやFCCなどの規格に適合さるためにも欠かせない。また、ラックからサーバの引き出しを容易にするためのレールなどがついている。しかし、Facebookのデータセンターのような環境ではこれらは不要であり、ムダである。また、マザーボードの機能としても、市販品は最大公約数的に必要な機能を搭載しているが、自社のデータセンターでは必要ない機能は搭載しなければ、その分の部品代が削減できるし、その回路の消費電力分も減る。

市販サーバのカバーを開けると多くのケーブルやねじがあり、故障部品の取り外し、取り付けにも時間がかかる。これは保守作業に必要な人件費に直結する。従って、不要なものはすべて排除し、ねじやケーブルも最小限として保守時間を短くできるサーバが望ましい。

また、データセンターのようにラックが隣接して並んでいる場合は、保守のためにサーバの裏側にアクセスするにはサーバラックの列の端を回り込んで何10mも移動しなければならないので、時間が掛る。このため、基本的に前面からだけで保守できる構造が望ましい。

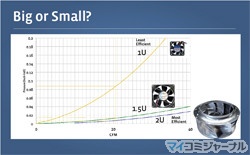

市販のサーバには1U(厚みが1.75インチ)と2U(2倍の3.5インチ)のものがあるが、どちらが良いかという問題もある。

各種の大きさのファンの特性を調べてみると、1Uに入る直径の小さなファンでは一定の風速を得るのに高い圧力が必要で、電力効率が悪い。ファンの直径を大きくする必要な圧力は減り効率が良くなるが、1.5Uと2Uではそれほど大きな差が無い。このことから、Facebookではサーバの厚みを1.5Uにしている。これにより、ラックに搭載できるサーバ数と冷却ファンに消費電力のバランスを最適化できるという。

このような1.5Uの厚みのサーバは市販品には存在しないが、Open Computeプロジェクトで標準化してFacebook以外のデータセンターからも要求が出るようになれば、安価な市販品も出てくるはずである。

Facebookのサーバシャシーは、1.5Uの厚みで直径60mmの効率の良いファンを4個搭載し、450Wの480VC/48VDC両用電源を搭載する。そして、最大6台のHDDを搭載できる。これらのユニットは切欠きにひっかけたピンとスプリング付のピンを穴に差し込んで固定されており、ピンを引っ張るだけで取り付け、取り外しができ、工具を必要としない。日本の場合、この構造で地震に耐えられるのかという心配はあるが、オレゴンではそういう懸念はないのであろう。

前述の480VACと48VDC両用の450W電源は、定格の50%~90%の出力の範囲で95%以上と高い変換効率を持っている。