このように、Virtual PCの便利さを享受しつつもパフォーマンスに不満を抱いていたところに登場したのが、Windows Server 2008 R2と、ハイパーバイザ型仮想化環境のHyper-Vだったというわけだ。これならVirtual PCを使うよりも効率的に仕事をできるのではないかということで、β版が出た時点でさっそく試してみた。

- 3回

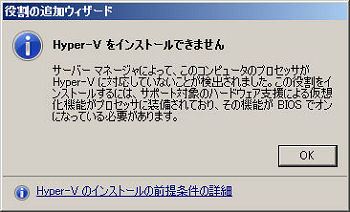

ところが、新しいものに飛びつくと、なにかしら騒動が起きるのはお約束である。当時、実験機の主力になっていた自作PCは、CPUにPentium D 915を使用していたのだが、あいにくとPentium D 915はIntel VT(Virtualization Technology)に対応していない。そのため、Windows Server 2008 R2をセットアップした後で、[サーバーマネージャ]を使ってHyper-Vの役割を追加しようとしたら、こんなエラーが出てしまった。

読者の皆さんはこんな失敗を繰り返さないように、以下の記事を確認してシステム要件を整えてから導入するようにしよう。

Hyper-V の概要

Hyper-V のパフォーマンスおよび容量の要件

チェックリスト: 開発とテストのために仮想マシンを構成する

- 3回

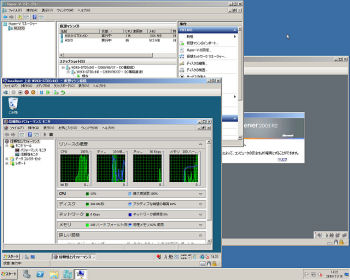

筆者の場合、手持ちの実験機が装備するCPUではHyper-Vを動作させることができなかったので、慌てて秋葉原のパーツショップに走り、中古のCore 2 Duo E6600(←この辺がせこい)を買ってきて問題を解決した。実際に使い始めてみると、すでにVirtual PCを使っていて仮想化環境そのものについては馴染みがあっただけに、基本的にはすんなりと使い始めることができた。

期待した通り、Hyper-VはVirtual PCよりも体感性能が向上している。また、32ビットOSだけでなく、64ビットOSを動作させられるメリットもある。試してみたらすっかり気に入ってしまったので、実験機のメモリとハードディスクを増強することで、それまで複数のリアルPCに分かれていた実験環境を1台の実験機に集約できた。