ABCIのラック冷却の仕組み

ABCIのラックはラック列の排気側が向かい合わせになるように置かれている。そして、排気側はクーリングポッドと呼ぶ、2階建ての工事の飯場のような建物で覆われている。CPU、GPU、DIMMは温水冷却されるが、NVMeのSSDやInfiniBandのHCAなどは空冷になっているので、ラックの排気は40℃まで温度が上がる。これをこの建物の中に閉じ込めて、32℃の水で冷却されるファンコイルユニットで35℃に冷却してデータセンターの室内に戻している。

覆いのクーリングポッドの左の上部の壁面に見えるのがファンコイルユニットである。クーリングポッドに接続されているパイプは、冷却水の供給、排出系とファンコイルユニットからの水のドレーンなどである。

また、ラックへの給電も建屋の壁からクーリングポッドの屋根を経由して行っている。

次の図は、クーリングポッドの2階の写真である。2階は、電源のブレーカーなどが並び、その後ろ側には冷却水の配管とファンコイルユニットが置かれている。

クーリングポッドの2階に登るはしごは、次の写真のような急こう配の簡易なもので、例えば、修理のために、2階に設置してあるブレーカーの箱を持ってこのはしごを上り下りするのは、かなり大変という印象であった。

Rack CDUの熱交換機で温められた2次冷却水は、室外に設置されたクーリングタワーに送られる。次の写真のように6つのユニットが並んでおり、真夏の最悪の条件でも、この6台のユニットで3.25MWの熱を大気に放熱できる。

取材に伺った時は、気温35℃を超える猛暑日であったが、これは乾球温度であり、蒸発冷却される湿球温度は、湿度が70%の場合で30℃程度である。したがって、この気候でもクーリングタワーで40℃の2次冷却水を32℃まで冷やすことができる。

クーリングタワーは水を上まで運び上げるポンプと、蒸発して湿度の高くなった空気を排除して新しい空気を供給し、蒸発を続けさせるためのファンがあれば良く、コンプレッサーを使って低温の水を作るチラーに比べて非常に低電力で冷却ができる。

-

サーバルームの裏手に設置されたクーリングタワー。工業用のエアコンと同様に、温まった水を表面積を広げた状態で上から下に流し、蒸発させて冷却する。これで、真夏の時期でも3.25MWの熱を放熱することができる

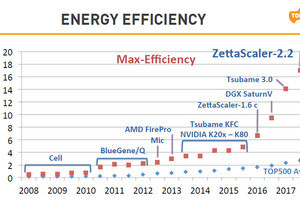

このように、温水冷却で低消費電力のクーリングを行っており、大手データセンター業者のように寒冷地に設置されたデータセンターではないのであるが、総消費電力/IT機器の消費電力の年間平均で計算されるPUE(Power Usage Effectiveness)は1.1を下回ると見込んでいる。