Discordは10月19日(現地時間)、不適切なコンテンツの共有や著作権違反、誹謗中傷といった同サービスの規約に反する行為への対策として、新しい警告システムを導入することを発表した。来週から全世界で展開し始める。また、ティーンエイジャーのユーザーを対象とした安全アシスト機能「Teen Safety Assist」を近日中に提供し始める。

同社によると、サービス規約違反に対して、全面的にアカウントを停止する懲罰的な対処よりも、ユーザーが違反について理解し、反省して行動を改める機会を提供する方がDiscord全体の安全をより保てることが調査で明らかになった。警告システムでも違反に応じて使用できる機能が制限されるが、サービス規約違反について透明性を高め、ユーザーがルールに従ってDiscordを利用していくことをサポートする教育的な効果を重んじた対策になる。

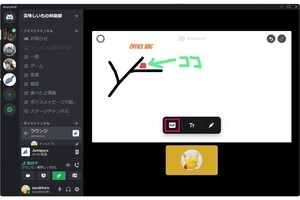

新しい警告システムは、違反の内容とその影響をユーザーに知らせる複数のタッチポイントを含む。まずは違反したユーザーに、Discordから直接アプリ内メッセージで警告または違反に関する通知が届く。そのメッセージから、違反した投稿の詳細、抵触したDiscordポリシーやコミュニティガイドラインの詳細、講じられた措置やアカウント制限の概要などにアクセスできる。さらに、設定に追加される「アカウントの状態」というタブで、ユーザーが過去の違犯に関する情報を1カ所で確認できるようにする。ただし、警告システム導入後も、暴力的な誹謗中傷や児童ポルノなど悪質な違犯に対しては、これまでと同様にゼロ・トレランス・ポリシーで速やかに適切な処置を講じる。

「Teen Safety Assist」はまず、DM(ダイレクトメッセージ)に対する安全アラート機能と、センシティブなコンテンツに対するフィルター機能を提供する。

安全アラートは、初めてのユーザーからDMが送られてきた際にDiscordが安全性を確認し、必要に応じてアラートを表示して返信への注意を促し、またブロック機能やセーフガード機能に関する情報へのリンクを提供する。フィルター機能は、フレンドとのDMやグループDM、サーバー内で、センシティブなコンテンツが検出された際にそれらを自動的にぼかして表示する。これは子どものアクティビティを見守る機能の1つとして保護者が設定することも可能。