今年の「TechFest」で紹介された注目プロジェクト その2

カメラに映し出されたものでコンピューターもしくはデバイスをコントロールするというコンセプトは、「Facing Interaction(フェイシング インタラクション)」という研究プロジェクトである。本来"Facing"は上塗りなどといった意味を持つ単語だが、本プロジェクトにおいては"顔"を表すFaceを進行形に置き換えたものだろう。メンバーの一人であるQin Cai氏はデモンストレーションのなかでディスプレイ上に設置したKinect for Windowsとそれに類似したデバイスの前で、顔の表情を動かすと、コンピューター側がリアルタイムで取り込んだ画像を分析。

その結果としてデバイスの制御やインタラクティブな対応を実現するというものだ。本プロジェクトにはフェローシップ(特別研究員)として、2011年に招かれたUniversity of the Republicの学生であるTomas Laurenzo氏も参加していたが、2013年時点では前述のCai氏とZhengyou Zhang氏の2名がメンバーとして紹介されていた(図13~14)。

|

図13 メンバーの一人であるQin Cai氏自身が「Facing Interaction」のデモンストレーションを行っていた。口を開けて顔を動かすことでディスプレイの上にある各センサーが検知し、ソフトウェア的に割り当てられたイベントサウンドが再生されている |

|

図14 Tomas Laurenzo氏が2012年にデモンストレーションした「Facing Interaction」の原型。やはり顔を動かすことでソフトウェア側で割り当てたイベントが発生する仕組みだった |

Facing Interactionの可能性は無限大に広がり、あらかじめパターンを登録すれば身体障害を持つ方や言語障害を持つ方でも、感覚や感情を周りに対して伝えることができるのではないだろうか。Cai氏が研究に参加した論文や掲載記事を読むと顔の表情だけを抜き出して、解析するロジックの概要が示されている。現時点では発展途上にある研究プロジェクトだが、個人的にはコントローラーというよりもコミュニケーション補助ツールとしての可能性を期待したい。

NUIというジャンルでは「Toward Large-Display Experiences」と題した、大型ディスプレイの活用研究も面白い。研究自体は2000年代半ばから続けられており、技術進歩に伴う大型ディスプレイの低価格化や、それに伴う普及率の向上を踏まえた活用方法などを模索してきた。プロジェクトメンバーの一人であるMichel Pahud(ミシェル・パユ)氏は、「大型ディスプレイもユビキタス(いかなる場面でも恩恵を受けられる技術やインターフェース)の一種」と述べ、大型ディスプレイにペンや直接タッチして操作する利用方法と大型ディスプレイから離れた際にリモートデバイスとしてスマートフォンなどを活用する方法を研究している(図15)。

大型ディスプレイが、まだハイエンドユーザー向けのデバイスとして扱われている日本ではピンと来ないかもしれないが、海外では「10フィートUI」という操作環境が一般的に用いられてきた。文字どおり10フィート=3メートル離れた場所から操作するためのUIで、Windows Media Centerなども10フィートUIを採用したアプリケーションに数えられる。Xbox 360もUIも同じだ。しかし、これらはリモコンや専用コントローラーを使用し、制御しなければならず、ユビキタスデバイスとして使用することはできない。この点を鑑みると本研究プロジェクトの重要性は高いだろう(図16~17)。

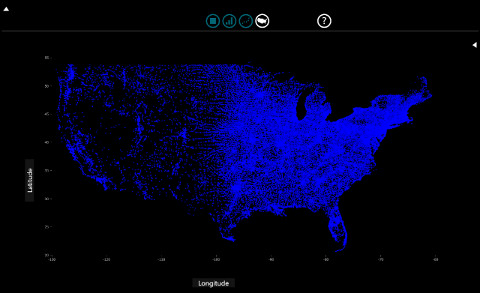

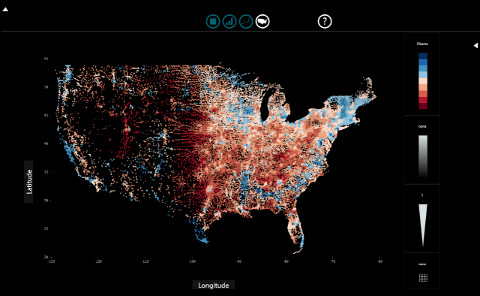

このようにNUIに対するアプローチは数多く、本レポートでは何度も報じているようにKinect for Windowsを軸としたNUIの具現化が行われている。同時にNUIの実現にはビッグデータの扱いが重要であると、Microsoftが考えているのも既報のとおりだ。主任研究員であるSteven Drucker(スティーブン・ドラッカー)氏らが研究しているのが、ビックデータの可視化を行う「SandDance(サンドダンス)」である(図18)。

|

図18 Microsoft Researchの主任研究員であるSteven Drucker(スティーブン・ドラッカー)氏。以前はMITメディアラボで博士号を取り、LiveLabs Resarchグループを率いていた |

収集したビッグデータを視覚化するためにハードウェアアクセラレーションを使用し、Webベースでビッグデータを確認するというシステムだ。任意のデータテーブルに対応し、さまざまなレイアウトを組み合わせることで視覚的に把握しやすいデータを提示することができる。もちろん重要なのはデータであり、プレゼンテーション時に図解表現できるかがポイントとなるが、SandDanceには、今後のOfficeスイートが進化していくヒントが秘められている気がした(図19~21)。

この他にもビッグデータに関する研究プロジェクトは数多くあるが、個人的に興味を持てなかったので今回は割愛する。興味をお持ちの方はプロジェクト一覧ページをご覧頂きたい。このようにMicrosoftの未来を垣間見られるTechFestだが、キーノートでは、Microsoftの副社長兼同研究所の統括責任者であるRichard Rashid(リチャード・ラシッド)氏が講演を行っている。同氏は「ビッグデータやデバイス、サービスがより賢い技術へシフトすべき時代だ」と説明し、Microsoft ResearchにおけるNUI(ナチュラルユーザーインターフェース)やビッグデータに対する研究を集中的に行っているのは紹介してきたとおりだ(図22)。

また、同氏は今後需要が高まるビックデータを活用するため、Microsoft Research Cambridgeの主任研究員であるThore Graepel氏が率いるMachine Learning and Perception(機械学習と知覚)グループは、視覚化や再利用を目指した強力なデータ解析ツールである「Inferno(インフェルノ)」の開発に向けてまい進している。より自然なUIとして具現化しつつあるNUIに関しても、Lee氏が率いるComputational User Experiences(コンピューターのユーザーエクスペリエンス)グループでは、前述したSketchInsightに代表されるNUIの新しい活用方法を次々と発表してきた。常にイノベーション(技術革新)を起こすMicrosoft Researchは、今後も注目すべき存在となるだろう。

阿久津良和(Cactus)