2025年、あらゆる業界でAI技術の導入が広がろうとしている。並行して拡大するAI対応のデータセンターは、ますますその高密度化が加速し、ニーズの変化によって使われる技術も進歩が著しい。このシリーズでは、かつてないほどにデータセンター業界が注目を浴びる今、求められるテクノロジーの変化やトレンドを追ってみたい。今回は、今まさにホットな空調、冷却にまつわるソリューションについて掘り下げる。

AIデータセンターのリファレンスデザインを公開

AI時代は膨大な情報をサーバー間でやり取りするため、独自のネットワークポートとケーブルを使い大量のプロセッサが並列接続される。

さらに、AIサーバーは高密度なクラスター構成で展開されるため、大量の熱を除去するために液体による高効率な冷却設備の設置も必要になってくる。こうした環境では、従来のデータセンターシステムからさまざまなコンポーネントを入れ替える必要があるが、冷却システムなどの設備が変わることによって、データセンターの運用や監視、設計などについても大きく変更されることになる。こうした設計や運用方針にまで及ぶさまざまな変化への対応は、データセンター事業者だけでなく、周辺機器メーカーや建設・設計・運用の請負事業者など、業界に携わるさまざまな関連企業にとってまだまだ未知の領域が多い。従来の技術を使いながら、手探りで対策を検討しつつあるものの、何かベースとなる参考情報を探していた企業も多かったのではないだろうか。

このような大きな変更を鑑み、シュナイダーエレクトリックとNVIDIAはパートナーシップを組み、AI向けのデータセンターの参照設計情報をまとめたリファレンスデザインを作成しWebサイトでオープンにて公開している。

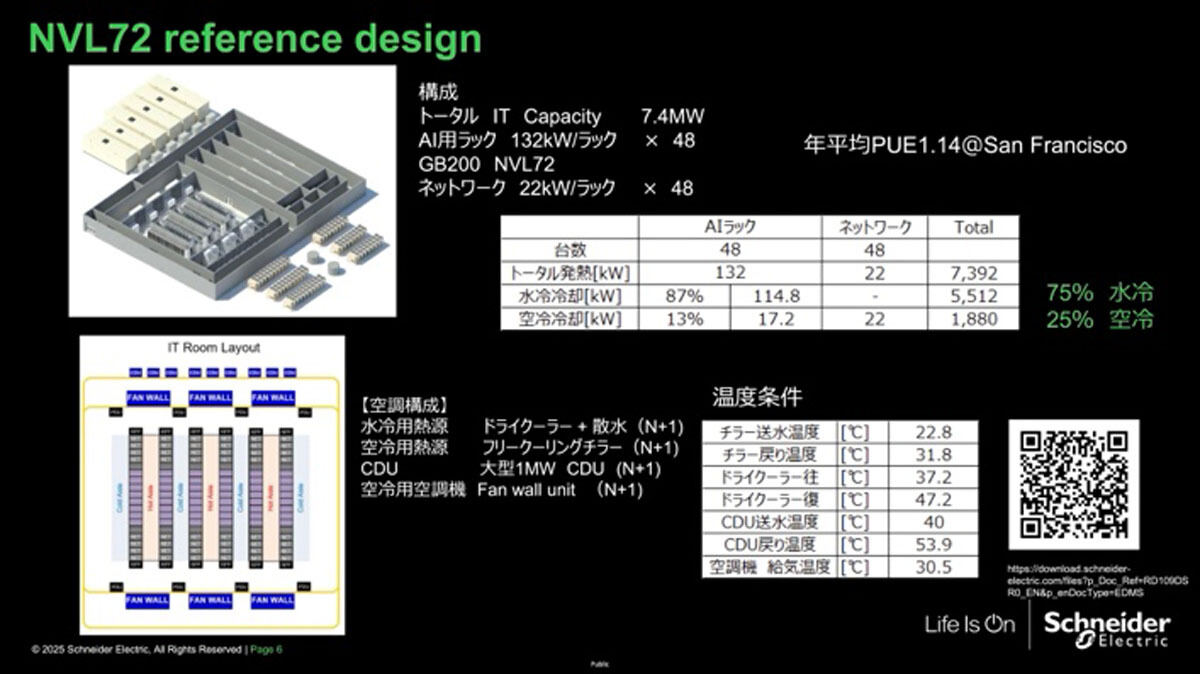

その最新版は、36基のNVIDIA GB200 Superchip(36基の Grace CPU+72基のBlackwell GPU)を1つのラックに統合した「GB200 NVL72」というNVIDIAのシステムに対応している。これはラックあたりの発熱量が132kWになるAIラックを48台と、それらを接続するラックあたりの発熱量が22kWのネットワークラック48台で、トータルのITキャパシティが約7.4MWとなる構成に対応している。

前回、AI用のデータセンターは空気で冷やす限界を迎えつつあり、より高効率な液体での冷却に移行が必要だと紹介したが、高発熱のGPUサーバーとはいっても、すべてを液体で冷やせるというわけではない。

AIラックに関してもネットワークなど空冷で冷やさなければならない部分が残っているため、7.4MWのうち約3/4が液体冷却、約1/4が空冷となる。この構成には、液冷用熱源のドライクーラーや空冷用熱源のフリークーリングチラー(冷却水循環装置)に加え、大型のCDU(Coolant Distribution Unit、冷媒熱交換器)と空冷用空調機のファンウォールユニットなどが採用されるが、個々のユニットの温度条件のデータについても、リファレンスデザインで公開されているので参考になるかと思う。

液体冷却装置の種類

空冷と比較して熱伝導率が23倍以上高い液体冷却装置にも多種の冷却方式があり、現在市場にある技術は大きく分けるとコールドプレートをチップに直接接触させるコールドプレートタイプ(DLC:Direct Liquid Cooling)と、サーバーそのものを液体につけてしまう液浸タイプに二分されている。空気と違って、液体は触れているだけで冷やせるという性質があり、だからこそ空気から液体への移行が進んでいるわけだが、その液体の排熱が必要になる。ここでも熱容量が大きい液体(水)の方が同一体積で比較すると空気よりも約3200倍多くの熱を運べるので、熱を運ぶエネルギーが少なく済むので省エネも可能になり、液体冷却の普及を後押ししている。

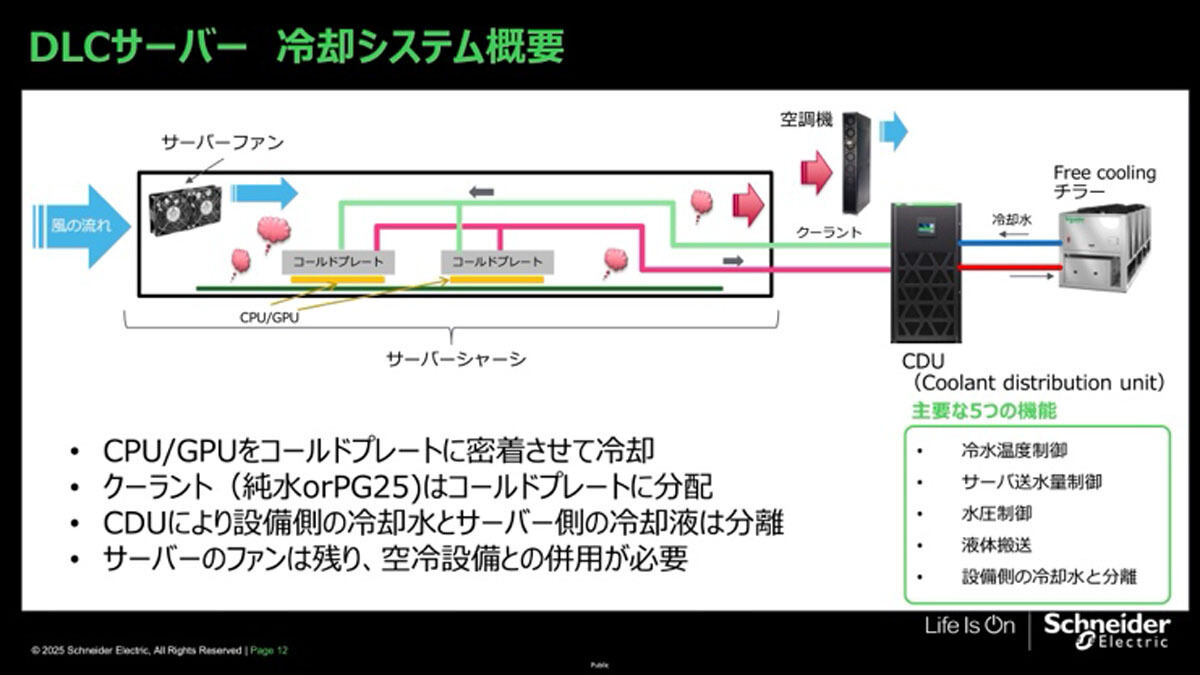

DLCサーバーは、CPUやGPUが接触しているコールドプレートに液配管を接続し、直接冷却液を送って冷やしている。CPUやGPUの熱で温められた冷却液(純水あるいはPG25)は、CDUで排熱され、またコールドプレートに送られるという循環を繰り返している。CDUの内部では、上記冷却液とチラーやその他熱源から送られる冷却水の熱交換が行われている。最終的な排熱はチラー(又はその他熱源)で行われる。

このように、DLCサーバーではコールドプレートが触れているところは液体で冷やすが、それ以外の部分も発熱しているため、ファンで空気を送って空冷する必要がある。したがって、サーバーの87%を液体冷却、13%を空冷で冷やすことになり、データセンター全体で約3/4が水冷、約1/4が空冷になる。

既存設備に応じてさまざまな冷却装置を選択

上で述べたように、DLCサーバーの普及に伴いラックの近くで効率よく空冷を行う装置の需要も高まっている。例えば、サーバーラックの間に置かれるInRow型の局所空調機なら、サーバーから出てきた空気をすぐに冷却できるため、空気を搬送する距離が短くファン動力が小さくなり、電力使用量が削減できるというメリットがある。

局所空調機については、施設の仕様に合わせてさまざまな構成を選択可能だ。既存の空調に冷水設備があるが、サーバールームに水が入れられない場合には、水冷コンデンサとつなげる局所空調機を導入する。サーバールームに水を入れられる場合は、水冷の局所空調機を使う。また、冬の冷たい外気を利用してフリークーリングを行いたい場合には、エコノマイザタイプのフリークーリング機能を持つ局所空調機も選択肢だ。このように、一口にAIなどの高密度コンピューティング用冷却といっても、設備側の条件や敷地面積、立地による環境など、さまざまな要因が関係してくるので、特に既存施設の場合は幅広い選択肢からアプローチを選ぶことになる。

一方、大型のデータセンターには、高効率で大風量のファンウォールという空調設備を設置しているケースが多い。そのような全体空調設備を導入するメリットは設備投資の低減にあるが、導入のためには設計段階からデータセンター全体の冷却キャパシティを考慮して行うことが必要だ。このため、既存のデータセンターの改良や小規模の場合は導入が難しいこともある。ここでInRow型空調機による局所空調とファンウォールのエネルギー効率を比較してみる。例えば、1台あたり400kWの冷却能力を持つファンウォールユニットに対して、30kWの能力しかないInRow型空調機は複数並べないと同程度の能力が得られないが、その設置面積はファンウォールに比べて20%削減できる。ファンウォールと同じ設置面積にInRow型空調機を並べた場合の能力は27.5%アップする。高さについても、ファンウォールユニットは4mくらいあるが、同じ能力分のInRow型空調機の場合、そこまでの高さは必要がないので、天井高を低く押さえたデータセンターの設計や既存のデータセンターへの導入が可能になり、コストも抑えられる。

また、さらにラックにおける空調効率を向上させるために、液体冷却サーバーの入ったラックごと囲ってしまう、コンテイメントシステムもよく採用されている。DLCサーバーと局所装置を一緒に囲ってしまうため、効率的に熱せられた空気を除去できるうえ、周囲に熱気が漏れないので、高密度サーバーを比較的容易に既存環境に置けるようになる。工場など、既存の建物の中に冷却水があれば、チラーレスでの構築も可能になる。

AIサーバ―の拡大に伴う液体冷却技術の革新

液体冷却は高密度のサーバーを冷やすために必須の技術であることは明らかであるが、それに加えて、サステナビリティといった観点からも重要性が増している。

AIデータセンターの電力使用量が増えていく中では、冷却にかかる電力も効率化を考えなければならない。液体のほうが、気体に比べて圧倒的に熱容量が高いため、熱を搬送するための動力も大きく下げられる。このため、データセンターの液冷化が進めば確実に省エネが期待できる。

また、サーバーに送る冷水の温度はできるだけ高い方がエネルギー効率が高い。サーバーに送る水の温度を20℃まで下げるよりも30℃まで下げる方が、はるかに電力を使わない。実際にサーバーは30℃以上でも冷却できるので、冷却媒体の温度を必要以上に下げないことも省エネにつながる。シュナイダーエレクトリックでは、これまでデータセンター業界に一環したファシリティソリューションを提供してきた実績から、こうした冷却に関わるソリューションやサービスによって、消費電力を下げ、サステナブルなデータセンターの構築を包括的にサポートできると考えている。

次回は、AI需要によるGPUサーバ―の高密度化とそれに伴う電力使用量の増加に伴って、重要な課題となりつつあるAI対応データセンターの電力供給と管理について紹介したい。